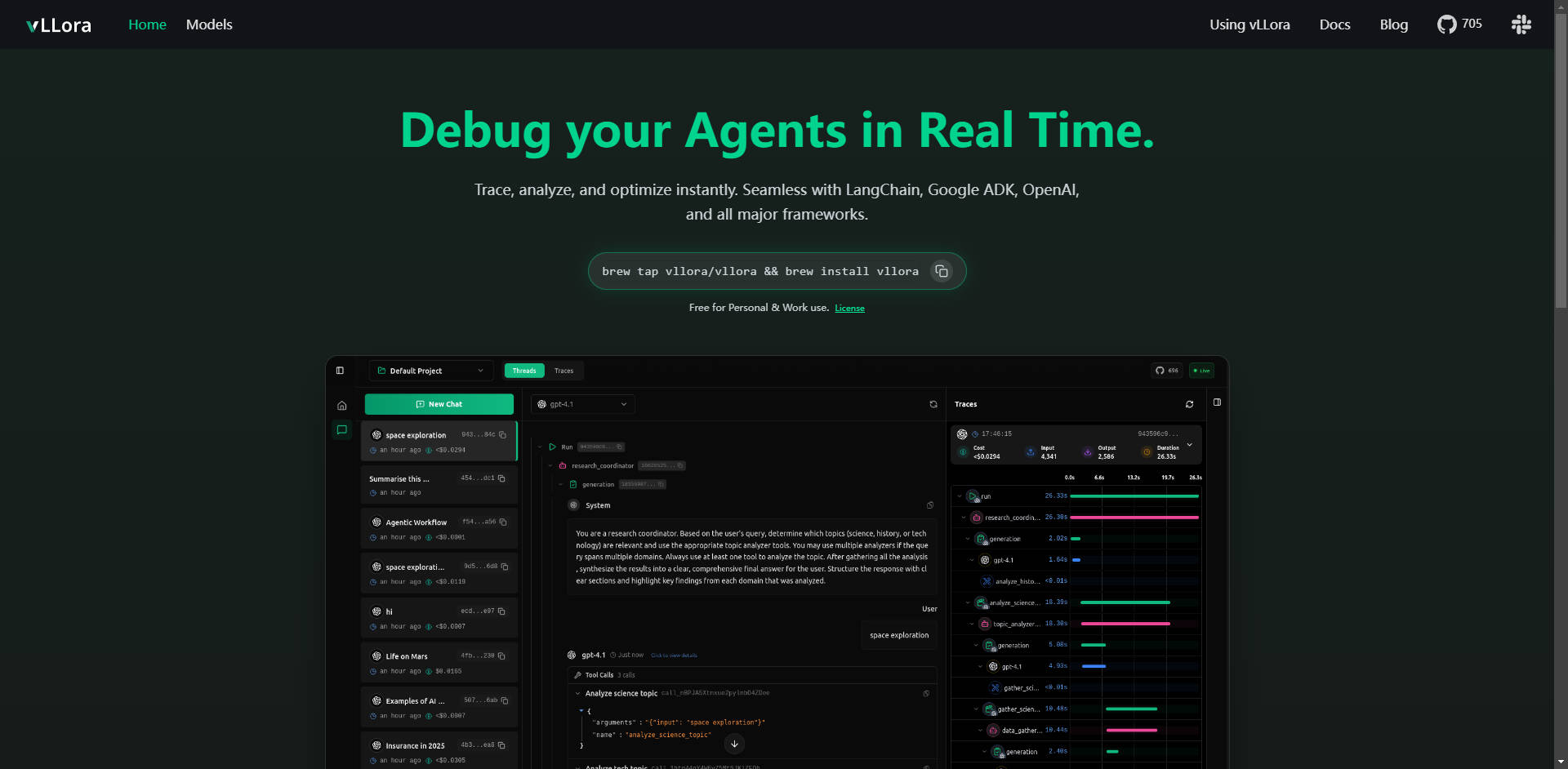

What is vLLora ?

vLLora es la plataforma fundamental y ágil de depuración y observabilidad, diseñada específicamente para gestionar flujos de trabajo complejos de agentes de IA. Aborda de inmediato el desafío crucial de obtener visibilidad en las llamadas multi-paso de LLM, las interacciones con herramientas y la lógica de los agentes. Al integrarse a la perfección con los principales frameworks mediante un endpoint compatible con OpenAI, vLLora permite a los desarrolladores rastrear, analizar y optimizar el rendimiento de los agentes al instante, asegurando así su fiabilidad y eficiencia.

Características Clave

vLLora le proporciona la información detallada y en tiempo real que necesita para llevar sus agentes de IA del desarrollo a la producción con total confianza.

🔍 Trazado en Vivo en Tiempo Real

Supervise las interacciones de sus agentes de IA mientras se ejecutan, obteniendo observabilidad en vivo de todo el flujo de trabajo. Podrá ver exactamente lo que sus agentes están haciendo momento a momento —incluyendo cada llamada a modelo, interacción con herramientas y decisión— lo que le permite identificar errores o comportamientos inesperados en el instante mismo en que ocurren.

☁️ Compatibilidad Universal con Frameworks

vLLora funciona de forma inmediata con su configuración existente, integrándose a la perfección con frameworks líderes de la industria como LangChain, Google ADK y OpenAI Agents SDK. Esta amplia compatibilidad garantiza que pueda implementar una depuración profunda sin necesidad de una refactorización extensa de su código base actual.

📈 Métricas de Observabilidad Profunda

Vaya más allá del simple registro. vLLora recopila automáticamente información crucial sobre el rendimiento, capturando métricas detalladas sobre la latencia, el costo operativo y la salida bruta del modelo para cada paso de la ejecución del agente. Estos datos son vitales para identificar cuellos de botella y optimizar la asignación de recursos.

⚙️ Endpoints Compatibles con OpenAI para una Configuración sin Fricciones

vLLora opera a través de una API de finalización de chat compatible con OpenAI. Al enrutar las llamadas de su agente a través del servidor local de vLLora (http://localhost:9090), la información de trazado y depuración se recopila automáticamente, lo que hace que la integración sea tan sencilla como configurar una nueva URL de endpoint.

🌐 Amplio Soporte de Modelos y Evaluación Comparativa

Traiga sus propias claves API y obtenga acceso instantáneo a más de 300 modelos diferentes. vLLora le permite mezclar, combinar y realizar evaluaciones comparativas de diversos modelos dentro de un único flujo de trabajo de agente, lo que le permite probar rápidamente configuraciones y seleccionar el LLM más eficiente y rentable para tareas específicas.

Casos de Uso

vLLora está diseñado para mejorar la velocidad de desarrollo y la fiabilidad operativa en diversos tipos de agentes complejos:

1. Optimización de Agentes de Codificación y Automatización

Al desarrollar agentes de codificación sofisticados (como Kilocode), la secuencia de llamadas a modelos, la manipulación de archivos y el uso de herramientas externas puede volverse opaca. Con vLLora, puede rastrear la cadena de pensamiento y los pasos de ejecución exactos, asegurándose de que el agente interprete correctamente las instrucciones y utilice sus herramientas de manera eficiente, lo que reduce drásticamente el tiempo de depuración para errores lógicos complejos.

2. Depuración de Agentes de Voz y Conversacionales en Vivo

Para los agentes construidos sobre plataformas en tiempo real como LiveKit, la latencia es primordial. vLLora le permite ver el retraso en tiempo real introducido por cada inferencia del modelo y cada búsqueda de herramienta. Esto le permite aislar los pasos de alta latencia y ajustar las elecciones de modelo o las configuraciones de herramientas para ofrecer una experiencia de usuario más fluida y casi instantánea.

3. Auditoría de Costos y Rendimiento

En entornos de producción, los costos de los agentes pueden escalar rápidamente. Al integrar vLLora, obtiene visibilidad del consumo de tokens y del costo asociado a cada interacción. Esto permite a los equipos imponer restricciones presupuestarias, identificar modelos que son innecesariamente caros para tareas de baja importancia y optimizar la eficiencia operativa a largo plazo.

¿Por Qué Elegir vLLora?

Al evaluar herramientas para el desarrollo de agentes, vLLora ofrece ventajas distintivas centradas en la facilidad de uso, el costo y un soporte integral:

- Integración Nativa a Través de un Estándar API: A diferencia de las soluciones que requieren SDKs propietarios, vLLora utiliza el estándar API de OpenAI, ampliamente adoptado. Esto significa que puede integrar una observabilidad profunda en proyectos maduros sin alterar la lógica central del agente ni emprender esfuerzos de migración complejos.

- Flexibilidad Exhaustiva de Modelos: La capacidad de traer sus propias claves y realizar evaluaciones comparativas de más de 300 modelos de inmediato permite una innovación genuina y una optimización de costos, asegurando que no quede atado al ecosistema de un solo proveedor.

- Licenciamiento Accesible: vLLora está disponible gratuitamente tanto para uso personal como profesional, eliminando las barreras financieras para que equipos de cualquier tamaño puedan adoptar capacidades de depuración y trazado de primera clase.

Conclusión

vLLora ofrece la capa de observabilidad crucial necesaria para construir agentes de IA fiables, rentables y de alto rendimiento. Al proporcionar trazado en tiempo real y métricas detalladas a través de una interfaz sencilla y estandarizada, transforma el proceso de desarrollo de agentes, pasando de una resolución de problemas opaca a una optimización clara e instantánea.

Explore cómo vLLora puede agilizar su flujo de trabajo de desarrollo y aportar claridad a sus proyectos de agentes hoy mismo.