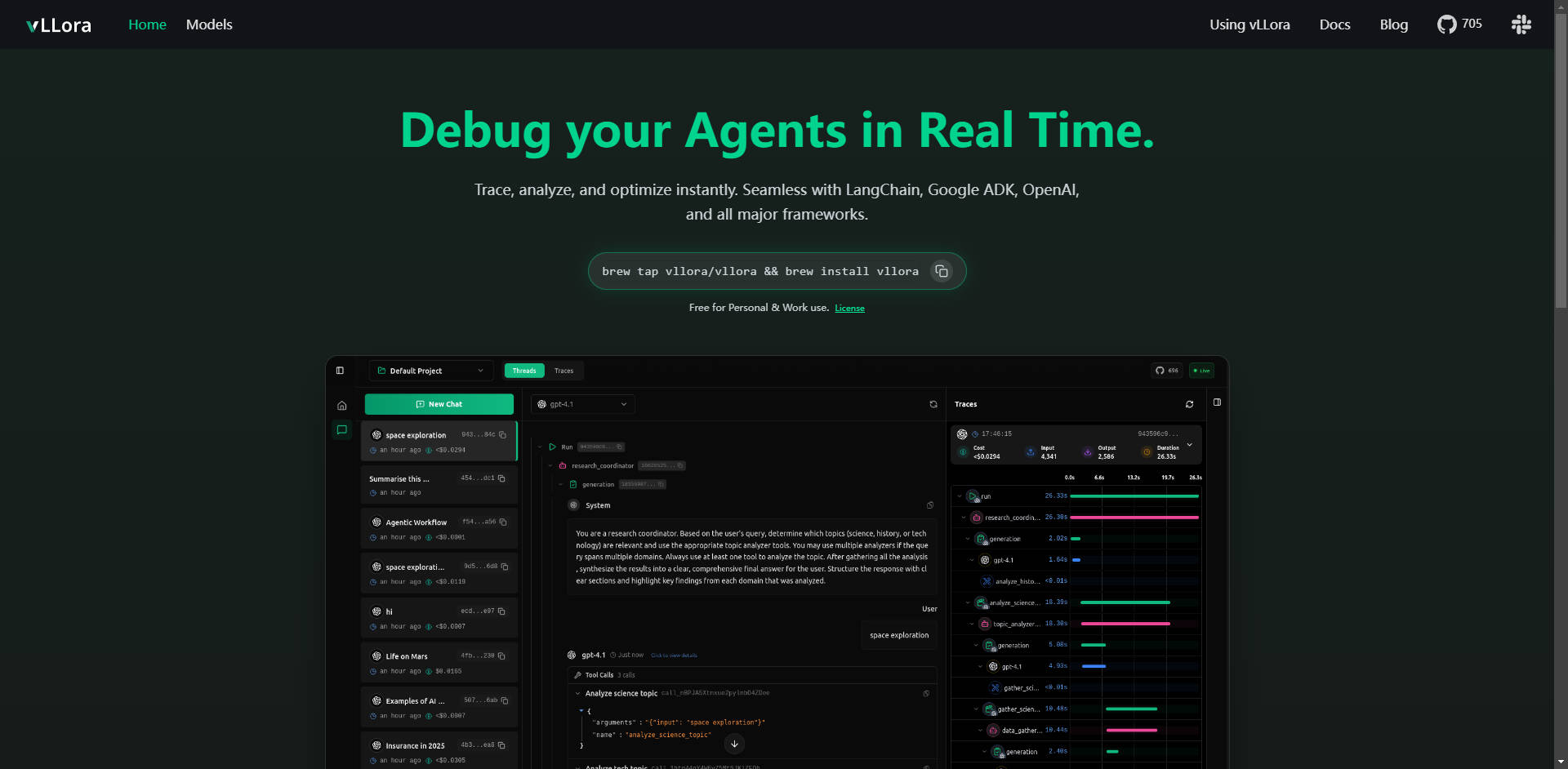

What is vLLora ?

vLLora — это незаменимая, легковесная платформа для отладки и мониторинга, разработанная специально для сложных рабочих процессов ИИ-агентов. Она немедленно решает критически важную задачу обеспечения прозрачности при многошаговых вызовах LLM, взаимодействиях с инструментами и реализации логики агентов. Благодаря бесшовной интеграции с основными фреймворками через конечную точку, совместимую с OpenAI, vLLora позволяет разработчикам мгновенно отслеживать, анализировать и оптимизировать производительность агентов, гарантируя их надежность и эффективность.

Ключевые особенности

vLLora предоставляет глубокую аналитику в реальном времени, необходимую для уверенного перехода ваших ИИ-агентов от разработки к продакшену.

🔍 Трассировка в реальном времени

Отслеживайте взаимодействие ваших ИИ-агентов по мере их выполнения, обеспечивая полный мониторинг всего рабочего процесса в реальном времени. Вы видите в точности, что делают ваши агенты в каждый момент времени — включая каждый вызов модели, взаимодействие с инструментом и каждое принятое решение, — что позволяет мгновенно выявлять ошибки или нежелательное поведение.

☁️ Универсальная совместимость с фреймворками

vLLora работает сразу после установки с вашей существующей инфраструктурой, легко интегрируясь с ведущими отраслевыми фреймворками, такими как LangChain, Google ADK и OpenAI Agents SDK. Такая широкая совместимость гарантирует возможность глубокой отладки без существенной переработки текущей кодовой базы.

📈 Детальные метрики мониторинга

Выходите за рамки простого логирования. vLLora автоматически собирает критически важные данные о производительности, фиксируя подробные метрики по задержкам, эксплуатационным расходам и исходным выходным данным модели для каждого шага выполнения агента. Эти данные жизненно важны для выявления узких мест и оптимизации распределения ресурсов.

⚙️ Конечные точки, совместимые с OpenAI, для беспроблемной настройки

vLLora функционирует через API завершения чата, совместимый с OpenAI. Перенаправляя вызовы вашего агента через локальный сервер vLLora (http://localhost:9090), информация для трассировки и отладки собирается автоматически, что делает интеграцию такой же простой, как настройка нового URL конечной точки.

🌐 Широкая поддержка моделей и бенчмаркинг

Используйте свои собственные API-ключи и мгновенно получите доступ к более чем 300 различным моделям. vLLora позволяет комбинировать, сопоставлять и тестировать различные модели в рамках одного рабочего процесса агента, что дает возможность быстро проверять конфигурации и выбирать наиболее производительные и экономичные LLM для конкретных задач.

Сценарии применения

vLLora разработана для повышения скорости разработки и операционной надежности для различных типов сложных агентов:

1. Оптимизация агентов для кодирования и автоматизации

При разработке сложных агентов для кодирования (например, Kilocode) последовательность вызовов моделей, операций с файлами и использование внешних инструментов может стать непрозрачной. С vLLora вы можете отслеживать точную цепочку рассуждений и шаги выполнения, гарантируя, что агент правильно интерпретирует инструкции и эффективно использует свои инструменты, что значительно сокращает время отладки сложных логических ошибок.

2. Отладка голосовых и разговорных агентов в реальном времени

Для агентов, построенных на платформах реального времени, таких как LiveKit, задержка имеет первостепенное значение. vLLora позволяет увидеть задержку в реальном времени, вызванную каждым выводом модели и обращением к инструменту. Это позволяет изолировать шаги с высокой задержкой и тонко настраивать выбор моделей или конфигурации инструментов для обеспечения более плавного и почти мгновенного взаимодействия с пользователем.

3. Аудит затрат и производительности

В производственных средах затраты на агентов могут быстро расти. Интегрировав vLLora, вы получаете полную информацию о потреблении токенов и связанных с этим затратах на каждое взаимодействие. Это позволяет командам соблюдать бюджетные ограничения, выявлять модели, которые неоправданно дороги для задач низкого приоритета, и оптимизировать долгосрочную операционную эффективность.

Почему стоит выбрать vLLora?

При оценке инструментов для разработки агентов vLLora предлагает явные преимущества, сосредоточенные на простоте использования, стоимости и всесторонней поддержке:

- Нативная интеграция через стандартный API: В отличие от решений, требующих проприетарных SDK, vLLora использует широко распространенный стандарт API OpenAI. Это означает, что вы можете интегрировать глубокую наблюдаемость в зрелые проекты без изменения основной логики агента или трудоемких усилий по миграции.

- Комплексная гибкость моделей: Возможность использовать собственные ключи и немедленно тестировать более 300 моделей способствует подлинным инновациям и оптимизации затрат, гарантируя, что вы не привязаны к экосистеме одного провайдера.

- Доступное лицензирование: vLLora доступна бесплатно как для личного, так и для рабочего использования, устраняя финансовые барьеры для внедрения лучших в своем классе возможностей отладки и трассировки для команд любого размера.

Заключение

vLLora предоставляет важнейший слой наблюдаемости, необходимый для создания надежных, экономически эффективных и высокопроизводительных ИИ-агентов. Предоставляя трассировку в реальном времени и подробные метрики через простой, стандартизированный интерфейс, она превращает процесс разработки агентов из неясного поиска и устранения неполадок в четкую, мгновенную оптимизацию.

Узнайте, как vLLora может оптимизировать ваш процесс разработки и внести ясность в ваши проекты с агентами уже сегодня.