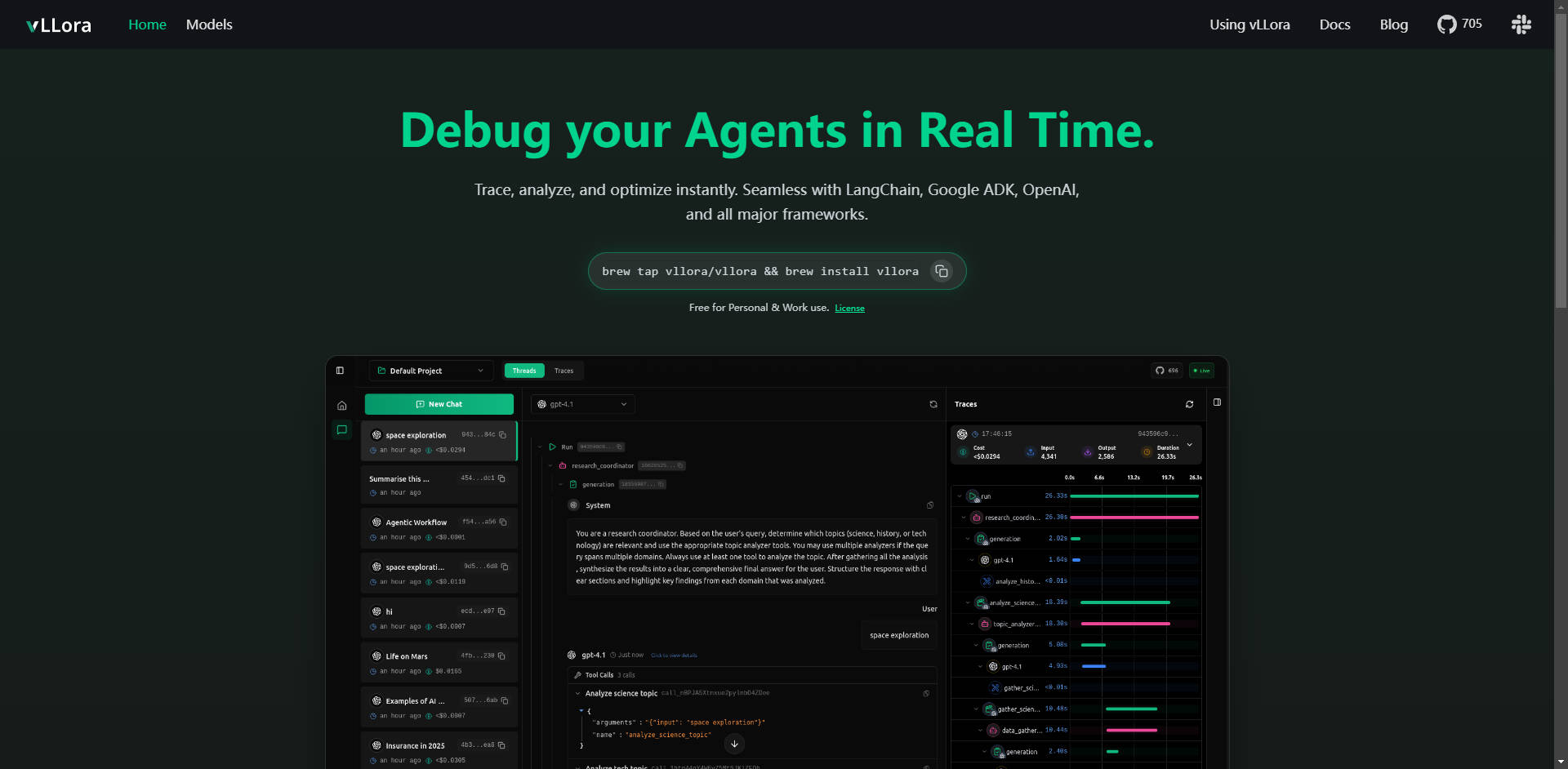

What is vLLora ?

vLLora는 복잡한 AI 에이전트 워크플로우를 위해 특별히 설계된 필수적인 경량 디버깅 및 관측 가능성 플랫폼입니다. 다단계 LLM 호출, 도구 상호 작용 및 에이전트 로직에 대한 가시성 확보라는 중대한 과제를 즉각적으로 해결합니다. OpenAI 호환 엔드포인트를 통해 주요 프레임워크와 원활하게 통합되어 개발자가 에이전트 성능을 즉시 추적, 분석 및 최적화하여 안정성과 효율성을 보장할 수 있도록 지원합니다.

주요 기능

vLLora는 AI 에이전트를 개발 단계에서 프로덕션 단계로 자신 있게 전환하는 데 필요한 심층적인 실시간 통찰력을 제공합니다.

🔍 실시간 라이브 트레이싱

AI 에이전트 상호 작용이 실행되는 동안 모니터링하여 전체 워크플로우에 대한 실시간 관측 가능성을 제공합니다. 모든 모델 호출, 도구 상호 작용 및 결정을 포함하여 에이전트가 순간순간 무엇을 하는지 정확히 볼 수 있으므로 오류나 예기치 않은 동작이 발생하는 즉시 찾아낼 수 있습니다.

☁️ 범용 프레임워크 호환성

vLLora는 기존 설정과 바로 연동되며, **LangChain, Google ADK, OpenAI Agents SDK**와 같은 업계 선두 프레임워크와 원활하게 통합됩니다. 이러한 광범위한 호환성을 통해 현재 코드베이스를 대대적으로 리팩토링할 필요 없이 심층적인 디버깅을 구현할 수 있습니다.

📈 심층 관측 가능성 지표

단순한 로깅을 넘어섭니다. vLLora는 에이전트 실행의 모든 단계에 대해 **지연 시간, 운영 비용 및 원시 모델 출력**에 대한 상세 지표를 캡처하여 성능에 대한 중요한 통찰력을 자동으로 수집합니다. 이 데이터는 병목 현상을 식별하고 리소스 할당을 최적화하는 데 필수적입니다.

⚙️ 마찰 없는 설정을 위한 OpenAI 호환 엔드포인트

vLLora는 OpenAI 호환 채팅 완료 API를 통해 작동합니다. 에이전트의 호출을 vLLora의 로컬 서버(http://localhost:9090)를 통해 라우팅하면 추적 및 디버깅 정보가 자동으로 수집되어 새 엔드포인트 URL을 구성하는 것만큼이나 간단하게 통합할 수 있습니다.

🌐 광범위한 모델 지원 및 벤치마킹

자체 API 키를 가져와 300개 이상의 다양한 모델에 즉시 액세스할 수 있습니다. vLLora를 사용하면 단일 에이전트 워크플로우 내에서 다양한 모델을 혼합, 일치 및 벤치마킹하여 구성을 신속하게 테스트하고 특정 작업에 가장 성능이 좋고 비용 효율적인 LLM을 선택할 수 있습니다.

활용 사례

vLLora는 다양한 복잡한 에이전트 유형 전반에 걸쳐 개발 속도와 운영 안정성을 향상시키기 위해 설계되었습니다.

1. 코딩 및 자동화 에이전트 최적화

정교한 코딩 에이전트(예: Kilocode)를 개발할 때 모델 호출, 파일 조작 및 외부 도구 사용 순서가 불투명해질 수 있습니다. vLLora를 사용하면 에이전트의 정확한 사고 과정과 실행 단계를 추적하여 에이전트가 지시를 올바르게 해석하고 도구를 효율적으로 사용하도록 보장함으로써 복잡한 논리 오류에 대한 디버깅 시간을 획기적으로 단축할 수 있습니다.

2. 라이브 음성 및 대화형 에이전트 디버깅

LiveKit과 같은 실시간 플랫폼을 기반으로 구축된 에이전트의 경우 지연 시간이 매우 중요합니다. vLLora를 사용하면 각 모델 추론 및 도구 조회로 인해 발생하는 실시간 지연을 확인할 수 있습니다. 이를 통해 고지연 단계를 분리하고 모델 선택 또는 도구 구성을 미세 조정하여 더 부드럽고 거의 즉각적인 사용자 경험을 제공할 수 있습니다.

3. 비용 및 성능 감사

프로덕션 환경에서는 에이전트 비용이 빠르게 증가할 수 있습니다. vLLora를 통합하면 모든 상호 작용의 토큰 소비량과 관련 비용에 대한 가시성을 확보할 수 있습니다. 이를 통해 팀은 예산 제약을 적용하고, 중요도가 낮은 작업에 불필요하게 비싼 모델을 식별하며, 장기적인 운영 효율성을 최적화할 수 있습니다.

왜 vLLora를 선택해야 할까요?

에이전트 개발 도구를 평가할 때 vLLora는 사용 편의성, 비용 및 포괄적인 지원을 중심으로 명확한 이점을 제공합니다.

- API 표준을 통한 네이티브 통합: 독점 SDK를 요구하는 솔루션과 달리 vLLora는 널리 채택된 OpenAI API 표준을 사용합니다. 이는 핵심 에이전트 로직을 변경하거나 번거로운 마이그레이션 작업을 수행할 필요 없이 성숙한 프로젝트에 심층적인 관측 가능성을 통합할 수 있음을 의미합니다.

- 포괄적인 모델 유연성: 자체 키를 가져와 300개 이상의 모델을 즉시 벤치마킹할 수 있는 기능은 진정한 혁신과 비용 최적화를 가능하게 하며, 단일 공급업체의 생태계에 갇히지 않도록 보장합니다.

- 접근성 높은 라이선스: vLLora는 **개인 및 업무 용도로 모두 무료**로 제공되어, 모든 규모의 팀이 동급 최고의 디버깅 및 추적 기능을 채택하는 데 있어 재정적 장벽을 제거합니다.

결론

vLLora는 안정적이고 비용 효율적이며 고성능 AI 에이전트를 구축하는 데 필요한 중요한 관측 가능성 레이어를 제공합니다. 간단하고 표준화된 인터페이스를 통해 실시간 추적 및 심층 지표를 제공함으로써, 불투명했던 에이전트 개발 프로세스를 명확하고 즉각적인 최적화 과정으로 변화시킵니다.

vLLora가 오늘날 귀사의 개발 워크플로우를 간소화하고 에이전트 프로젝트에 명확성을 가져다줄 수 있는 방법을 알아보세요.