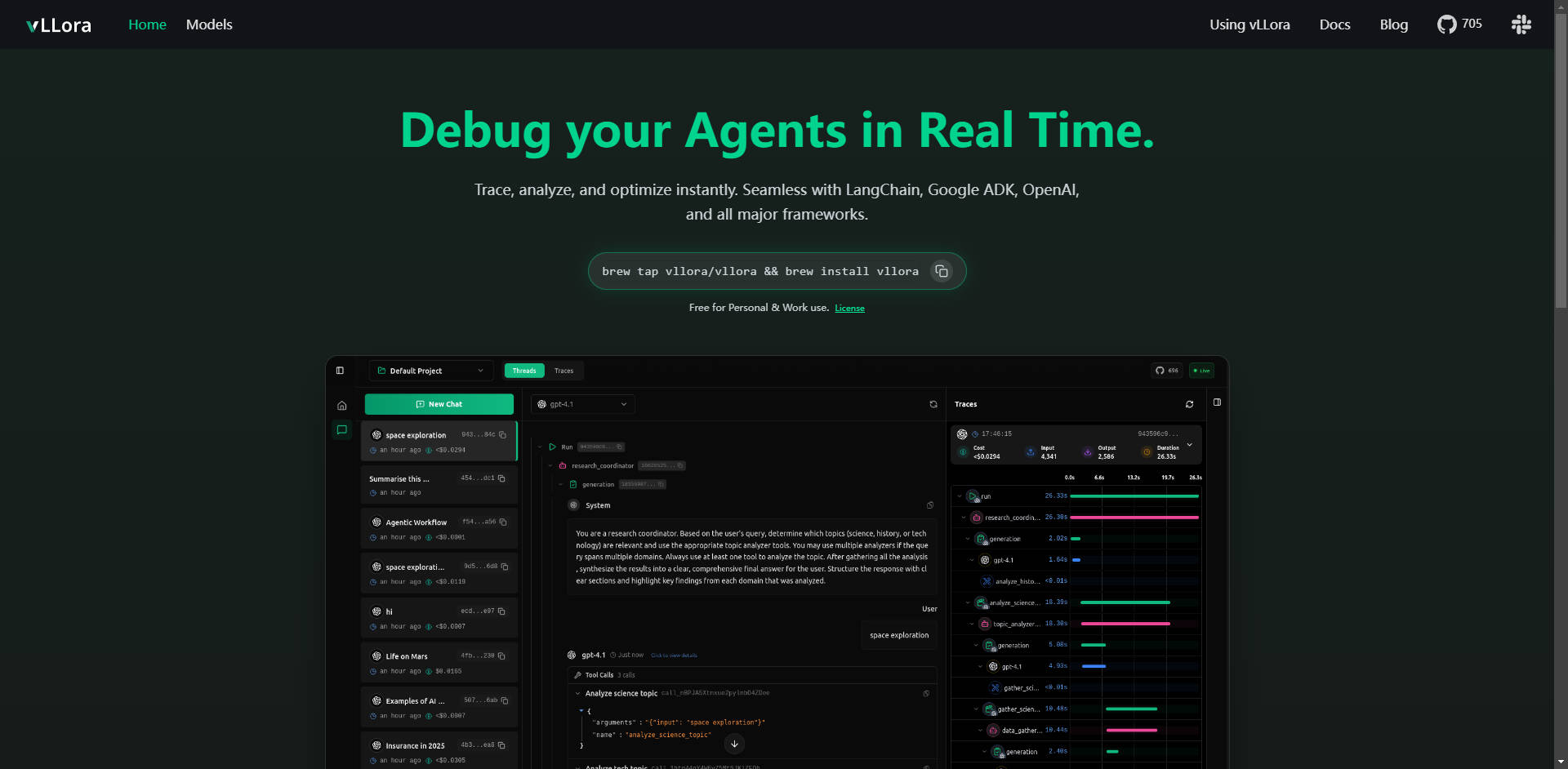

What is vLLora ?

vLLora est la plateforme essentielle, légère, de débogage et d'observabilité, conçue spécifiquement pour les flux de travail complexes des agents IA. Elle résout immédiatement le défi crucial d'obtenir une visibilité sur les appels LLM multi-étapes, les interactions avec les outils et la logique des agents. En s'intégrant de manière transparente aux principaux frameworks via un point d'accès compatible OpenAI, vLLora permet aux développeurs de tracer, d'analyser et d'optimiser instantanément les performances des agents, garantissant ainsi fiabilité et efficacité.

Fonctionnalités Clés

vLLora fournit les informations approfondies et en temps réel dont vous avez besoin pour faire passer vos agents IA du développement à la production en toute confiance.

🔍 Traçage en Temps Réel

Surveillez les interactions de vos agents IA pendant leur exécution, offrant une observabilité en direct de l'ensemble du flux de travail. Vous voyez précisément ce que vos agents font, instant après instant – y compris chaque appel de modèle, interaction avec un outil et décision – vous permettant d'identifier les erreurs ou les comportements inattendus dès qu'ils se produisent.

☁️ Compatibilité Universelle avec les Frameworks

vLLora fonctionne immédiatement avec votre configuration existante, s'intégrant de manière transparente avec des frameworks leaders de l'industrie comme LangChain, Google ADK, et OpenAI Agents SDK. Cette large compatibilité garantit que vous pouvez implémenter un débogage approfondi sans refactorisation extensive de votre base de code actuelle.

📈 Métriques d'Observabilité Approfondies

Allez au-delà de la simple journalisation. vLLora collecte automatiquement des informations cruciales sur les performances, capturant des métriques détaillées sur la latence, le coût opérationnel et la sortie brute du modèle pour chaque étape de l'exécution de l'agent. Ces données sont vitales pour identifier les goulots d'étranglement et optimiser l'allocation des ressources.

⚙️ Points d'Accès Compatibles OpenAI pour une Configuration sans Effort

vLLora fonctionne via une API de complétion de chat compatible OpenAI. En acheminant les appels de votre agent via le serveur local de vLLora (http://localhost:9090), les informations de traçage et de débogage sont collectées automatiquement, rendant l'intégration aussi simple que la configuration d'une nouvelle URL de point d'accès.

🌐 Support Étendu des Modèles et Benchmarking

Utilisez vos propres clés API et accédez instantanément à plus de 300 modèles différents. vLLora vous permet de combiner, de confronter et d'évaluer divers modèles au sein d'un même flux de travail d'agent, vous permettant de tester rapidement les configurations et de sélectionner le LLM le plus performant et le plus rentable pour des tâches spécifiques.

Cas d'Usage

vLLora est conçu pour améliorer la vitesse de développement et la fiabilité opérationnelle à travers divers types d'agents complexes :

1. Optimisation des Agents de Codage et d'Automatisation

Lors du développement d'agents de codage sophistiqués (comme Kilocode), la séquence des appels de modèle, la manipulation de fichiers et l'utilisation d'outils externes peuvent devenir opaques. Avec vLLora, vous pouvez suivre la chaîne de pensée exacte et les étapes d'exécution, garantissant que l'agent interprète correctement les instructions et utilise ses outils efficacement, réduisant considérablement le temps de débogage des erreurs logiques complexes.

2. Débogage d'Agents Vocaux et Conversationnels en Direct

Pour les agents construits sur des plateformes en temps réel comme LiveKit, la latence est primordiale. vLLora vous permet de visualiser le délai en temps réel introduit par chaque inférence de modèle et recherche d'outil. Cela vous permet d'isoler les étapes à forte latence et d'affiner les choix de modèles ou les configurations d'outils pour offrir une expérience utilisateur plus fluide et quasi instantanée.

3. Audit des Coûts et des Performances

Dans les environnements de production, les coûts des agents peuvent rapidement augmenter. En intégrant vLLora, vous obtenez une visibilité sur la consommation de jetons et le coût associé de chaque interaction. Cela permet aux équipes d'appliquer des contraintes budgétaires, d'identifier les modèles inutilement coûteux pour des tâches à faible enjeu, et d'optimiser l'efficacité opérationnelle à long terme.

Pourquoi Choisir vLLora ?

Lors de l'évaluation des outils pour le développement d'agents, vLLora offre des avantages distincts axés sur la facilité d'utilisation, le coût et un support complet :

- Intégration Native via un Standard API : Contrairement aux solutions nécessitant des SDK propriétaires, vLLora utilise le standard API OpenAI largement adopté. Cela signifie que vous pouvez intégrer une observabilité approfondie dans des projets matures sans altérer la logique de base des agents ni entreprendre des efforts de migration pénibles.

- Flexibilité Complète des Modèles : La possibilité d'utiliser vos propres clés et d'évaluer immédiatement plus de 300 modèles permet une véritable innovation et une optimisation des coûts, vous assurant de ne pas être enfermé dans l'écosystème d'un seul fournisseur.

- Licence Accessible : vLLora est disponible gratuitement pour une utilisation personnelle et professionnelle, levant ainsi les barrières financières à l'adoption des meilleures capacités de débogage et de traçage pour les équipes de toute taille.

Conclusion

vLLora fournit la couche d'observabilité cruciale requise pour construire des agents IA fiables, rentables et performants. En offrant un traçage en temps réel et des métriques approfondies via une interface simple et standardisée, il transforme le processus de développement d'agents, passant d'un dépannage opaque à une optimisation claire et instantanée.

Découvrez comment vLLora peut rationaliser votre flux de travail de développement et apporter de la clarté à vos projets d'agents dès aujourd'hui.