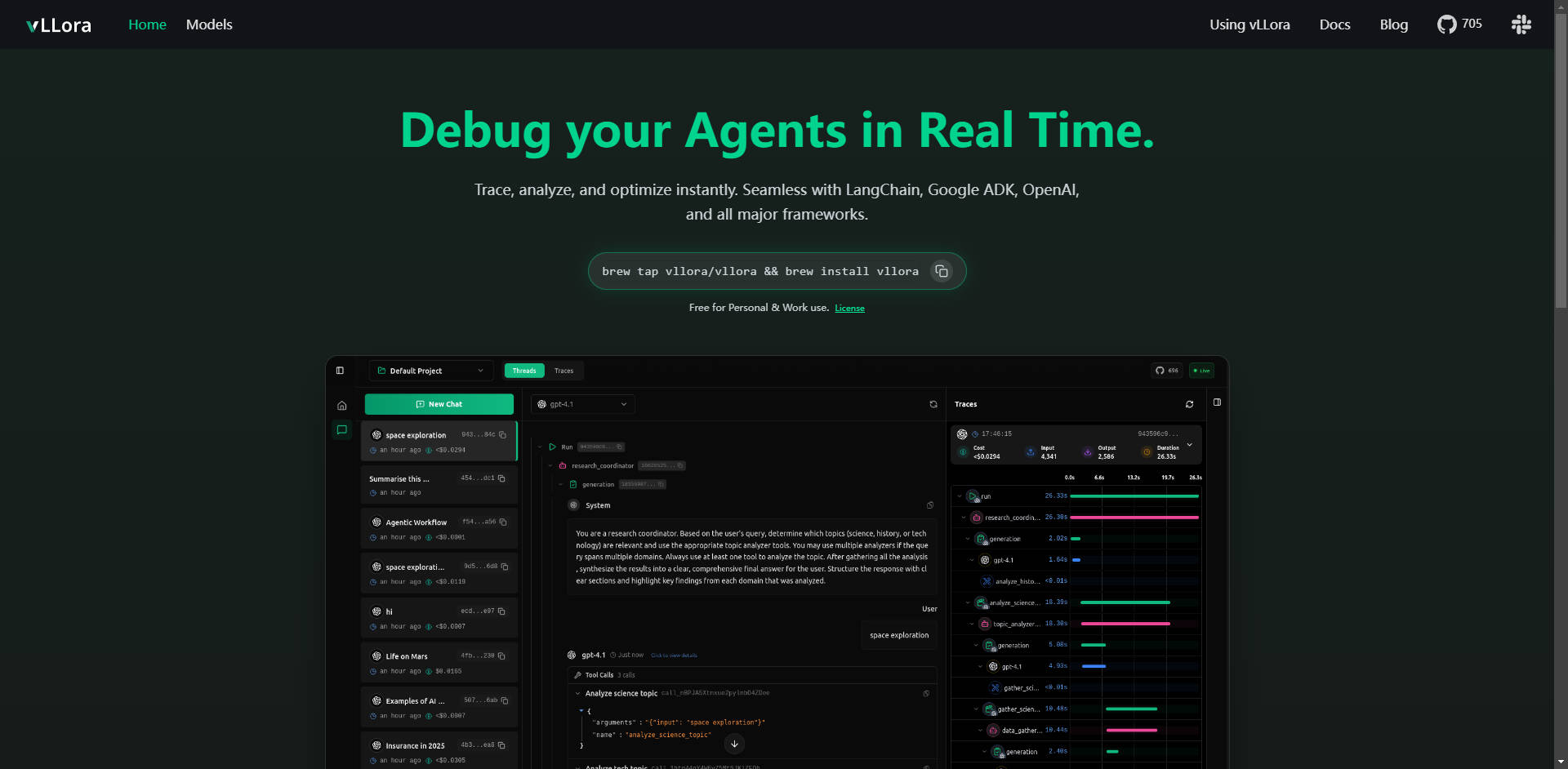

What is vLLora ?

vLLora 是一個專為複雜 AI 代理工作流程設計,不可或缺的輕量級除錯與可觀察性平台。它能即時解決關鍵挑戰,讓您能深入了解多步驟 LLM 呼叫、工具互動及代理邏輯。透過與主要框架的 OpenAI 相容端點無縫整合,vLLora 賦能開發人員即時追蹤、分析並最佳化代理效能,確保其可靠性和效率。

主要特色

vLLora 提供您所需的深度即時洞察,讓您的 AI 代理能自信地從開發階段邁向生產環境。

🔍 即時動態追蹤

監控 AI 代理執行時的互動,為整個工作流程提供即時可觀察性。您可以精準掌握代理分秒之間的每一個動作,包括每次模型呼叫、工具互動和決策,讓您在錯誤或非預期行為發生的第一時間就能精準找出問題。

☁️ 普遍的框架相容性

vLLora 開箱即用,可直接與您現有的設定搭配使用,並與 LangChain、Google ADK 和 OpenAI Agents SDK 等業界領先的框架無縫整合。這種廣泛的相容性確保您無需對現有程式碼庫進行大量重構,即可實現深度除錯。

📈 深度可觀察性指標

超越簡單的日誌記錄。vLLora 自動收集關鍵效能洞察,捕捉代理執行每個步驟的詳細指標,包括延遲、營運成本和原始模型輸出。這些數據對於識別瓶頸和最佳化資源配置至關重要。

⚙️ OpenAI 相容端點,實現零摩擦設定

vLLora 透過 OpenAI 相容的聊天完成 API 運作。透過將代理的呼叫路由至 vLLora 的本地伺服器(http://localhost:9090),追蹤和除錯資訊會自動收集,讓整合就像配置新的端點 URL 一樣簡單。

🌐 廣泛的模型支援與基準測試

攜帶您自己的 API 金鑰,即可立即存取超過 300 種不同的模型。vLLora 讓您可以在單一代理工作流程中混合、搭配並進行各種模型的基準測試,從而能夠快速測試配置並為特定任務選擇效能最佳、成本效益最高的 LLM。

應用案例

vLLora 旨在提升各種複雜代理類型的開發速度和營運可靠性:

1. 最佳化程式碼生成與自動化代理

在開發複雜的程式碼生成代理(例如 Kilocode)時,模型呼叫、檔案操作和外部工具使用的順序可能會變得不透明。透過 vLLora,您可以追蹤確切的思維鏈和執行步驟,確保代理正確解釋指令並有效使用其工具,大幅減少複雜邏輯錯誤的除錯時間。

2. 除錯即時語音與對話代理

對於基於 LiveKit 等即時平台建構的代理,延遲至關重要。vLLora 讓您可以看到每個模型推斷和工具查詢所造成的即時延遲。這使您能夠隔離高延遲步驟,並微調模型選擇或工具配置,以提供更流暢、幾乎即時的使用者體驗。

3. 成本與效能稽核

在生產環境中,代理成本可能會迅速增加。透過整合 vLLora,您可以清楚了解每一次互動的 Token 消耗和相關成本。這讓團隊能夠強制執行預算限制,識別對於重要性不高的任務而言不必要昂貴的模型,並最佳化長期營運效率。

為何選擇 vLLora?

在評估代理開發工具時,vLLora 提供了獨特的優勢,核心圍繞著易用性、成本和全面支援:

- 透過 API 標準進行原生整合: 不同於需要專有 SDK 的解決方案,vLLora 使用廣泛採用的 OpenAI API 標準。這表示您可以將深度可觀察性整合到成熟專案中,無需更改核心代理邏輯或進行繁瑣的遷移工作。

- 全面的模型彈性: 能夠攜帶您自己的金鑰並立即對 300 多種模型進行基準測試,實現了真正的創新和成本最佳化,確保您不會被鎖定在單一供應商的生態系統中。

- 易於取得的授權: vLLora 對個人和工作用途均可免費使用,消除了任何規模團隊採用一流除錯和追蹤能力的財務障礙。

結論

vLLora 提供建構可靠、具成本效益且高效能 AI 代理所需的關鍵可觀察性層。透過簡單、標準化的介面提供即時追蹤和深度指標,它將代理開發過程從不透明的故障排除轉變為清晰、即時的最佳化。

立即探索 vLLora 如何簡化您的開發工作流程,並為您的代理專案帶來清晰度。