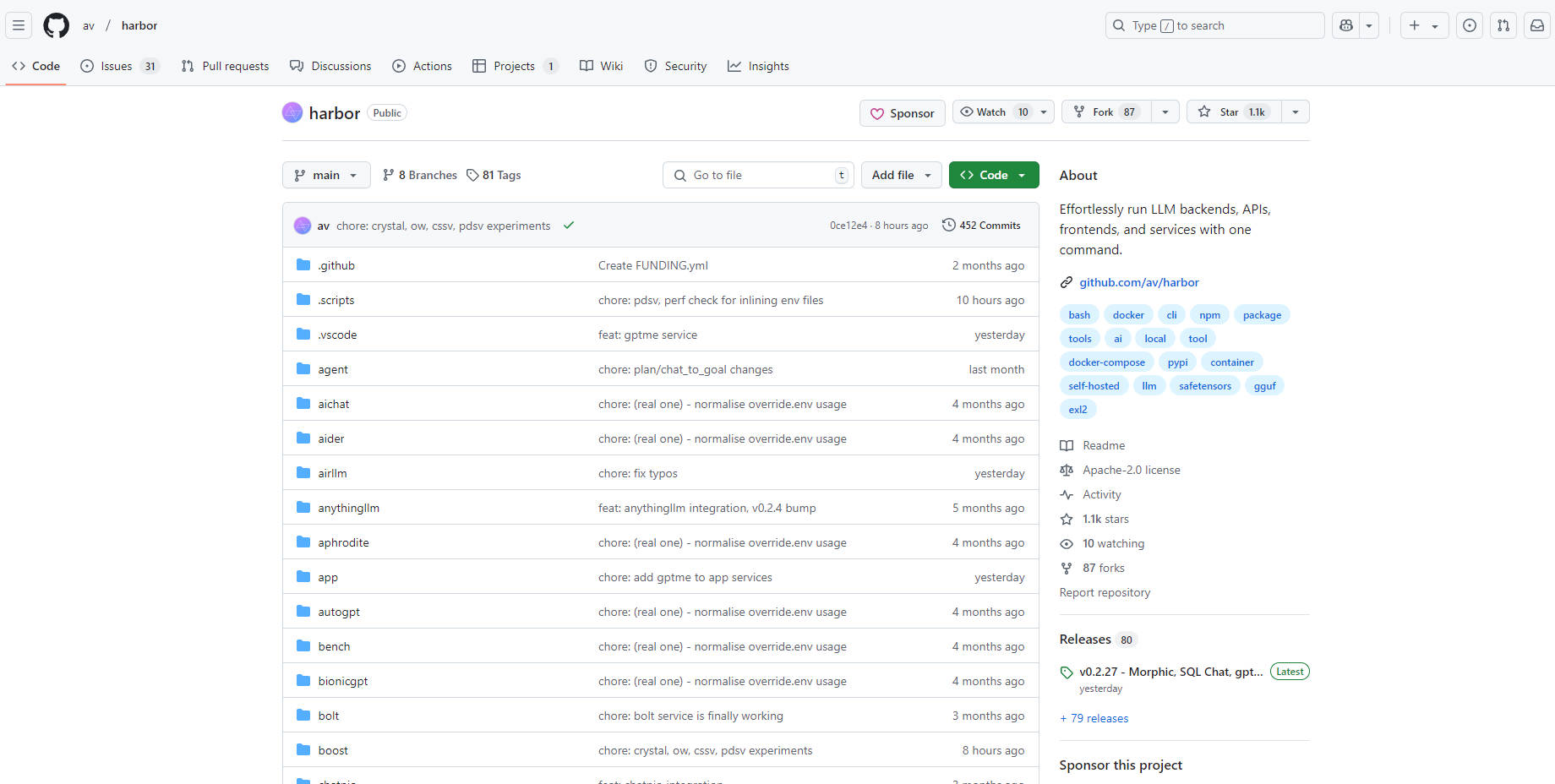

What is Harbor?

Vous êtes-vous déjà senti submergé par la configuration et la gestion des différents éléments de votre environnement de développement d'IA local ? Jongler avec les modèles de langage, les API, les interfaces utilisateur... cela peut être un véritable casse-tête. Harbor est une boîte à outils LLM conteneurisée, conçue pour éliminer cette complexité. Elle vous permet, à vous, le développeur, de vous concentrer sur la création d'applications d'IA exceptionnelles au lieu de lutter avec les configurations. Considérez-la comme votre guichet unique pour exécuter et gérer sans effort tous vos outils LLM, directement depuis votre machine locale.

Fonctionnalités clés :

🚀 Lancez instantanément des piles LLM complètes : Utilisez une seule commande (

harbor up) pour déployer un environnement entièrement fonctionnel, comprenant des IU populaires comme Open WebUI et des backends comme Ollama. Avantage : Vous gagnez des heures de configuration et pouvez commencer à expérimenter avec vos modèles immédiatement.🤝 Connectez les services de manière transparente : Harbor configure automatiquement les services pour qu'ils fonctionnent ensemble. Par exemple, le lancement de SearXNG active instantanément Web RAG dans Open WebUI. Avantage : Vous évitez les cauchemars de configuration manuelle et vous vous assurez que vos outils s'intègrent parfaitement.

🎛️ Personnalisez votre environnement : Ajoutez ou échangez facilement des composants. Besoin d'un backend d'inférence différent ? Essayez

harbor up llamacpp tgi litellm. Vous voulez une IU différente ?harbor up librechat chatui. Avantage : Vous avez la flexibilité d'adapter votre configuration aux besoins spécifiques de votre projet, sans être enfermé dans une structure rigide.📁 Simplifiez la gestion des modèles : Utilisez des commandes pratiques comme

harbor llamacpp model https://huggingface.co/user/repo/model.ggufpour télécharger et gérer les modèles depuis Hugging Face. Avantage : Passez moins de temps à chercher des modèles et plus de temps à les utiliser. Le cache partagé entre les services minimise les téléchargements redondants.💻 Accès CLI unifié : Gérez les services et les configurations, et utilisez même directement les CLI des services (comme

hfouollama) sans installations séparées. Avantage : Rationalise les flux de travail en fournissant un point de contrôle unique, réduisant ainsi les changements de contexte et les frais généraux d'installation.✨Améliorez les performances de LLM : Avec une simple commande 'harbor up boost'. Avantage : Améliorez la qualité des sorties de votre LLM.

Cas d'utilisation :

Prototypage rapide : Vous êtes un chercheur en IA qui explore un nouveau concept. Avec Harbor, vous pouvez rapidement mettre en place un environnement complet avec un backend LLM choisi, une interface conviviale et même un moteur de recherche pour RAG, le tout en quelques minutes. Cela vous permet de tester vos idées rapidement et d'itérer plus vite.

Développement et test locaux : Vous développez une application de chatbot. Harbor vous permet de développer et de tester votre application entièrement en local, sans dépendre d'API externes ou de services cloud. Vous pouvez facilement basculer entre différents LLM pour comparer leurs performances et affiner vos invites.

Apprentissage et expérimentation : Vous êtes novice dans le monde des LLM et vous souhaitez expérimenter différents outils et modèles. Harbor fournit un environnement sandbox sûr et pratique, vous permettant d'explorer les capacités de divers services sans les tracas des installations et configurations complexes.

Conclusion :

Harbor élimine les difficultés du développement LLM local. Il fournit un environnement rationalisé, convivial et hautement configurable qui vous permet de vous concentrer sur l'innovation, et non sur l'infrastructure. Que vous soyez un expert en IA chevronné ou que vous débutiez votre parcours, Harbor offre un moyen plus simple, plus rapide et plus agréable de créer et d'expérimenter avec les LLM. Il offre de la flexibilité et une manière conviviale de gérer le monde complexe du développement LLM local.

More information on Harbor

Harbor Alternatives

Plus Alternatives-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.

-

-

-

LLxprt Code : CLI d'IA universelle pour les LLM multi-modèles. Accédez à Google, OpenAI, Anthropic et à bien d'autres services, directement depuis votre terminal. Boostez le codage, le débogage et l'automatisation.

-