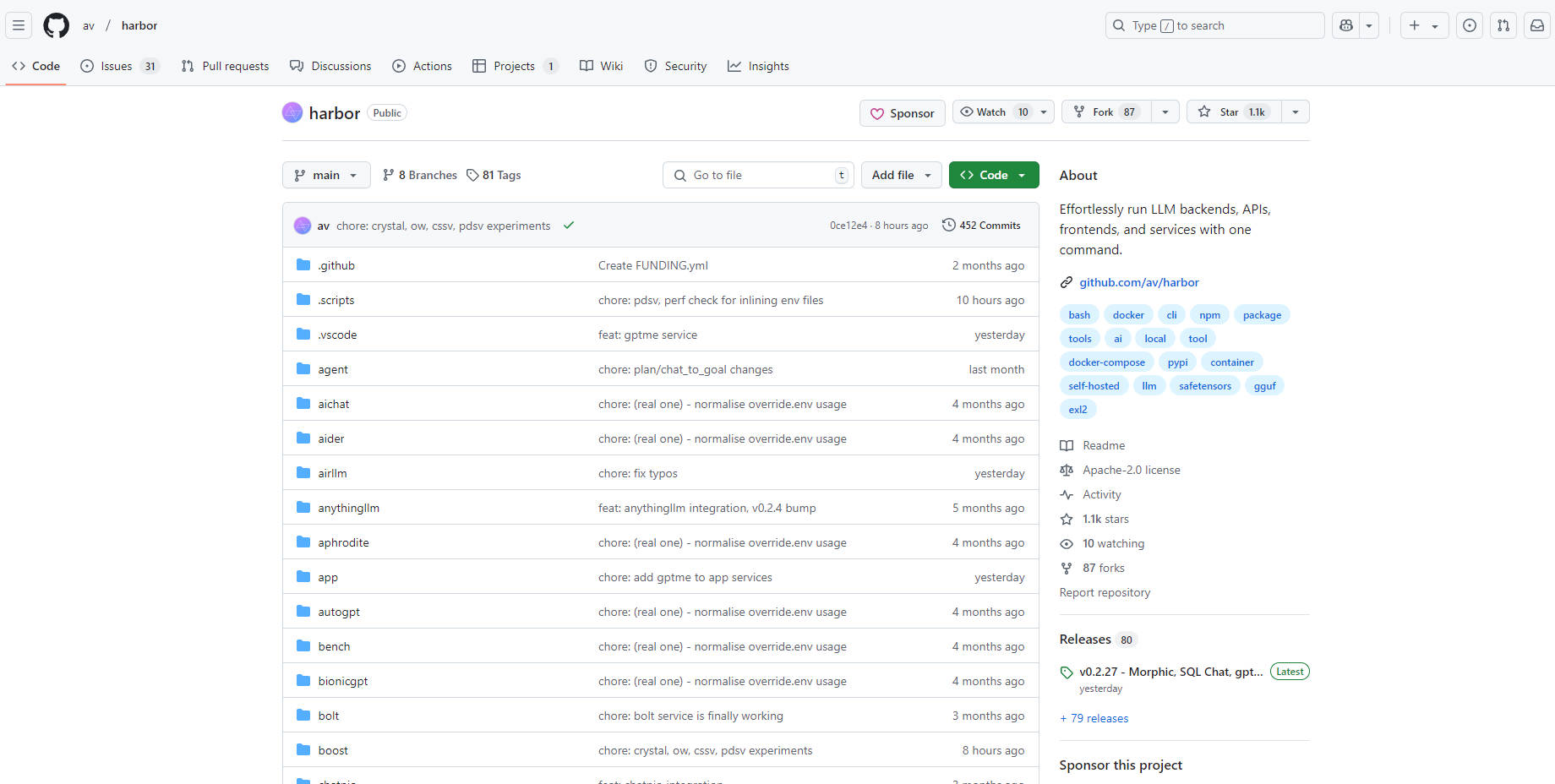

What is Harbor?

ローカルでのAI開発環境の構築や管理に、煩雑さを感じたことはありませんか?言語モデル、API、ユーザーインターフェースなどをやりくりするのは、本当に頭痛の種です。Harborは、そうした複雑さを解消するために設計された、コンテナ化されたLLMツールキットです。開発者であるあなたが、設定に苦労することなく、素晴らしいAIアプリケーションの構築に集中できるようにします。Harborは、ローカルマシンからすべてのLLMツールを簡単に実行および管理できる、ワンストップショップとしてお考えください。

主な機能:

🚀 完全なLLMスタックを瞬時に起動:単一のコマンド(

harbor up)を使用するだけで、Open WebUIのような人気のあるUIや、Ollamaのようなバックエンドを含む、完全に機能する環境を立ち上げることができます。利点:設定時間を大幅に節約し、すぐにモデルの実験を開始できます。🤝 サービスをシームレスに接続:Harborは、サービスが連携するように自動的に構成します。たとえば、SearXNGを起動すると、Open WebUIでWeb RAGがすぐに有効になります。利点:手動での設定という悪夢を回避し、ツールが完璧に統合されるようにします。

🎛️ 環境をカスタマイズ:コンポーネントの追加や交換が簡単に行えます。別の推論バックエンドが必要ですか?

harbor up llamacpp tgi litellmを試してみてください。別のUIが必要ですか?harbor up librechat chatuiを実行してください。利点:厳格な構造に縛られることなく、特定のプロジェクトのニーズに合わせてセットアップを柔軟に調整できます。📁 モデル管理を簡素化:

harbor llamacpp model https://huggingface.co/user/repo/model.ggufのような便利なコマンドを使用して、Hugging Faceからモデルをダウンロードして管理します。利点:モデルを探す時間を減らし、モデルを使用する時間を増やします。サービス間でキャッシュを共有することで、冗長なダウンロードを最小限に抑えます。💻 統合されたCLIアクセス:サービスと構成を管理し、個別のインストールなしで、サービスCLI(

hfやollamaなど)を直接利用することもできます。利点:単一の制御ポイントを提供し、コンテキストの切り替えやインストールのオーバーヘッドを削減することで、ワークフローを効率化します。✨LLMパフォーマンスの向上:簡単な「harbor up boost」コマンドを使用します。利点:LLM出力の品質を向上させます。

ユースケース:

迅速なプロトタイピング:あなたは新しいコンセプトを模索しているAI研究者です。Harborを使用すると、選択したLLMバックエンド、ユーザーフレンドリーなインターフェース、さらにはRAG用の検索エンジンを備えた完全な環境を、ほんの数分でセットアップできます。これにより、アイデアを迅速にテストし、より速く反復することができます。

ローカルでの開発とテスト:あなたはチャットボットアプリケーションを構築しています。Harborを使用すると、外部APIやクラウドサービスに依存せずに、アプリケーションを完全にローカルで開発およびテストできます。さまざまなLLMを簡単に切り替えて、パフォーマンスを比較し、プロンプトを微調整できます。

学習と実験:あなたはLLMの世界に足を踏み入れたばかりで、さまざまなツールやモデルを試してみたいと考えています。Harborは、安全で便利なサンドボックス環境を提供し、複雑なインストールや構成の手間をかけずに、さまざまなサービスの機能を探索できます。

結論:

Harborは、ローカルでのLLM開発の苦痛を取り除きます。合理化された、ユーザーフレンドリーで、高度に構成可能な環境を提供し、インフラストラクチャではなく、イノベーションに集中できるようにします。あなたが経験豊富なAIの専門家であろうと、始めたばかりであろうと、HarborはLLMを構築および実験するための、よりシンプルで、より高速で、より楽しい方法を提供します。柔軟性を提供し、ローカルでのLLM開発という複雑な世界を、ユーザーフレンドリーな方法で処理できます。