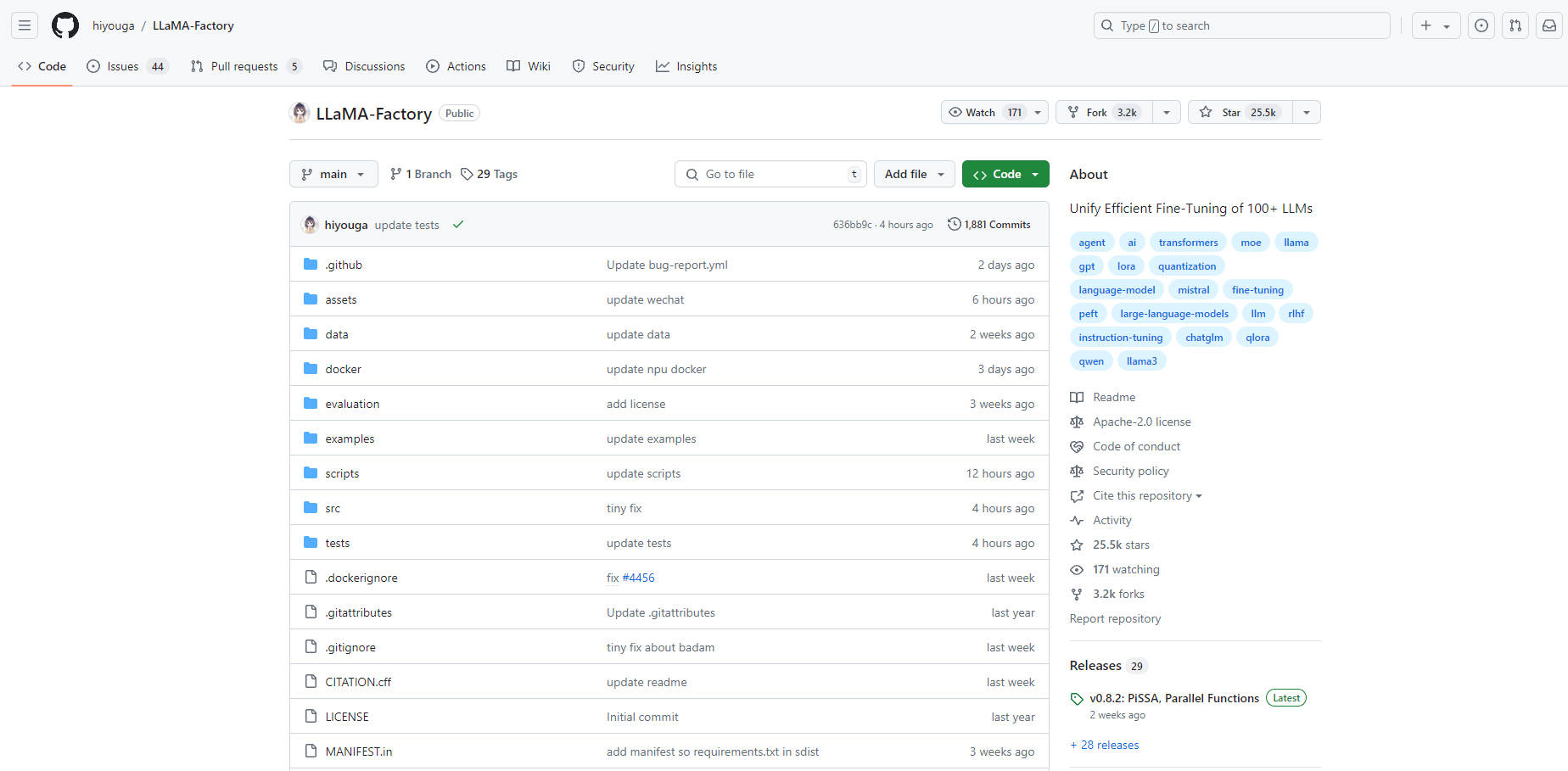

What is LLAMA-Factory?

Découvrez LLaMA Factory, un framework révolutionnaire à code source ouvert et à faible code qui transforme le réglage fin des grands modèles. S'appuyant sur une panoplie de techniques d'entraînement avancées, cette plateforme unifiée permet un réglage fin sans code de plus de 100 grands modèles de langage (LLM) via une interface Web intuitive. Fondée sur les principes de précision et d'efficacité, LLaMA Factory intègre le réglage fin de précision à plusieurs bits, des algorithmes innovants comme GaLore et des stratégies pratiques pour rationaliser l'adaptation des modèles à diverses tâches. Grâce à son architecture évolutive, les utilisateurs peuvent facilement personnaliser et affiner les LLM, même avec des connaissances minimales en codage, favorisant une nouvelle ère de personnalisation des applications d'IA.

Fonctionnalités clés

Réglage fin de précision polyvalent : prend en charge le réglage fin complet des paramètres 32 bits, 16 bits gelés et LoRA, s'étendant au réglage fin QLoRA 2/4/8 bits pour l'optimisation de la mémoire.

Algorithmes de réglage fin avancés : intègre des techniques de pointe telles que GaLore, LoRA+ et LoftQ, améliorant l'adaptation du modèle à diverses tâches.

Stratégies pratiques de réglage fin : améliore l'efficacité grâce à des méthodes telles que FlashAttention-2 et NEFTune, minimisant l'utilisation des ressources.

Interface Web pour une personnalisation facile : offre une interface conviviale qui simplifie la personnalisation et le réglage fin des LLM sans avoir besoin d'un codage intensif.

Architecture hautement évolutive : facilite le réglage fin évolutif de nombreux LLM, rationalisant le processus pour les utilisateurs techniques et non techniques.

Cas d'utilisation

Personnalisation du contenu éducatif : les enseignants et les éducateurs peuvent affiner les LLM pour des expériences d'apprentissage personnalisées, adaptant le contenu aux besoins individuels des élèves.

Automatisation du service client : les entreprises peuvent exploiter les LLM affinés pour créer des chatbots d'IA sophistiqués qui gèrent les requêtes des clients, améliorant la satisfaction des utilisateurs.

Services de traduction linguistique : les organisations peuvent optimiser les LLM pour des traductions précises et contextuelles dans diverses langues, améliorant la communication mondiale.

Conclusion

LLaMA Factory permet aux utilisateurs de libérer tout le potentiel des LLM grâce à ses capacités de réglage fin innovantes. En simplifiant le processus de personnalisation et en améliorant les performances du modèle, il catalyse l'intégration de l'IA dans les applications quotidiennes. Prêt à révolutionner vos projets d'IA ? Plongez dans l'avenir de la personnalisation des modèles avec LLaMA Factory dès aujourd'hui.

More information on LLAMA-Factory

LLAMA-Factory Alternatives

Plus Alternatives-

-

-

-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.

-