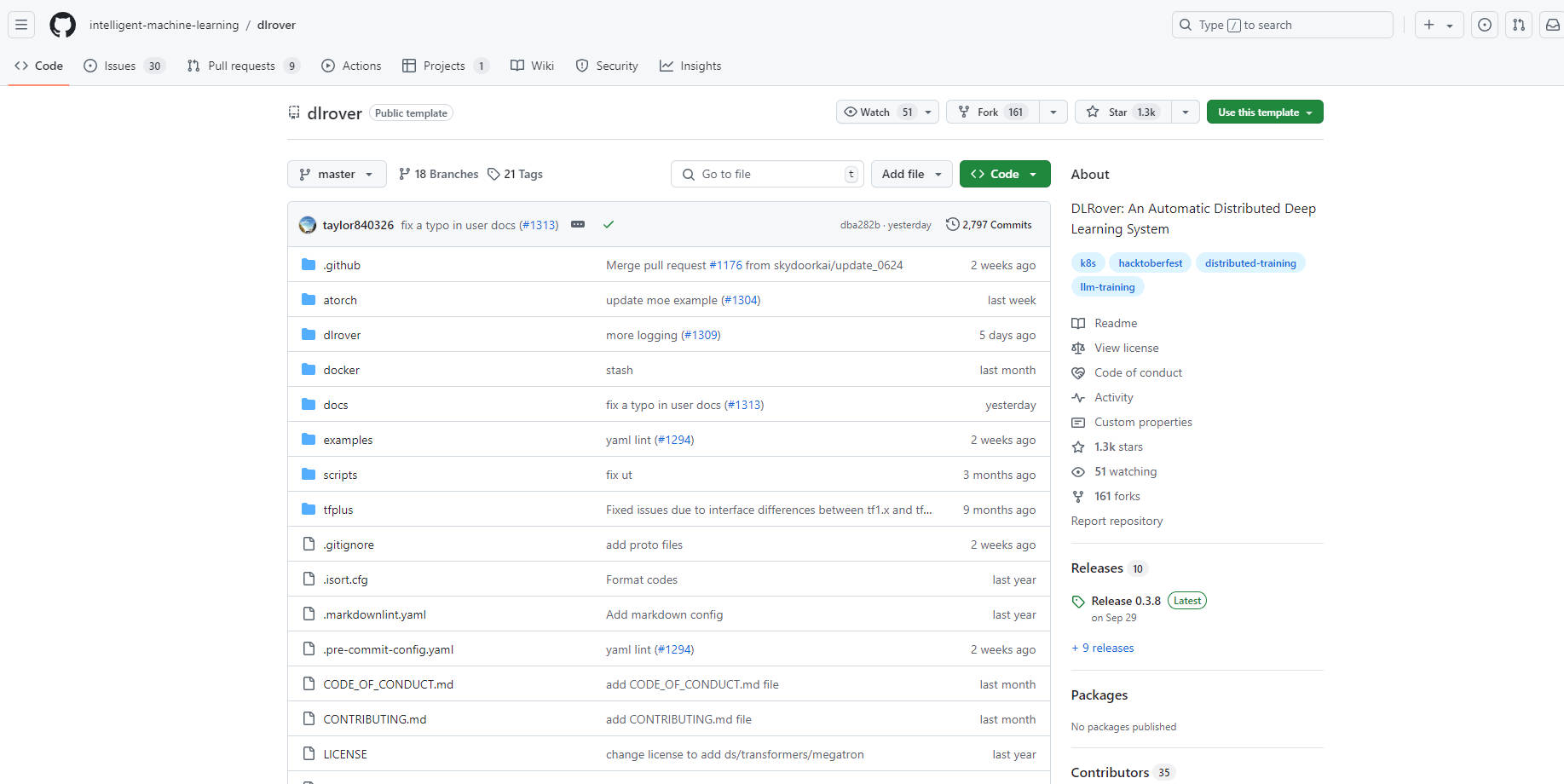

What is DLRover?

DLRover es un sistema de código abierto diseñado para simplificar y optimizar el entrenamiento distribuido de grandes modelos de aprendizaje profundo. Automatiza aspectos de ingeniería complejos como la aceleración de hardware y la ejecución distribuida, permitiendo a los desarrolladores centrarse en la arquitectura del modelo. DLRover mejora la estabilidad y la velocidad del entrenamiento a través de funciones como tolerancia a fallos, puntos de control instantáneos y escalado automático, al tiempo que admite los frameworks PyTorch y TensorFlow.

Características clave:

⚙️ Tolerancia a fallos: Detecta y recupera automáticamente de fallos en el entrenamiento distribuido, garantizando una operación continua y minimizando el tiempo de inactividad.

⚡️ Punto de control instantáneo: Permite el guardado y la carga rápidos de los puntos de control del entrenamiento en segundos, facilitando la recuperación rápida de los fallos y minimizando la pérdida de progreso.

? Escalado automático: Ajusta dinámicamente los recursos en función de las necesidades de entrenamiento en tiempo real, optimizando el rendimiento y la utilización de los recursos.

⏱️ Acelerar el entrenamiento: Proporciona bibliotecas de extensión especializadas, ATorch para PyTorch y TFPlus para TensorFlow, para mejorar la velocidad de entrenamiento para varios tipos de modelos.

?️ Operación y mantenimiento automatizados: Simplifica la gestión de trabajos de entrenamiento en clústeres Kubernetes (K8s) y Ray.

Casos de uso:

Un equipo de investigación utiliza DLRover para entrenar un modelo de lenguaje extenso en un clúster de múltiples GPU, asegurando un progreso continuo a pesar de los fallos ocasionales de los nodos.

Una empresa de IA aprovecha DLRover para optimizar el entrenamiento de un modelo de recomendación, escalando dinámicamente los recursos para satisfacer la demanda y reducir los costes.

Un científico de datos utiliza DLRover para experimentar con diferentes arquitecturas de aprendizaje profundo para el reconocimiento de imágenes, acelerando las iteraciones de entrenamiento y simplificando la ejecución distribuida.

Conclusión:

DLRover permite a los desarrolladores entrenar grandes modelos de IA de forma más eficiente y fiable. Sus capacidades de automatización, junto con las funciones de mejora del rendimiento como los puntos de control instantáneos y el escalado automático, lo convierten en una herramienta invaluable para acelerar la investigación y el desarrollo en el campo del aprendizaje profundo. Al simplificar las complejidades del entrenamiento distribuido, DLRover permite a los desarrolladores centrarse en la innovación y lograr un tiempo de obtención de resultados más rápido.

More information on DLRover

DLRover Alternativas

Más Alternativas-

-

-

Activeloop-L0: Your AI Knowledge Agent for accurate, traceable insights from all multimodal enterprise data. Securely in your cloud, beyond RAG.

-

KTransformers, un proyecto de código abierto del equipo KVCache.AI de Tsinghua y QuJing Tech, optimiza la inferencia de modelos de lenguaje grandes. Reduce los umbrales de hardware, ejecuta modelos de 671B parámetros en GPUs individuales de 24GB de VRAM, aumenta la velocidad de inferencia (hasta 286 tokens/s en pre-procesamiento, 14 tokens/s en generación) y es adecuado para uso personal, empresarial y académico.

-

FastRouter.ai optimiza la IA en producción mediante un enrutamiento inteligente de LLM. Unifica más de 100 modelos, reduce los costes, garantiza la fiabilidad y escala sin esfuerzo con una única API.