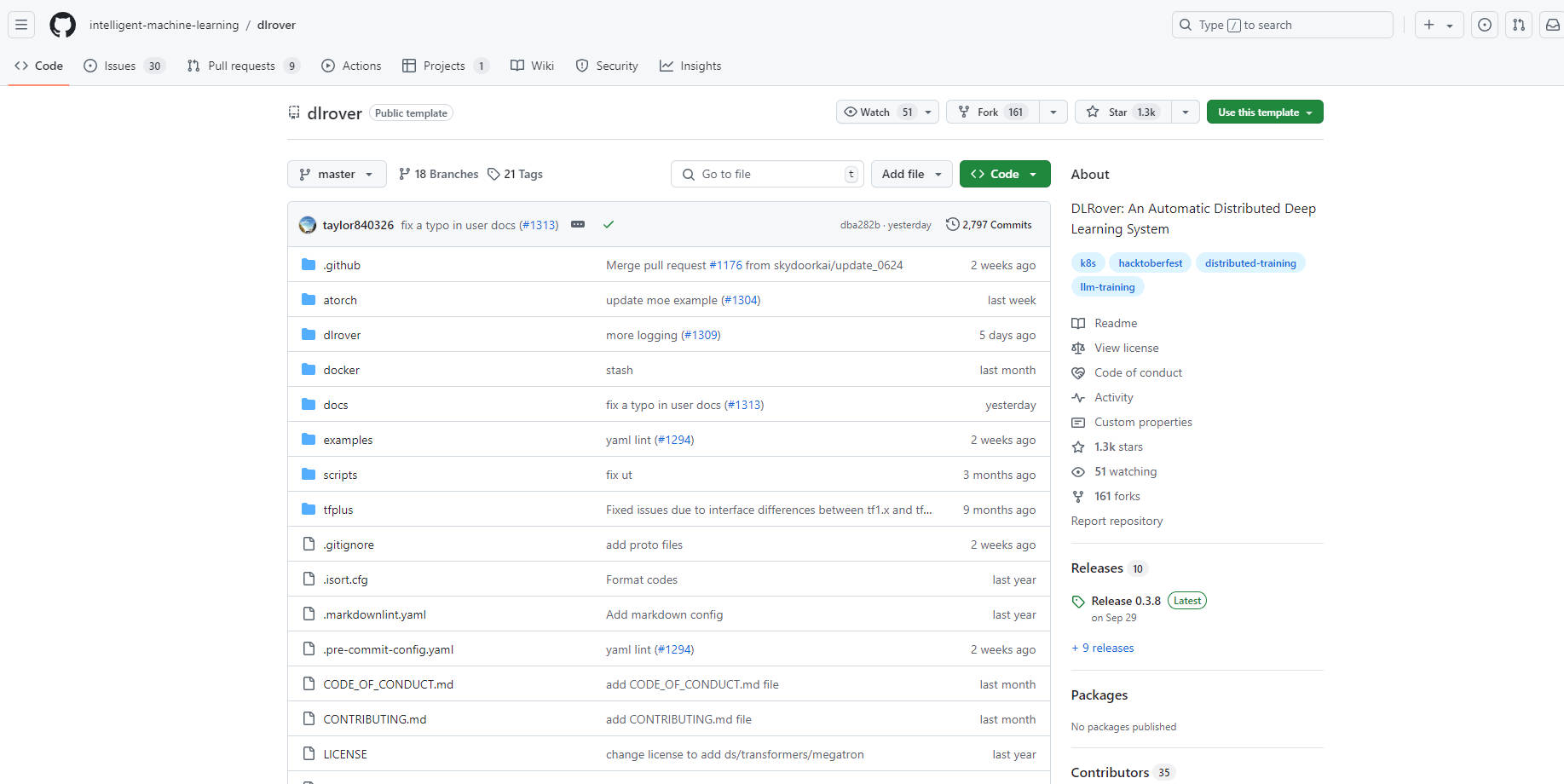

What is DLRover?

DLRover는 대규모 딥 러닝 모델의 분산 학습을 간소화하고 최적화하도록 설계된 오픈 소스 시스템입니다. 하드웨어 가속 및 분산 실행과 같은 복잡한 엔지니어링 측면을 자동화하여 개발자가 모델 아키텍처에 집중할 수 있도록 지원합니다. DLRover는 내결함성, 플래시 체크포인트, 자동 크기 조정과 같은 기능을 통해 학습 안정성과 속도를 향상시키는 동시에 PyTorch 및 TensorFlow 프레임워크를 모두 지원합니다.

주요 기능:

⚙️ 내결함성: 분산 학습에서 발생하는 오류를 자동으로 감지하고 복구하여 지속적인 작동을 보장하고 가동 중지 시간을 최소화합니다.

⚡️ 플래시 체크포인트: 학습 체크포인트를 초 단위로 빠르게 저장하고 로드할 수 있도록 하여 오류로부터 신속하게 복구하고 진행 상황 손실을 최소화합니다.

? 자동 크기 조정: 실시간 학습 요구 사항에 따라 리소스를 동적으로 조정하여 성능과 리소스 활용도를 최적화합니다.

⏱️ 학습 속도 향상: PyTorch용 ATorch 및 TensorFlow용 TFPlus와 같은 특수 확장 라이브러리를 제공하여 다양한 모델 유형에 대한 학습 속도를 향상시킵니다.

?️ 자동화된 운영 및 유지 관리: Kubernetes(K8s) 및 Ray 클러스터에서 학습 작업 관리를 간소화합니다.

사용 사례:

연구팀은 DLRover를 사용하여 다중 GPU 클러스터에서 대규모 언어 모델을 학습시켜 노드 오류가 발생하더라도 지속적인 진행을 보장합니다.

AI 회사는 DLRover를 활용하여 추천 모델 학습을 최적화하고 요구 사항에 맞게 리소스를 동적으로 확장하여 비용을 절감합니다.

데이터 과학자는 DLRover를 사용하여 이미지 인식을 위한 다양한 딥 러닝 아키텍처를 실험하고 학습 반복을 가속화하며 분산 실행을 간소화합니다.

결론:

DLRover는 개발자가 대규모 AI 모델을 더 효율적이고 안정적으로 학습시킬 수 있도록 지원합니다. 자동화 기능과 플래시 체크포인트 및 자동 크기 조정과 같은 성능 향상 기능을 결합하여 딥 러닝 분야의 연구 개발을 가속화하는 귀중한 도구입니다. DLRover는 분산 학습의 복잡성을 간소화하여 개발자가 혁신에 집중하고 더 빠른 결과를 얻을 수 있도록 지원합니다.

More information on DLRover

DLRover 대체품

더보기 대체품-

-

-

Activeloop-L0: Your AI Knowledge Agent for accurate, traceable insights from all multimodal enterprise data. Securely in your cloud, beyond RAG.

-

Tsinghua 대학의 KVCache.AI 팀과 QuJing Tech에서 개발한 오픈 소스 프로젝트인 KTransformers는 대규모 언어 모델 추론을 최적화합니다. 하드웨어 제약 조건을 낮추고, 24GB VRAM의 단일 GPU에서 6710억 개 파라미터 모델을 실행하며, 추론 속도를 향상(전처리 최대 286 토큰/초, 생성 최대 14 토큰/초)시켜 개인, 기업 및 학술 용도에 적합합니다.

-

FastRouter.ai는 스마트 LLM 라우팅 기술로 운영 환경의 AI 성능을 최적화합니다. 단 하나의 API로 100개 이상의 모델을 통합하여 비용을 절감하고, 안정적인 운영과 손쉬운 확장을 가능하게 합니다.