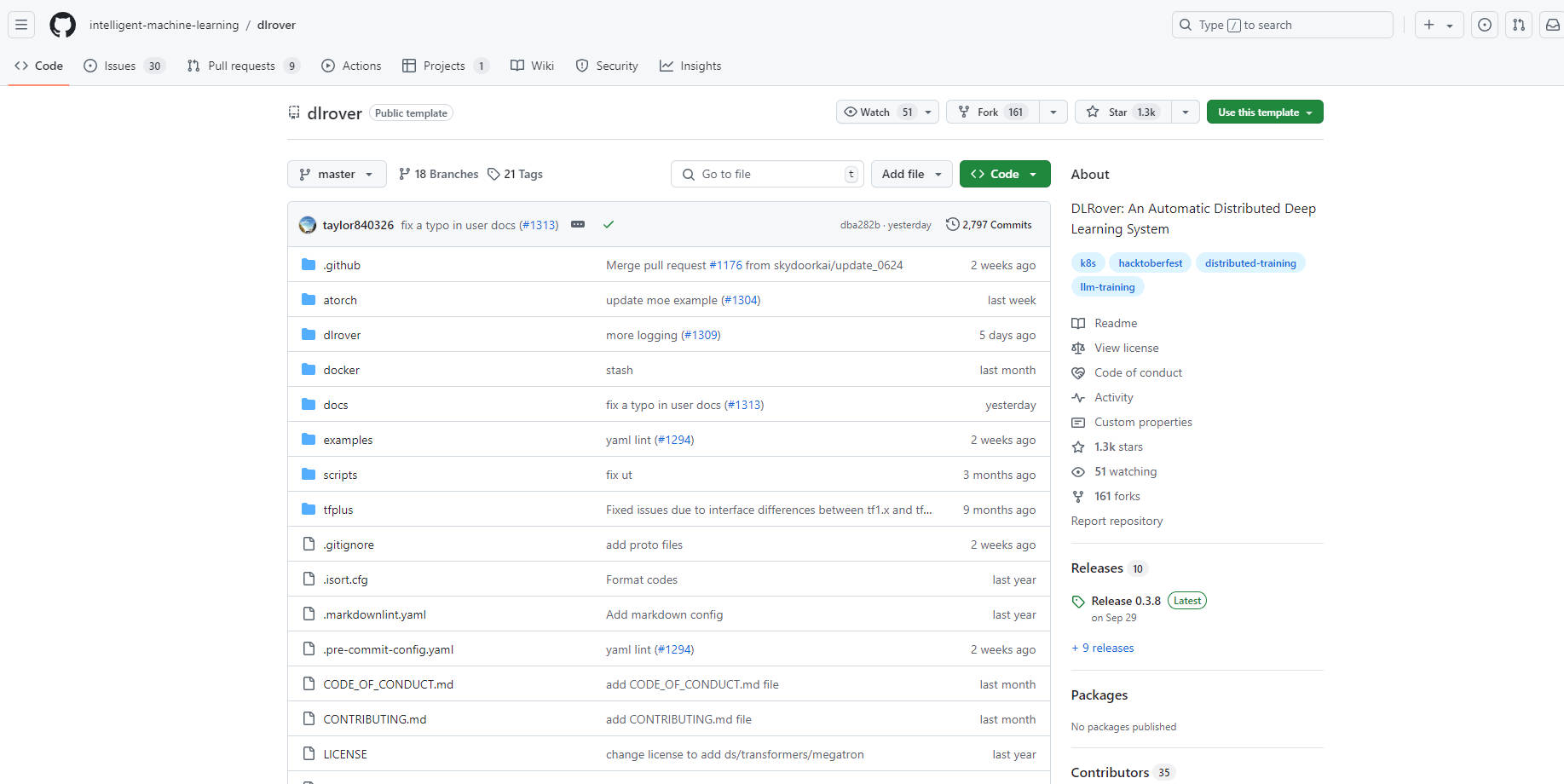

What is DLRover?

DLRoverは、大規模な深層学習モデルの分散トレーニングを簡素化および最適化するために設計されたオープンソースシステムです。ハードウェアアクセラレーションや分散実行などの複雑なエンジニアリング面を自動化することで、開発者はモデルアーキテクチャに集中できます。DLRoverは、フォールトトレランス、フラッシュチェックポイント、自動スケーリングなどの機能を通じて、トレーニングの安定性と速度を向上させ、PyTorchとTensorFlowの両方のフレームワークをサポートしています。

主な機能:

⚙️ フォールトトレランス:分散トレーニングにおける障害を自動的に検出および回復し、継続的な運用を確保し、ダウンタイムを最小限に抑えます。

⚡️ フラッシュチェックポイント:トレーニングチェックポイントの高速な保存と読み込みを数秒で可能にし、障害からの迅速な回復を促進し、失われた進捗状況を最小限に抑えます。

? 自動スケーリング:リアルタイムのトレーニングニーズに基づいてリソースを動的に調整し、パフォーマンスとリソースの利用率を最適化します。

⏱️ トレーニングの高速化:PyTorch用のATorchとTensorFlow用のTFPlusという特殊な拡張ライブラリを提供し、さまざまなモデルタイプのトレーニング速度を向上させます。

?️ 自動化された運用とメンテナンス:Kubernetes (K8s)およびRayクラスターでのトレーニングジョブの管理を簡素化します。

ユースケース:

研究チームは、DLRoverを使用して、マルチGPUクラスター上で大規模言語モデルをトレーニングし、ノードの偶発的な障害にもかかわらず、継続的な進捗を確保します。

AI企業は、DLRoverを活用して、レコメンドモデルのトレーニングを最適化し、需要に合わせてリソースを動的にスケーリングし、コストを削減します。

データサイエンティストは、DLRoverを使用して、画像認識のためのさまざまな深層学習アーキテクチャを試行し、トレーニングの反復を加速し、分散実行を簡素化します。

結論:

DLRoverは、開発者が大規模なAIモデルをより効率的かつ確実にトレーニングできるようにします。自動化機能と、フラッシュチェックポイントや自動スケーリングなどのパフォーマンス向上機能を組み合わせることで、深層学習分野における研究開発を加速するための貴重なツールとなります。DLRoverは、分散トレーニングの複雑さを簡素化することで、開発者がイノベーションに集中し、より迅速な結果を得られるようにします。

More information on DLRover

DLRover 代替ソフト

もっと見る 代替ソフト-

-

-

Activeloop-L0: Your AI Knowledge Agent for accurate, traceable insights from all multimodal enterprise data. Securely in your cloud, beyond RAG.

-

Tsinghua大学のKVCache.AIチームとQuJing Techが開発したオープンソースプロジェクト、KTransformersは、大規模言語モデルの推論を最適化します。ハードウェアの敷居を下げ、24GB VRAMのシングルGPU上で671Bパラメータのモデルを実行可能にし、推論速度を向上(前処理最大286トークン/秒、生成最大14トークン/秒)させ、個人利用、企業利用、学術利用に適しています。

-

FastRouter.ai はスマートなLLMルーティングを活用し、生産AIの最適化を実現します。単一のAPIで、100種類以上のモデルを統合し、コストを削減。信頼性を確保しながら、労力なくスケールアップを可能にします。