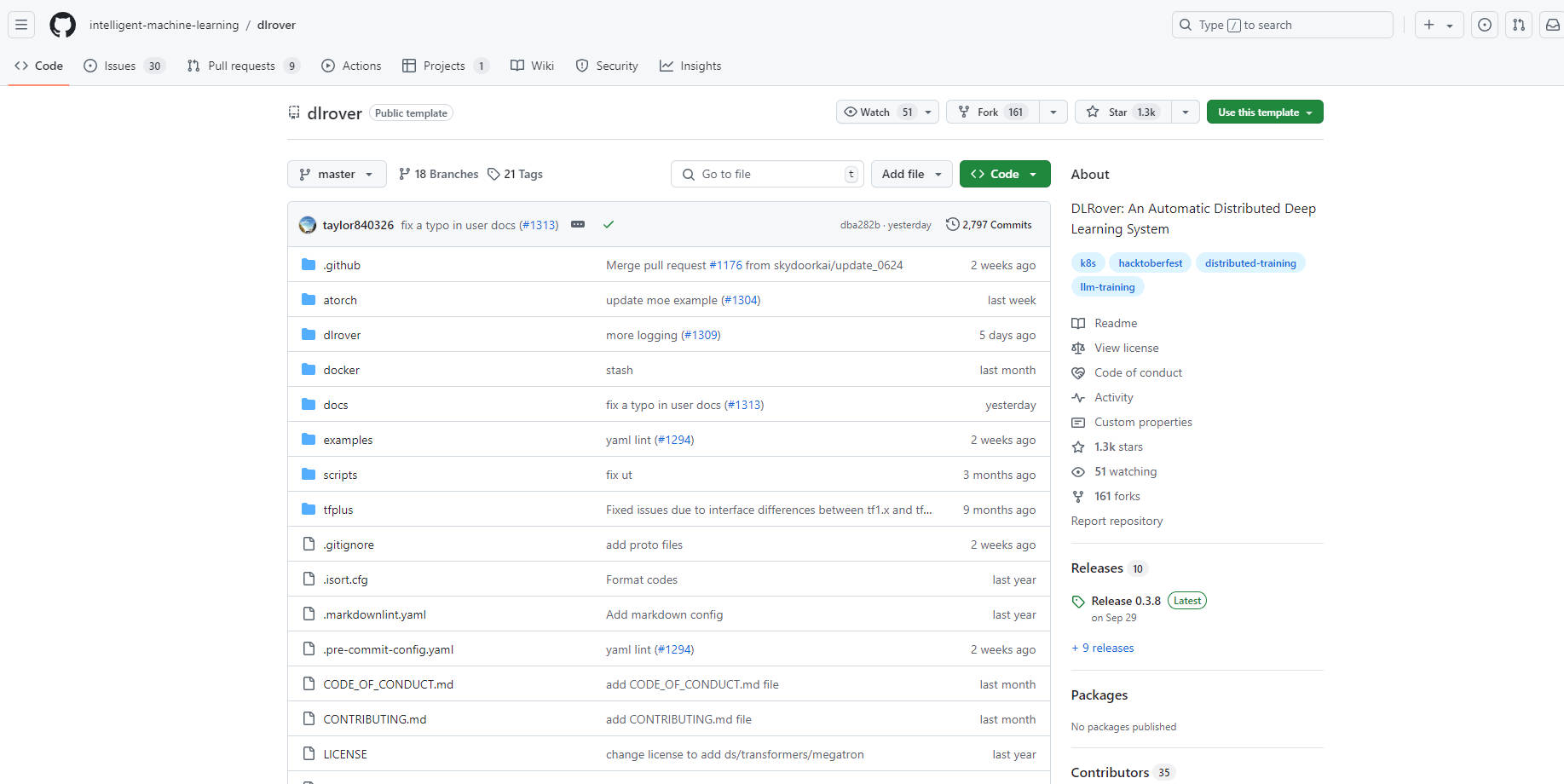

What is DLRover?

DLRover est un système open source conçu pour simplifier et optimiser l'entraînement distribué de grands modèles d'apprentissage profond. Il automatise les aspects d'ingénierie complexes tels que l'accélération matérielle et l'exécution distribuée, permettant aux développeurs de se concentrer sur l'architecture du modèle. DLRover améliore la stabilité et la vitesse de l'entraînement grâce à des fonctionnalités telles que la tolérance aux pannes, les points de contrôle instantanés et la mise à l'échelle automatique, tout en prenant en charge les frameworks PyTorch et TensorFlow.

Fonctionnalités clés :

⚙️ Tolérance aux pannes : Détecte et récupère automatiquement les pannes lors de l'entraînement distribué, assurant un fonctionnement continu et minimisant les temps d'arrêt.

⚡️ Point de contrôle instantané : Permet d'enregistrer et de charger rapidement les points de contrôle de l'entraînement en quelques secondes, facilitant une récupération rapide des pannes et minimisant la perte de progression.

? Mise à l'échelle automatique : Ajuste dynamiquement les ressources en fonction des besoins d'entraînement en temps réel, optimisant les performances et l'utilisation des ressources.

⏱️ Accélérer l'entraînement : Fournit des bibliothèques d'extension spécialisées, ATorch pour PyTorch et TFPlus pour TensorFlow, pour améliorer la vitesse d'entraînement pour divers types de modèles.

?️ Opération et maintenance automatisées : Simplifie la gestion des tâches d'entraînement sur les clusters Kubernetes (K8s) et Ray.

Cas d'utilisation :

Une équipe de recherche utilise DLRover pour entraîner un grand modèle linguistique sur un cluster multi-GPU, assurant une progression continue malgré les pannes occasionnelles de nœuds.

Une entreprise d'IA exploite DLRover pour optimiser l'entraînement d'un modèle de recommandation, en adaptant dynamiquement les ressources pour répondre à la demande et réduire les coûts.

Un scientifique des données utilise DLRover pour expérimenter différentes architectures d'apprentissage profond pour la reconnaissance d'images, accélérant les itérations d'entraînement et simplifiant l'exécution distribuée.

Conclusion :

DLRover permet aux développeurs d'entraîner de grands modèles d'IA de manière plus efficace et fiable. Ses capacités d'automatisation, associées à des fonctionnalités d'amélioration des performances telles que les points de contrôle instantanés et la mise à l'échelle automatique, en font un outil précieux pour accélérer la recherche et le développement dans le domaine de l'apprentissage profond. En simplifiant les complexités de l'entraînement distribué, DLRover permet aux développeurs de se concentrer sur l'innovation et d'obtenir des résultats plus rapidement.

More information on DLRover

DLRover Alternatives

Plus Alternatives-

-

-

Activeloop-L0: Your AI Knowledge Agent for accurate, traceable insights from all multimodal enterprise data. Securely in your cloud, beyond RAG.

-

KTransformers, un projet open source de l'équipe KVCache.AI de Tsinghua et de QuJing Tech, optimise l'inférence des grands modèles de langage. Il réduit les seuils matériels, permet d'exécuter des modèles de 671 milliards de paramètres sur des GPU uniques de 24 Go de VRAM, accélère la vitesse d'inférence (jusqu'à 286 tokens/s en pré-traitement, 14 tokens/s en génération) et convient à un usage personnel, professionnel et académique.

-

FastRouter.ai optimise l'IA de production grâce à un routage intelligent des LLM. Unifiez plus de 100 modèles, réduisez les coûts, garantissez la fiabilité et évoluez en toute simplicité grâce à une API unique.