What is LightEval?

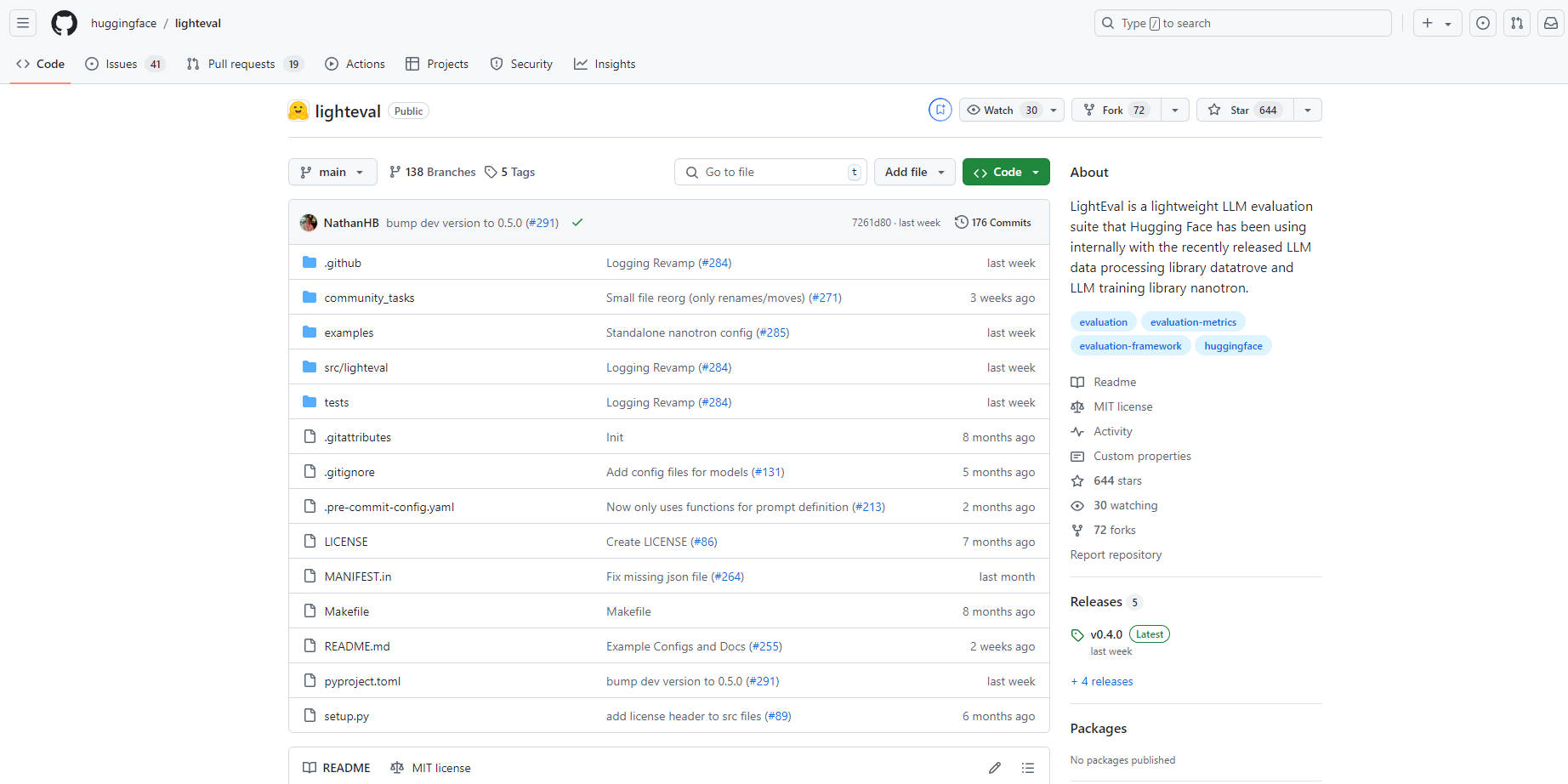

LightEval, una herramienta de evaluación de IA de vanguardia y ligera de Hugging Face diseñada específicamente para evaluar modelos de lenguaje grandes (LLM). Con su versatilidad para manejar múltiples tareas y configuraciones complejas, LightEval opera en diversas configuraciones de hardware, incluyendo CPUs, GPUs y TPUs. Es accesible a través de una interfaz de línea de comandos sencilla o programáticamente, permitiendo a los usuarios adaptar las tareas y las configuraciones de evaluación. Integrado con otras herramientas de Hugging Face, LightEval simplifica la gestión y el intercambio de modelos, convirtiéndolo en una opción ideal tanto para empresas como para investigadores. De código abierto y disponible en GitHub, esta herramienta se combina perfectamente con el repositorio de datos y nanotron de Hugging Face para un procesamiento y entrenamiento integral de LLM.

Características principales:

Soporte multidispositivo:Evalúa modelos en CPUs, GPUs y TPUs, asegurando la adaptabilidad a diversos entornos de hardware y demandas corporativas.

Interfaz fácil de usar:Incluso los usuarios con poca experiencia técnica pueden utilizar fácilmente LightEval para evaluar modelos en varios puntos de referencia o definir tareas personalizadas.

Evaluaciones personalizables:Adapta las evaluaciones a necesidades específicas, incluyendo la configuración de evaluación de modelos como ponderaciones, paralelismo de canalización y más.

Integración con el ecosistema de Hugging Face:Se integra a la perfección con herramientas como Hugging Face Hub para una gestión y un intercambio de modelos sin esfuerzo.

Soporte de configuración compleja:Carga modelos utilizando archivos de configuración para manejar configuraciones intrincadas, incluyendo pesos de adaptador/incrementales u otras opciones de configuración avanzadas.

Evaluación de paralelismo de canalización:Evalúa eficientemente modelos con más de 40B parámetros en precisión de 16 bits utilizando el paralelismo de canalización para distribuir las porciones del modelo en múltiples GPUs.

Casos de uso:

Pruebas de modelos empresariales:Las empresas pueden validar fácilmente el rendimiento de los LLM en varios sistemas de hardware antes de la implementación.

Investigación y desarrollo:Los investigadores pueden experimentar con diferentes configuraciones y puntos de referencia para refinar los modelos de lenguaje para aplicaciones específicas.

Estándares personalizados:Los desarrolladores pueden crear tareas y puntos de referencia personalizados para evaluar los LLM frente a requisitos únicos.

Conclusión:

LightEval destaca como un conjunto de evaluación potente, versátil y fácil de usar para modelos de lenguaje grandes. Su compatibilidad con múltiples dispositivos de hardware, facilidad de integración y naturaleza personalizable asegura que tanto las empresas como los investigadores puedan evaluar y refinar eficientemente los LLM para una amplia gama de aplicaciones. Experimenta el futuro de la evaluación de modelos de IA con LightEval, donde el rendimiento se une a la simplicidad.