What is LightEval?

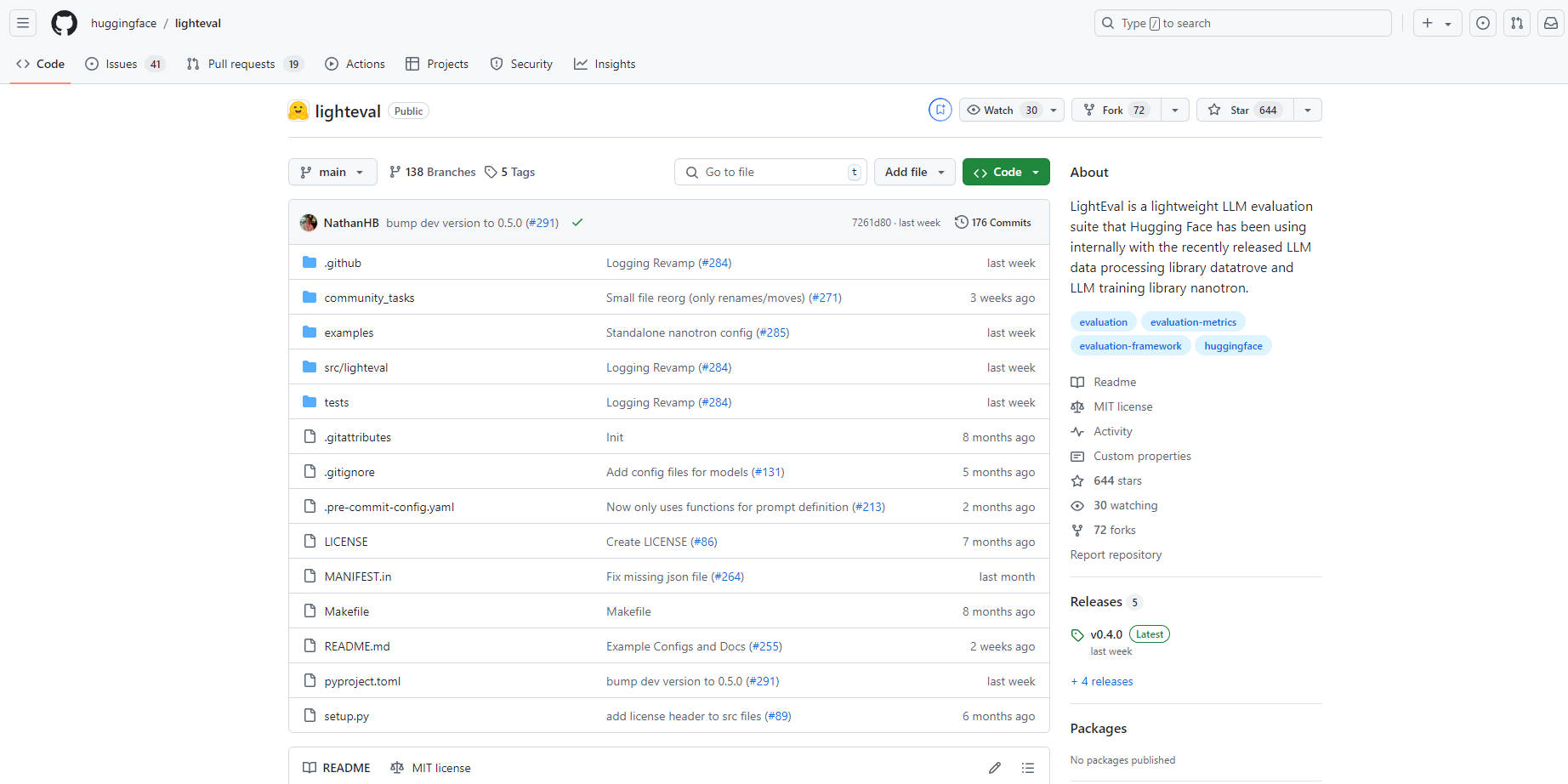

LightEval 是来自 Hugging Face 的一款尖端轻量级 AI 评估工具,专门用于评估大型语言模型 (LLM)。LightEval 凭借其处理多种任务和复杂配置的通用性,可在包括 CPU、GPU 和 TPU 在内的各种硬件设置上运行。它可以通过简单的命令行界面或以编程方式访问,使用户能够定制任务和评估设置。LightEval 与其他 Hugging Face 工具集成,简化了模型管理和共享,使其成为企业和研究人员的理想选择。该工具开源并可在 GitHub 上获取,与 Hugging Face 的 datatrove 和 nanotron 完美搭配,实现全面的 LLM 处理和训练。

主要功能:

多设备支持:在 CPU、GPU 和 TPU 上评估模型,确保适应不同的硬件环境和企业需求。

用户友好的界面:即使是技术经验有限的用户也可以轻松使用 LightEval 在各种基准上评估模型或定义自定义任务。

可定制的评估:根据特定需求调整评估,包括设置模型评估配置,例如权重、流水线并行等。

Hugging Face 生态系统集成:与 Hugging Face Hub 等工具无缝集成,轻松管理和共享模型。

复杂配置支持:使用配置文件加载模型以处理复杂的设置,包括适配器/增量权重或其他高级配置选项。

流水线并行评估:使用流水线并行在多个 GPU 上分布模型切片,有效地评估超过 400 亿参数的模型,精度为 16 位。

用例:

企业模型测试:企业可以在部署之前轻松验证 LLM 在各种硬件系统上的性能。

研究与开发:研究人员可以尝试不同的配置和基准,以针对特定应用改进语言模型。

个性化基准测试:开发人员可以创建自定义任务和基准,以针对独特的要求评估 LLM。

结论:

LightEval 是一款功能强大、用途广泛且用户友好的大型语言模型评估套件。它与多种硬件设备的兼容性、易于集成以及可定制的特性确保企业和研究人员能够有效地评估和改进 LLM,以满足各种应用。体验 LightEval 带来的 AI 模型评估的未来 - 性能与简便兼得。