What is LightEval?

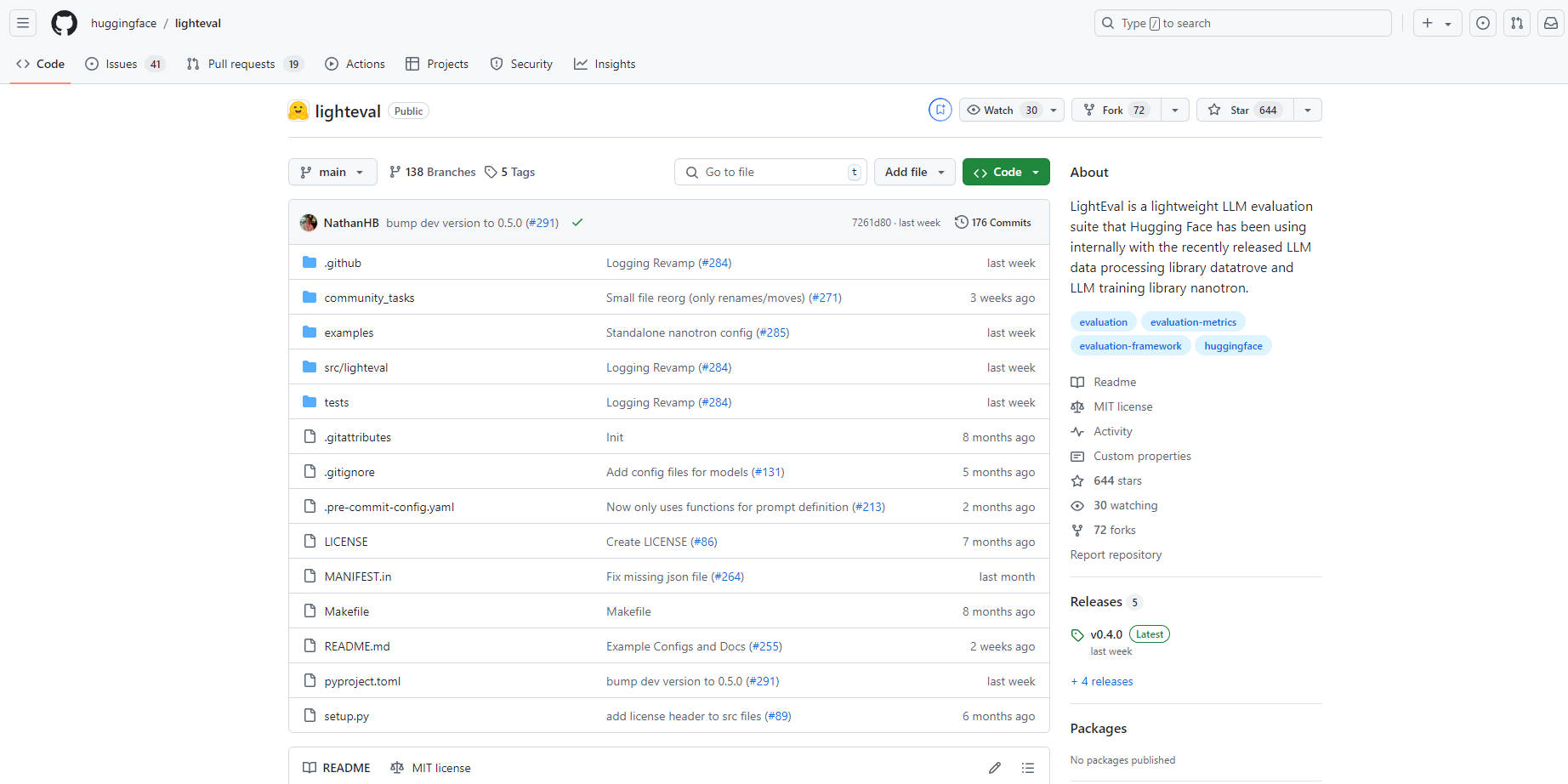

LightEval – это передовой, облегченный инструмент оценки ИИ от Hugging Face, разработанный специально для анализа больших языковых моделей (LLM). Благодаря своей универсальности в обработке множества задач и сложных конфигураций, LightEval работает на различных аппаратных платформах, включая ЦП, ГП и ТП. Доступ к нему можно получить через простой интерфейс командной строки или программно, что позволяет пользователям настраивать задачи и параметры оценки. Интегрированный с другими инструментами Hugging Face, LightEval упрощает управление моделями и обмен ими, что делает его идеальным выбором как для предприятий, так и для исследователей. Этот инструмент с открытым исходным кодом, доступный на GitHub, идеально сочетается с хранилищем данных и nanotron от Hugging Face для комплексной обработки и обучения LLM.

Ключевые особенности:

Поддержка нескольких устройств: Оценивайте модели на ЦП, ГП и ТП, обеспечивая адаптивность к различным аппаратным ландшафтам и корпоративным требованиям.

Удобный интерфейс: Даже пользователи с минимальным техническим опытом могут легко использовать LightEval для оценки моделей на различных эталонных наборах данных или определения собственных задач.

Настраиваемые оценки: Адаптируйте оценки к конкретным потребностям, включая настройку конфигурации оценки модели, таких как веса, параллелизм конвейера и многое другое.

Интеграция экосистемы Hugging Face: Бесшовная интеграция с такими инструментами, как Hugging Face Hub, для удобного управления моделями и обмена ими.

Поддержка сложных конфигураций: Загружайте модели с использованием конфигурационных файлов для обработки сложных настроек, включая адаптерные/инкрементные веса или другие расширенные параметры конфигурации.

Оценка с параллелизмом конвейера: Эффективно оценивайте модели с более чем 40 миллиардами параметров в 16-битной точности с использованием параллелизма конвейера для распределения фрагментов модели по нескольким ГП.

Сферы применения:

Тестирование корпоративных моделей: Корпорации могут легко проверять производительность LLM на различных аппаратных системах перед развертыванием.

Исследования и разработки: Исследователи могут экспериментировать с различными конфигурациями и эталонными наборами данных для доработки языковых моделей для конкретных приложений.

Персонализированный бенчмаркинг: Разработчики могут создавать собственные задачи и эталонные наборы данных для оценки LLM с учетом уникальных требований.

Заключение:

LightEval выделяется как мощный, универсальный и удобный в использовании набор инструментов для оценки больших языковых моделей. Его совместимость с различными аппаратными устройствами, простота интеграции и настраиваемость гарантируют, что как предприятия, так и исследователи могут эффективно оценивать и дорабатывать LLM для широкого спектра приложений. Испытайте будущее оценки моделей ИИ с LightEval – где производительность встречается с простотой.