What is LightEval?

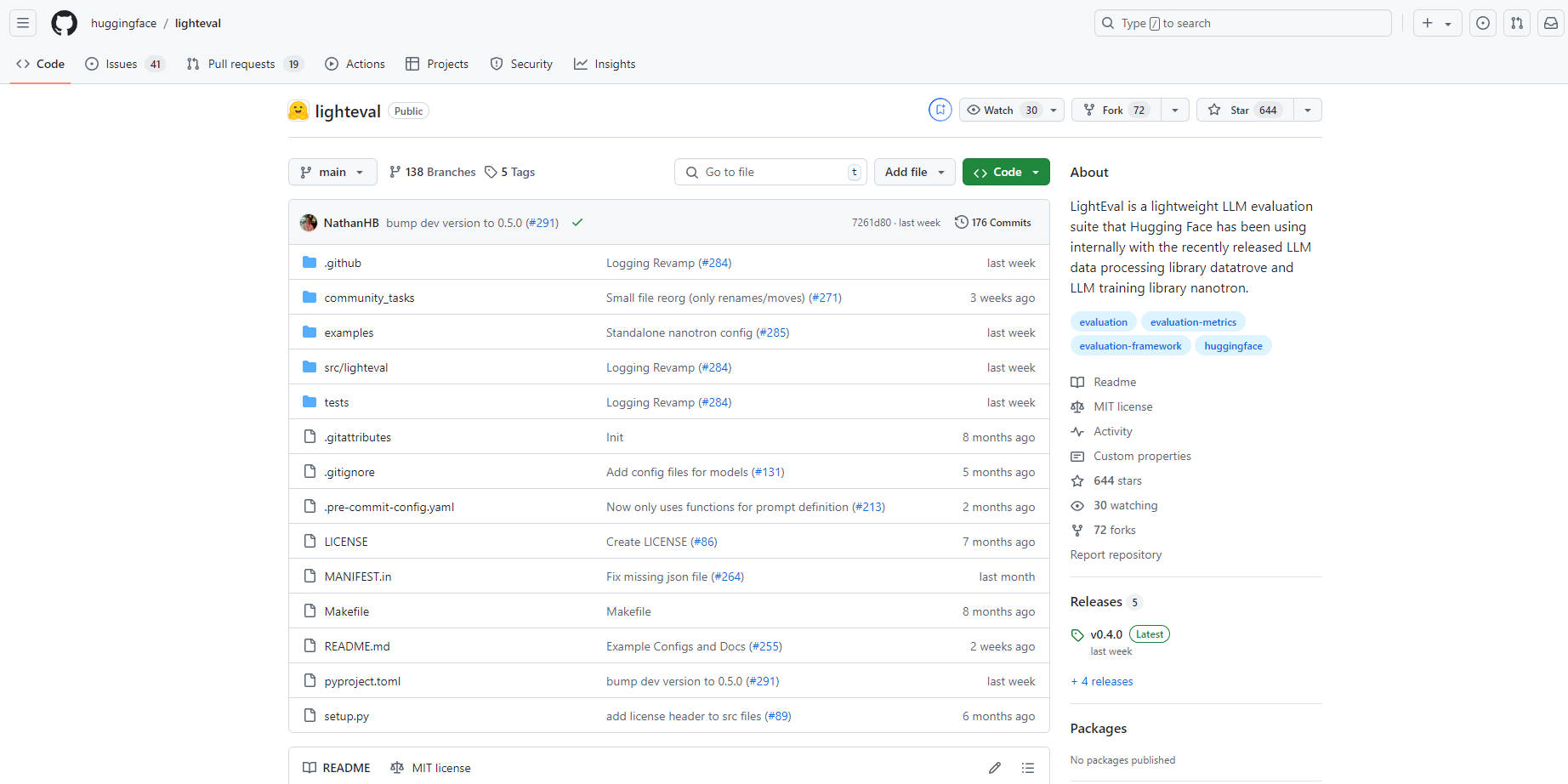

LightEval, un outil d'évaluation d'IA léger et de pointe de Hugging Face, spécialement conçu pour évaluer les grands modèles de langage (LLM). Grâce à sa polyvalence pour gérer plusieurs tâches et configurations complexes, LightEval fonctionne sur diverses configurations matérielles, notamment les CPU, GPU et TPU. Il est accessible via une interface de ligne de commande simple ou par programmation, permettant aux utilisateurs de personnaliser les tâches et les paramètres d'évaluation. Intégré à d'autres outils Hugging Face, LightEval simplifie la gestion et le partage des modèles, ce qui en fait un choix idéal pour les entreprises et les chercheurs. Open-source et disponible sur GitHub, cet outil s'associe parfaitement à la base de données et au nanotron de Hugging Face pour un traitement et une formation complets des LLM.

Fonctionnalités clés :

Prise en charge multi-appareils :Évaluez les modèles sur les CPU, GPU et TPU, assurant l'adaptabilité aux différents paysages matériels et aux exigences des entreprises.

Interface conviviale :Même les utilisateurs ayant une expertise technique minimale peuvent facilement utiliser LightEval pour évaluer les modèles sur diverses références ou définir des tâches personnalisées.

Évaluations personnalisables :Adaptez les évaluations à des besoins spécifiques, notamment en définissant des configurations d'évaluation de modèle telles que les pondérations, le parallélisme de pipeline, etc.

Intégration de l'écosystème Hugging Face :S'intègre de manière transparente à des outils tels que Hugging Face Hub pour une gestion et un partage de modèles sans effort.

Prise en charge de configurations complexes :Chargez les modèles à l'aide de fichiers de configuration pour gérer des configurations complexes, y compris les adaptateurs/pondérations incrémentielles ou d'autres options de configuration avancées.

Évaluation parallèle de pipeline :Évalue efficacement les modèles avec plus de 40 milliards de paramètres en précision 16 bits en utilisant le parallélisme de pipeline pour distribuer des tranches de modèles sur plusieurs GPU.

Cas d'utilisation :

Tests de modèles d'entreprise :Les entreprises peuvent facilement valider les performances des LLM sur divers systèmes matériels avant le déploiement.

Recherche et développement :Les chercheurs peuvent expérimenter différentes configurations et références pour affiner les modèles de langage pour des applications spécifiques.

Étalonnage personnalisé :Les développeurs peuvent créer des tâches et des références personnalisées pour évaluer les LLM en fonction d'exigences uniques.

Conclusion :

LightEval se distingue comme une suite d'évaluation puissante, polyvalente et conviviale pour les grands modèles de langage. Sa compatibilité avec plusieurs appareils matériels, sa facilité d'intégration et sa nature personnalisable garantissent que les entreprises et les chercheurs peuvent évaluer et affiner efficacement les LLM pour un large éventail d'applications. Découvrez l'avenir de l'évaluation des modèles d'IA avec LightEval, où les performances rencontrent la simplicité.