What is LitServe?

¿Eres un desarrollador o ingeniero de IA que dedica más tiempo a lidiar con la infraestructura que a innovar con tus modelos? LitServe es un motor de serving flexible y fácil de usar, diseñado para optimizar la implementación de cualquier modelo de IA, independientemente de su tamaño o framework. Construido sobre el popular framework FastAPI, LitServe elimina las complejidades de la escalabilidad, el batching y la gestión de GPU, permitiéndote concentrarte en lo que realmente importa: el rendimiento de tu IA.

Características principales:

⚡️ Acelera el rendimiento del Serving: Experimenta al menos el doble de velocidad en comparación con las implementaciones estándar de FastAPI, gracias al manejo optimizado de múltiples workers de LitServe, específicamente diseñado para cargas de trabajo de IA.

⚙️ Simplifica la implementación con LitAPI y LitServer: Estructura tu código sin esfuerzo. LitAPI define cómo tu modelo maneja las solicitudes, mientras que LitServer gestiona las complejidades de la escalabilidad, el batching y el streaming, todo ello sin necesidad de una profunda experiencia en infraestructura.

🤖 Implementa cualquier modelo, cualquier Framework: ¡Trae tu propio modelo! LitServe soporta una amplia gama de frameworks, incluyendo PyTorch, JAX, TensorFlow y más. Está diseñado para la versatilidad, manejando desde LLMs hasta modelos tradicionales de machine learning.

🚀 Escala sin esfuerzo con la gestión automática de GPU: LitServe escala automáticamente tu modelo a través de las GPUs disponibles, maximizando la utilización de los recursos. También soporta batching y streaming, mejorando aún más el rendimiento para aplicaciones de IA generativa.

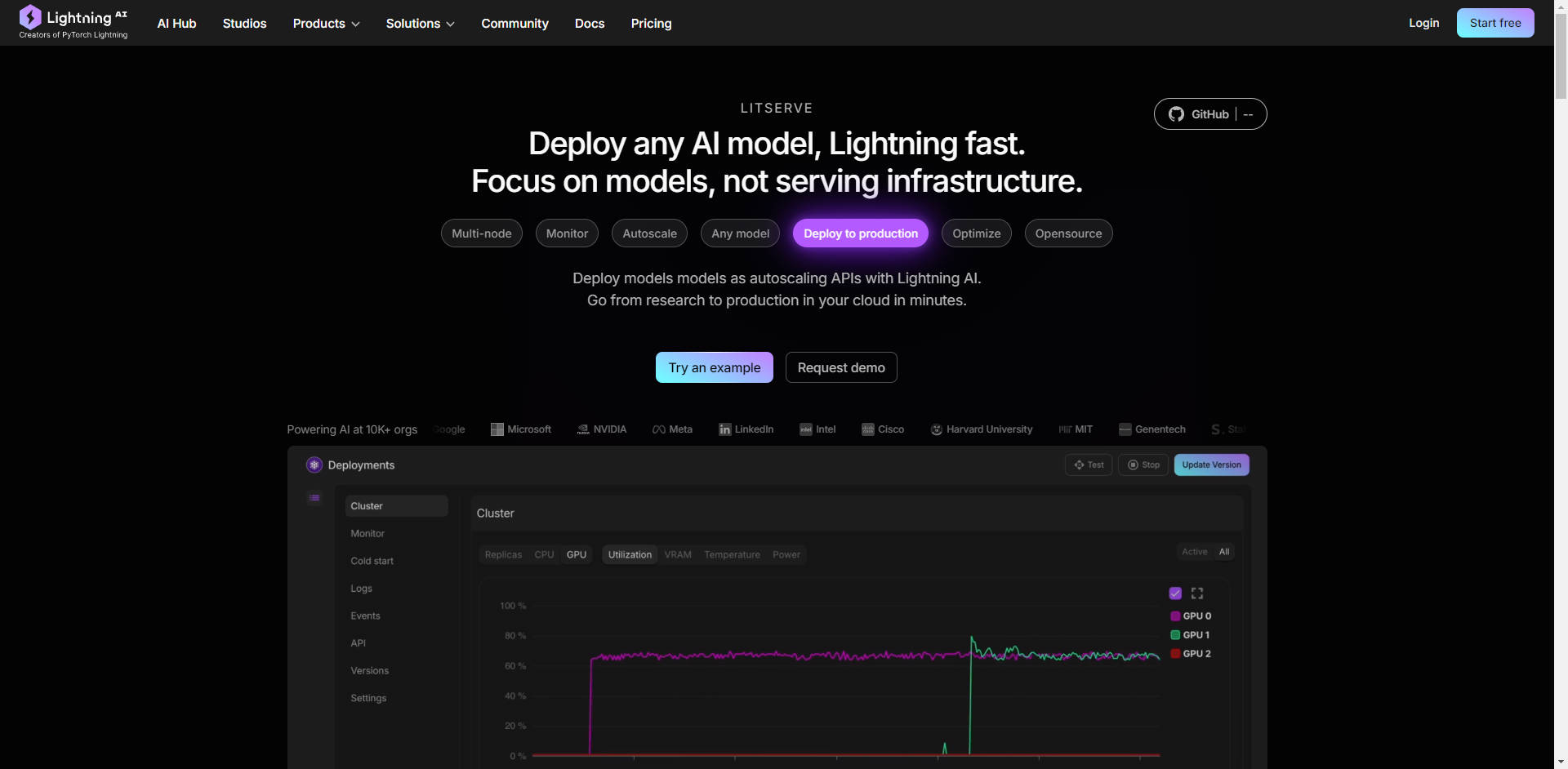

☁️ Implementa en cualquier lugar, con control total: Elige tu entorno de implementación. Ejecuta LitServe en tu propia infraestructura para un control total, o aprovecha la plataforma gestionada de Lightning AI para la monitorización automatizada, el autoscaling y la tolerancia a fallos.

Casos de uso:

Generación de texto de alto rendimiento: Imagina que has desarrollado un modelo de lenguaje grande (LLM) personalizado para generar textos de marketing. Con LitServe, puedes implementar este modelo para gestionar miles de solicitudes concurrentes, garantizando una generación rápida de contenido para todo tu equipo de marketing, sin preocuparte por los cuellos de botella del servidor.

Procesamiento de imágenes en tiempo real: Has construido un modelo de visión artificial para analizar imágenes de cámaras de seguridad en tiempo real. LitServe te permite implementar este modelo en dispositivos edge o en la nube, procesando múltiples flujos de vídeo simultáneamente y proporcionando alertas instantáneas para eventos críticos. Todo esto se logra con la ayuda del soporte multi-GPU y el serving optimizado.

Sistema de IA compuesto para atención al cliente: Necesitas un sistema que primero transcriba las consultas de voz de los clientes (utilizando un modelo de speech-to-text), luego analice el sentimiento y la intención (utilizando un modelo de NLP) y finalmente genere una respuesta personalizada (utilizando un LLM). LitServe te permite encadenar estos modelos de forma fluida, creando una solución de atención al cliente potente y eficiente.

Conclusión:

LitServe te permite pasar del desarrollo de modelos a la implementación en producción con una velocidad y eficiencia sin precedentes. Su arquitectura flexible, combinada con potentes capacidades de escalado y soporte para cualquier modelo de IA, la convierte en la solución ideal para los desarrolladores que buscan llevar sus innovaciones de IA al mundo. Deja de luchar contra la infraestructura y empieza a centrarte en lo que realmente importa: tu IA.

Preguntas frecuentes:

¿Cuál es la diferencia entre LitServe y vLLM?

LitServe opera a un nivel de abstracción más bajo que servidores como vLLM. Piensa en LitServe como una herramienta fundamental que te permite construir tu propia solución de serving especializada, como un servidor vLLM personalizado. vLLM es una solución preconstruida optimizada específicamente para LLMs, mientras que LitServe ofrece una mayor flexibilidad para cualquier tipo de modelo de IA.

¿Puedo usar LitServe con mis proyectos FastAPI existentes?

Sí, LitServe está construido sobre FastAPI y está diseñado para integrarse fácilmente. Aumenta FastAPI con características específicas de la IA, mejorando su rendimiento y escalabilidad para el model serving.

¿Qué nivel de experiencia técnica se requiere para usar LitServe?

LitServe está diseñado para desarrolladores e ingenieros de IA que se sientan cómodos trabajando con Python y tengan cierta familiaridad con la implementación de modelos de machine learning. Los ejemplos de código y la documentación proporcionados facilitan el inicio, incluso si no eres un experto en infraestructura de deep learning.

¿Qué tipo de ahorro de costes puedo esperar con LitServe? LitServe tiene características, como scale-to-zero (serverless), instancias interrumpibles, batching y streaming, que pueden reducir drásticamente los costes de serving. Por ejemplo, con 1$, Llama 3.1 obtiene 366k tokens, chatGPT 25K tokens. Además, el modelo se ejecuta en tu nube segura, con capacidad dedicada.

¿Cuáles son los beneficios de usar LitServe en la plataforma Lightning AI?

La implementación en Lightning AI proporciona beneficios adicionales, incluyendo la monitorización automatizada, el autoscaling (desde cero hasta miles de GPUs), la tolerancia a fallos y la gestión simplificada. Agiliza el proceso de implementación y ofrece características de nivel empresarial.

More information on LitServe

Top 5 Countries

Traffic Sources

LitServe Alternativas

Más Alternativas-

-

-

Literal AI: Observabilidad y Evaluación para RAG y LLMs. Depura, monitoriza, optimiza el rendimiento y garantiza aplicaciones de IA listas para producción.

-

OpenLIT es una herramienta de observabilidad de LLM y GPU de código abierto construida sobre OpenTelemetry. Ofrece rastreo, métricas y un espacio de pruebas para depurar y mejorar las aplicaciones de LLM. Admite más de 20 integraciones como OpenAI, LangChain, y exporta datos a tus herramientas de observabilidad existentes.

-