What is LitServe?

AI 모델 개발자나 엔지니어로서 모델 혁신보다 인프라 문제 해결에 더 많은 시간을 보내고 계신가요? LitServe는 크기나 프레임워크에 관계없이 모든 AI 모델의 배포를 간소화하도록 설계된 유연하고 사용하기 쉬운 서빙 엔진입니다. 널리 사용되는 FastAPI 프레임워크를 기반으로 구축된 LitServe는 확장, 일괄 처리 및 GPU 관리의 복잡성을 제거하여 AI 성능이라는 본질에 집중할 수 있도록 합니다.

주요 기능:

⚡️ 서빙 성능 가속화: LitServe의 최적화된 멀티 워커 처리 덕분에 표준 FastAPI 구현에 비해 최소 2배 빠른 속도를 경험하십시오. 특히 AI 워크로드에 맞춰 설계되었습니다.

⚙️ LitAPI 및 LitServer로 배포 간소화: 코드를 간편하게 구성하십시오. LitAPI는 모델이 요청을 처리하는 방식을 정의하고, LitServer는 확장, 일괄 처리 및 스트리밍의 복잡성을 관리합니다. 심층적인 인프라 전문 지식이 없어도 가능합니다.

🤖 모든 모델, 모든 프레임워크 배포: 자신만의 모델을 가져오십시오! LitServe는 PyTorch, JAX, TensorFlow 등 광범위한 프레임워크를 지원합니다. LLM부터 기존 머신러닝 모델까지 모든 것을 처리할 수 있도록 다재다능하게 설계되었습니다.

🚀 자동 GPU 관리로 손쉬운 확장: LitServe는 사용 가능한 GPU에서 모델을 자동으로 확장하여 리소스 활용률을 극대화합니다. 또한 일괄 처리 및 스트리밍을 지원하여 생성형 AI 애플리케이션의 성능을 더욱 향상시킵니다.

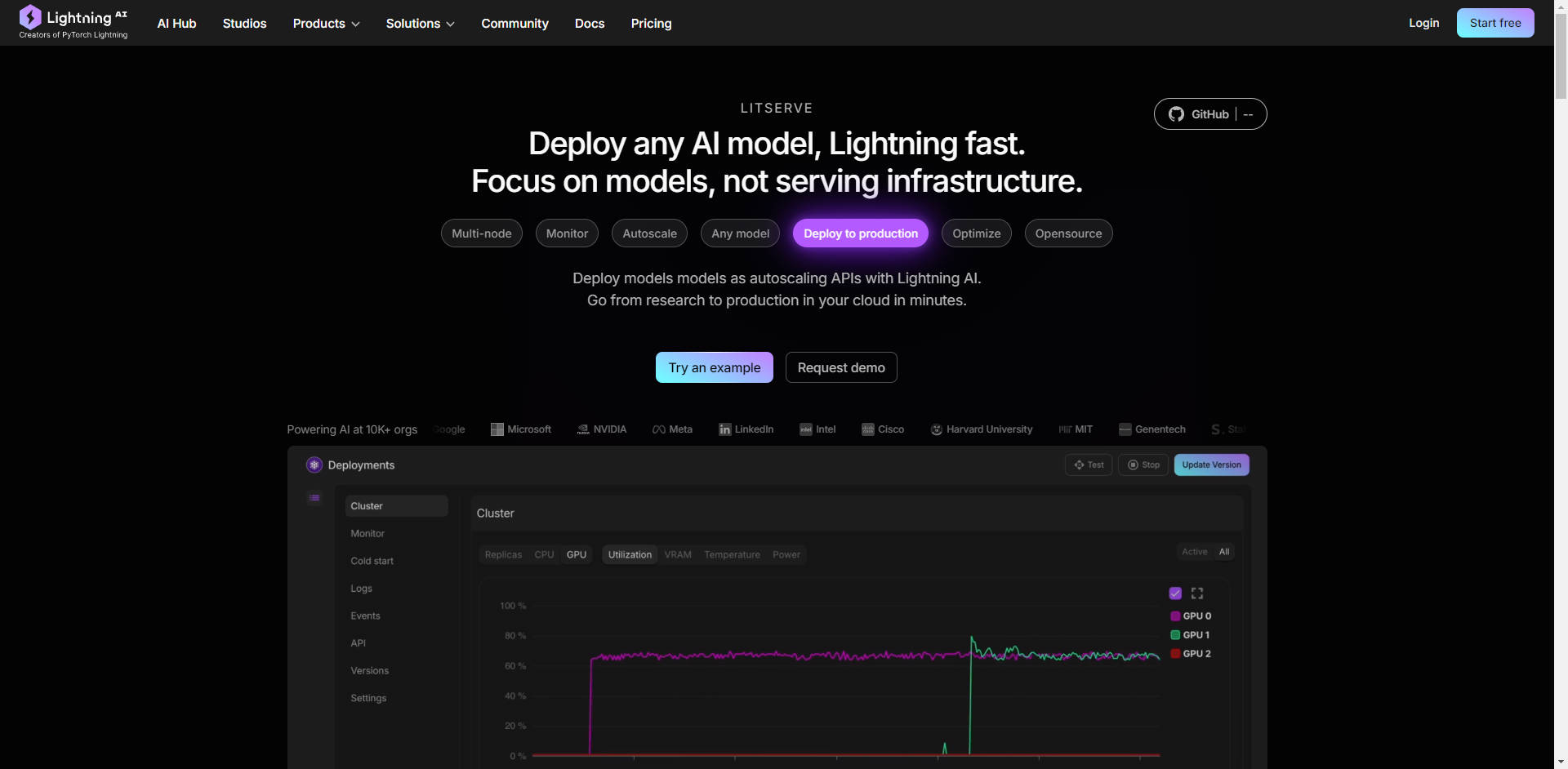

☁️ 완벽한 제어로 어디든 배포: 배포 환경을 선택하십시오. 완벽한 제어를 위해 자체 인프라에서 LitServe를 실행하거나, 자동 모니터링, 자동 확장 및 내결함성을 위해 Lightning AI의 관리형 플랫폼을 활용하십시오.

사용 사례:

높은 처리량의 텍스트 생성: 마케팅 카피 생성을 위한 맞춤형 대규모 언어 모델(LLM)을 개발했다고 가정해 보겠습니다. LitServe를 사용하면 서버 병목 현상에 대한 걱정 없이 전체 마케팅 팀을 위해 빠른 콘텐츠 생성을 보장하면서 수천 건의 동시 요청을 처리하도록 이 모델을 배포할 수 있습니다.

실시간 이미지 처리: 보안 카메라의 이미지를 실시간으로 분석하기 위해 컴퓨터 비전 모델을 구축했습니다. LitServe를 사용하면 엣지 장치 또는 클라우드에 이 모델을 배포하여 여러 비디오 스트림을 동시에 처리하고 중요한 이벤트에 대한 즉각적인 경고를 제공할 수 있습니다. 이는 모두 다중 GPU 지원 및 최적화된 서빙을 통해 달성됩니다.

고객 지원을 위한 복합 AI 시스템: 먼저 고객 음성 문의를 전사(음성-텍스트 모델 사용)한 다음, 감정과 의도를 분석하고(NLP 모델 사용), 마지막으로 개인화된 응답을 생성(LLM 사용)하는 시스템이 필요합니다. LitServe를 사용하면 이러한 모델을 완벽하게 연결하여 강력하고 효율적인 고객 지원 솔루션을 만들 수 있습니다.

결론:

LitServe는 모델 개발에서 프로덕션 배포로 전례 없는 속도와 효율성으로 전환할 수 있도록 지원합니다. 유연한 아키텍처는 강력한 확장 기능 및 모든 AI 모델에 대한 지원과 결합되어 AI 혁신을 세상에 선보이려는 개발자에게 이상적인 솔루션입니다. 인프라와의 싸움을 멈추고 AI라는 본질에 집중하십시오.

FAQ:

LitServe와 vLLM의 차이점은 무엇입니까?

LitServe는 vLLM과 같은 서버보다 더 낮은 수준의 추상화에서 작동합니다. LitServe를 맞춤형 vLLM 서버와 같은 특수 서빙 솔루션을 구축할 수 있는 기본 도구로 생각하십시오. vLLM은 LLM에 특별히 최적화된 사전 구축된 솔루션인 반면, LitServe는 모든 유형의 AI 모델에 대해 더 광범위한 유연성을 제공합니다.

기존 FastAPI 프로젝트에서 LitServe를 사용할 수 있습니까?

예, LitServe는 FastAPI를 기반으로 구축되었으며 쉽게 통합되도록 설계되었습니다. AI 관련 기능으로 FastAPI를 보강하여 모델 서빙을 위한 성능과 확장성을 향상시킵니다.

LitServe를 사용하는 데 필요한 기술 전문성 수준은 어느 정도입니까?

LitServe는 Python 사용에 익숙하고 머신러닝 모델 배포에 대한 지식이 있는 AI 개발자 및 엔지니어를 위해 설계되었습니다. 제공된 코드 예제와 설명서는 딥러닝 인프라 전문가가 아니더라도 쉽게 시작할 수 있도록 해줍니다.

LitServe를 통해 예상할 수 있는 비용 절감 효과는 어느 정도입니까? LitServe에는 scale-to-zero(서버리스), 중단 가능한 인스턴스, 일괄 처리 및 스트리밍과 같은 기능이 있어 서빙 비용을 획기적으로 줄일 수 있습니다. 예를 들어 $1로 Llama 3.1은 366,000개의 토큰을 얻고 chatGPT는 25,000개의 토큰을 얻습니다. 또한 이 모델은 전용 용량으로 안전한 클라우드에서 실행됩니다.

Lightning AI 플랫폼에서 LitServe를 사용하면 어떤 이점이 있습니까?

Lightning AI에 배포하면 자동 모니터링, 자동 확장(0에서 수천 개의 GPU로), 내결함성 및 간소화된 관리를 비롯한 추가적인 이점을 얻을 수 있습니다. 배포 프로세스를 간소화하고 엔터프라이즈급 기능을 제공합니다.