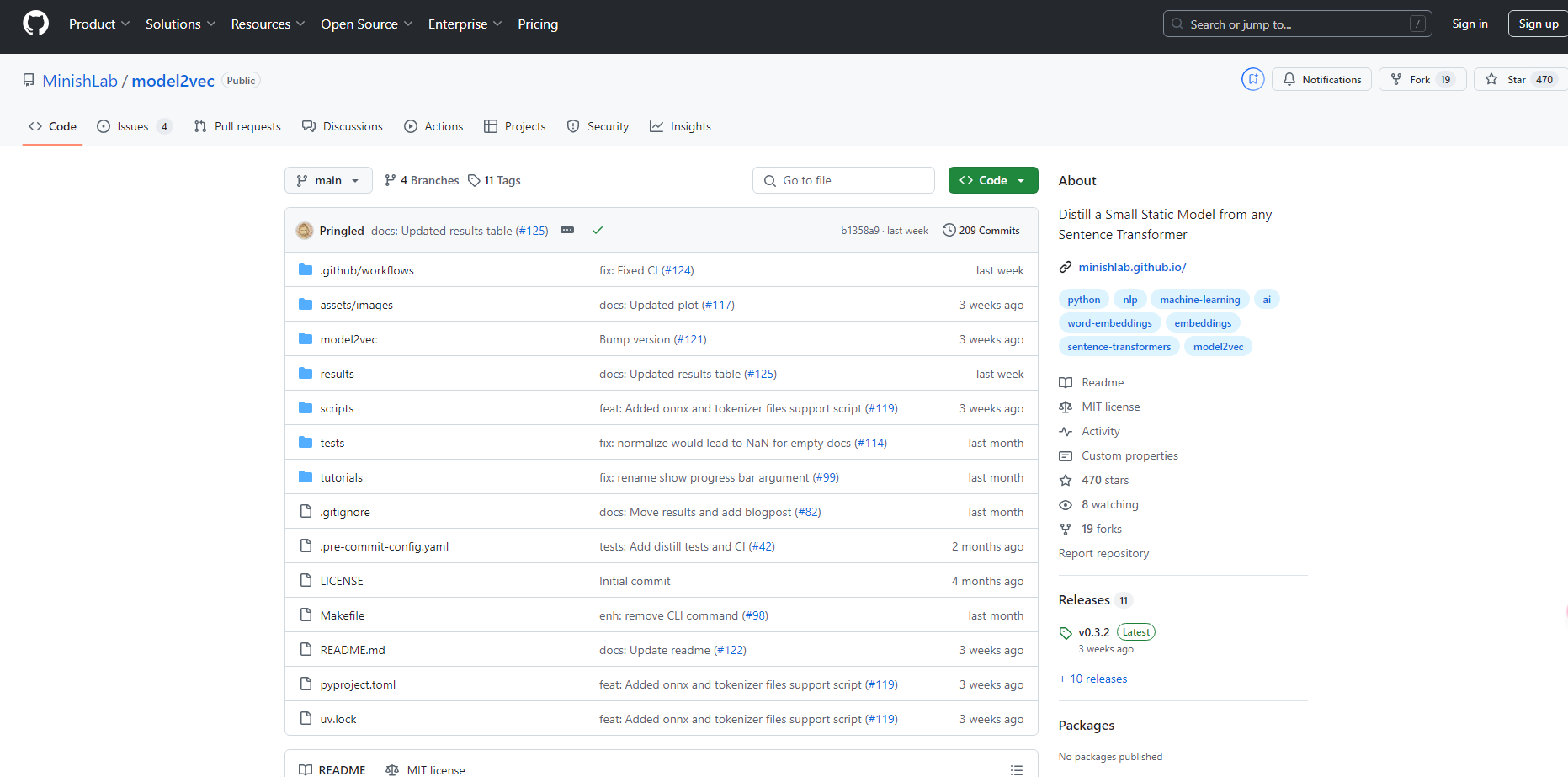

What is Model2vec?

Model2Vec es una técnica innovadora que transforma cualquier Sentence Transformer en un modelo compacto y estático. Al reducir el tamaño del modelo hasta en 15 veces y aumentar la velocidad de inferencia hasta 500 veces, Model2Vec permite disponer de modelos de alto rendimiento que son a la vez rápidos y pequeños. A pesar de una pequeña reducción en el rendimiento, Model2Vec sigue siendo el modelo de incrustación estática más eficiente disponible, superando a alternativas como GLoVe y BPEmb.

Características principales:

?️ Modelos Compactos: Reduce el tamaño de Sentence Transformer en 15 veces, pasando de un modelo de 120M de parámetros a solo 7.5M (30 MB en disco).

⚡ Inferencia ultrarrápida: Alcanza velocidades de inferencia hasta 500 veces más rápidas en CPUs, haciendo las tareas a gran escala más rápidas y ecológicas.

?️ No se requieren datos: La destilación se realiza a nivel de token, eliminando la necesidad de conjuntos de datos durante la creación del modelo.

? Soporte multilingüe: Funciona perfectamente con cualquier idioma, permitiendo un uso versátil en diferentes contextos lingüísticos.

Casos de uso:

Prototipado rápido: Los desarrolladores pueden crear rápidamente modelos pequeños y eficientes para pruebas e implementación sin sacrificar el rendimiento.

Proyectos de PNL multilingües: Los equipos que trabajan en tareas de procesamiento del lenguaje natural multilingüe pueden cambiar fácilmente entre idiomas y vocabularios.

Entornos con recursos limitados: Las organizaciones con recursos computacionales limitados pueden aprovechar modelos rápidos y pequeños para ejecutar aplicaciones de PNL sin problemas en CPUs.

Conclusión:

Model2Vec ofrece una solución innovadora para quienes necesitan modelos Sentence Transformer rápidos, compactos y de alto rendimiento. Al reducir significativamente el tamaño del modelo y aumentar la velocidad de inferencia, permite una implementación eficiente en diversas aplicaciones sin una caída importante en el rendimiento. Sus capacidades multilingües y su facilidad de uso aumentan aún más su atractivo, convirtiéndolo en una opción ideal para los profesionales de PNL.

Preguntas frecuentes:

¿Cuánto más pequeño puede hacer Model2Vec mi modelo Sentence Transformer?

Model2Vec reduce el tamaño del modelo en un factor de 15, convirtiendo un modelo de 120M de parámetros en uno de 7.5M de parámetros.¿Requiere el uso de Model2Vec un conjunto de datos para la destilación del modelo?

No, Model2Vec destila modelos a nivel de token, por lo que no se necesita ningún conjunto de datos para el proceso de destilación.¿Puedo usar Model2Vec para tareas de PNL multilingües?

Sí, Model2Vec admite cualquier idioma, lo que lo hace ideal para proyectos de PNL multilingües.

More information on Model2vec

Model2vec Alternativas

Model2vec Alternativas-

KTransformers, un proyecto de código abierto del equipo KVCache.AI de Tsinghua y QuJing Tech, optimiza la inferencia de modelos de lenguaje grandes. Reduce los umbrales de hardware, ejecuta modelos de 671B parámetros en GPUs individuales de 24GB de VRAM, aumenta la velocidad de inferencia (hasta 286 tokens/s en pre-procesamiento, 14 tokens/s en generación) y es adecuado para uso personal, empresarial y académico.

-

Investigación en curso para entrenar modelos Transformer a escala

-

VectorDB es una solución simple, ligera, completamente local y de extremo a extremo para usar la recuperación de texto basada en incrustaciones.

-

DeepSeek-VL2, un modelo de visión-lenguaje de DeepSeek-AI, procesa imágenes de alta resolución, ofrece respuestas rápidas con MLA y sobresale en diversas tareas visuales como VQA y OCR. Ideal para investigadores, desarrolladores y analistas de BI.

-

SmolLM es una serie de modelos de lenguaje pequeños de última generación disponibles en tres tamaños: 135M, 360M y 1.7B parámetros.