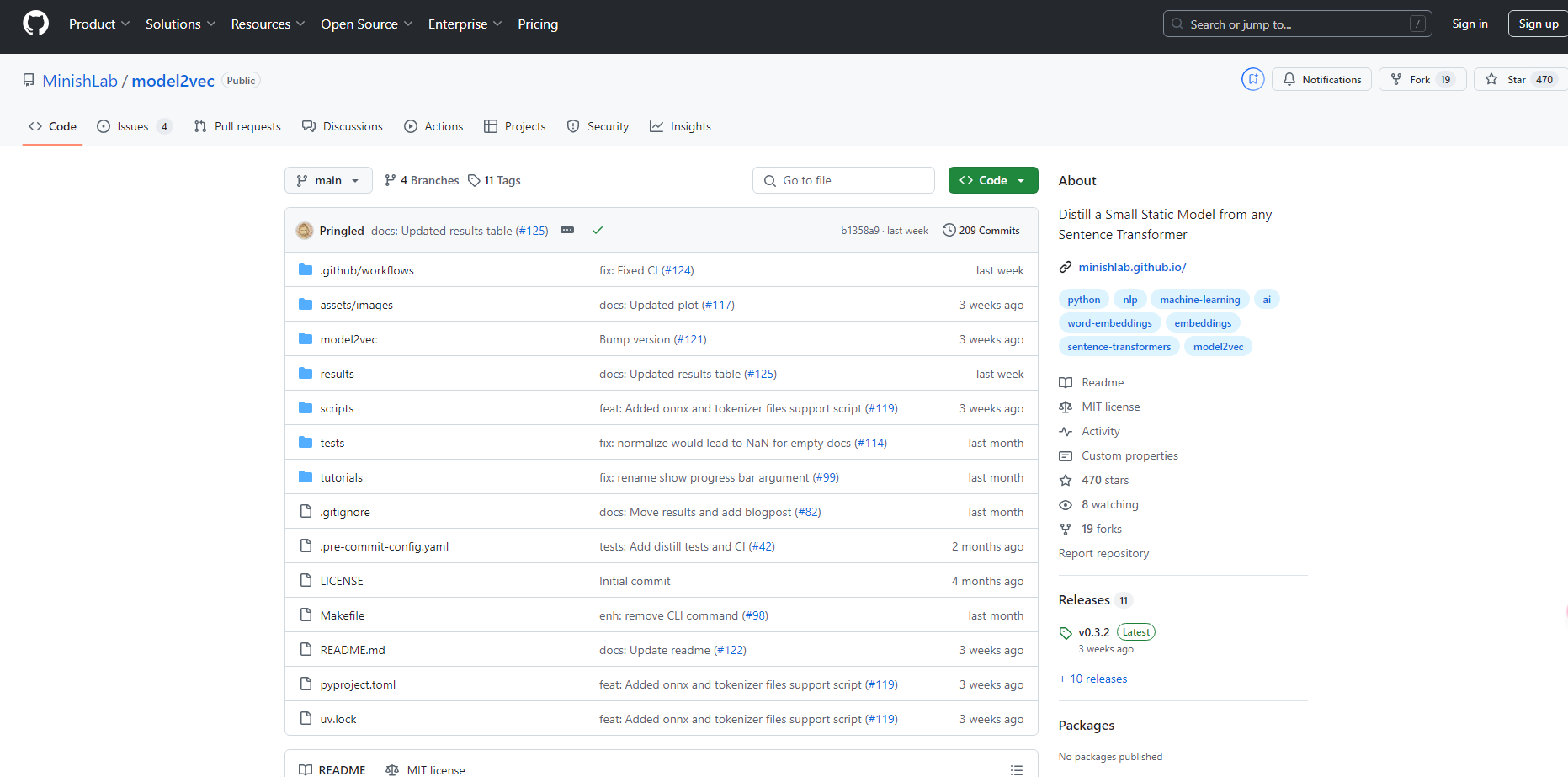

What is Model2vec?

Model2Vec 是一项突破性技术,可将任何 Sentence Transformer 转换为紧凑的静态模型。通过将模型大小减少高达 15 倍,并将推理速度提高 500 倍,Model2Vec 使得拥有高性能、快速且小型模型成为可能。尽管性能略有下降,但 Model2Vec 仍然是目前最高效的静态嵌入模型,其性能优于 GLoVe 和 BPEmb 等替代方案。

主要特性:

?️ 紧凑型模型:将 Sentence Transformer 的大小缩小 15 倍,将一个拥有 1.2 亿参数的模型缩小到仅 750 万参数(磁盘占用空间为 30 MB)。

⚡ 闪电般快速的推理速度:在 CPU 上实现高达 500 倍的推理速度提升,使大规模任务更快、更环保。

?️ 无需数据:蒸馏发生在词元级别,无需在模型创建过程中使用数据集。

? 多语言支持:可与任何语言无缝协作,允许在不同的语言环境中灵活使用。

应用案例:

快速原型设计:开发人员可以快速创建小型、高效的模型用于测试和部署,而不会牺牲性能。

多语言 NLP 项目:从事多语言自然语言处理任务的团队可以轻松地在不同的语言和词汇之间切换。

资源受限的环境:计算资源有限的组织可以使用快速且小型模型在 CPU 上顺利运行 NLP 应用程序。

总结:

对于需要快速、紧凑且高性能 Sentence Transformer 模型的用户而言,Model2Vec 提供了一种创新的解决方案。通过显著减小模型大小并提高推理速度,它允许在各种应用程序中高效部署,而不会造成性能大幅下降。其多语言功能和易用性进一步增强了其吸引力,使其成为 NLP 从业者的首选。

常见问题:

Model2Vec 可以将我的 Sentence Transformer 模型缩小多少?

Model2Vec 将模型大小缩小 15 倍,将一个拥有 1.2 亿参数的模型缩小到 750 万参数。使用 Model2Vec 是否需要数据集进行模型蒸馏?

不需要,Model2Vec 在词元级别进行模型蒸馏,因此蒸馏过程不需要数据集。我可以将 Model2Vec 用于多语言 NLP 任务吗?

可以,Model2Vec 支持任何语言,使其成为多语言 NLP 项目的理想选择。

More information on Model2vec

Model2vec 替代方案

更多 替代方案-

KTransformers 是由清华大学 KVCache.AI 团队和 QuJing Tech 共同开发的开源项目,旨在优化大型语言模型的推理过程。它能够降低硬件门槛,在 24GB 显存的单 GPU 上运行 6710 亿参数的模型,并提升推理速度(预处理速度高达 286 tokens/s,生成速度高达 14 tokens/s),适用于个人、企业和学术用途。

-

-

-

DeepSeek-VL2,是由 DeepSeek-AI 开发的视觉-语言模型,能够处理高分辨率图像,并借助 MLA 技术提供快速响应,在视觉问答 (VQA) 和光学字符识别 (OCR) 等多种视觉任务中表现出色。它是研究人员、开发者和商业智能 (BI) 分析师的理想之选。

-