What is Model2vec?

Model2Vec 是一項突破性的技術,能將任何 Sentence Transformer 轉換成精簡、靜態的模型。透過將模型大小縮減高達 15 倍,並將推論速度提升 500 倍,Model2Vec 使得高性能模型兼具快速和小巧的特性成為可能。儘管效能略有下降,但 Model2Vec 仍然是目前最有效率的靜態嵌入模型,其表現超越 GLoVe 和 BPEmb 等替代方案。

主要功能:

?️ 精簡模型:將 Sentence Transformer 的大小縮減 15 倍,例如將一個 1.2 億參數的模型縮小到僅 750 萬參數(磁碟空間約 30 MB)。

⚡ 極速推論:在 CPU 上實現高達 500 倍的推論速度提升,讓大型任務執行更快、更環保。

?️ 無需數據:蒸餾過程在 token 層級進行,因此在模型建立過程中無需數據集。

? 多語言支援:能無縫支援任何語言,適用於各種不同的語言環境。

應用案例:

快速原型設計:開發者可以快速建立小巧高效的模型進行測試和部署,而無需犧牲效能。

多語言 NLP 專案:從事多語言自然語言處理任務的團隊可以輕鬆地在不同語言和詞彙之間切換。

資源受限環境:計算資源有限的組織可以利用快速且小巧的模型,在 CPU 上順利運行 NLP 應用程式。

結論:

Model2Vec 為需要快速、精簡且高性能 Sentence Transformer 模型的使用者提供創新的解決方案。透過大幅縮減模型大小和提升推論速度,它允許在各種應用程式中高效部署,而不會造成效能大幅下降。其多語言功能和易用性進一步提升了它的吸引力,使其成為 NLP 從業者的首選。

常見問題:

Model2Vec 能將我的 Sentence Transformer 模型縮小多少?

Model2Vec 將模型大小縮減 15 倍,將一個 1.2 億參數的模型轉換成一個 750 萬參數的模型。使用 Model2Vec 是否需要數據集進行模型蒸餾?

不需要,Model2Vec 在 token 層級進行模型蒸餾,因此蒸餾過程不需要數據集。我可以將 Model2Vec 用於多語言 NLP 任務嗎?

可以,Model2Vec 支援任何語言,使其成為多語言 NLP 專案的理想選擇。

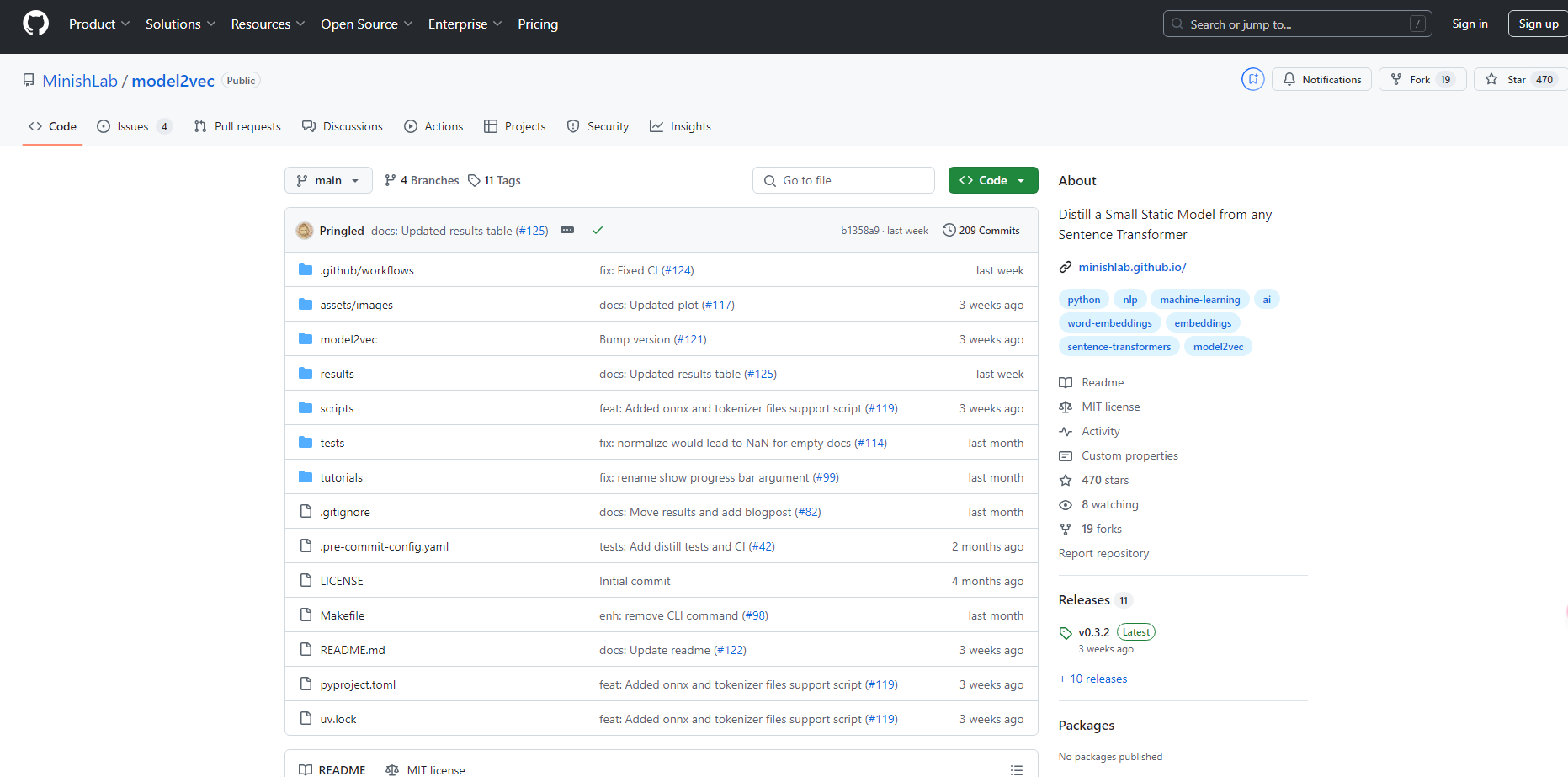

More information on Model2vec

Model2vec 替代方案

更多 替代方案-

KTransformers 是由清華大學 KVCache.AI 團隊與 QuJing Tech 共同開發的開源專案,旨在優化大型語言模型的推論過程。它能降低硬體門檻,讓使用者僅需配備 24GB 顯示記憶體的單張 GPU,即可運行 6710 億參數的模型。此外,它還能大幅提升推論速度(預處理階段最高可達每秒 286 個 tokens,生成階段最高可達每秒 14 個 tokens),非常適合個人、企業以及學術機構使用。

-

-

-

DeepSeek-VL2 是由 DeepSeek-AI 開發的視覺語言模型,它能夠處理高解析度的圖像,並透過 MLA 提供快速的回應。DeepSeek-VL2 在各種視覺任務中表現出色,例如 VQA 和 OCR。對於研究人員、開發者和 BI 分析師來說,DeepSeek-VL2 是一個理想的選擇。

-