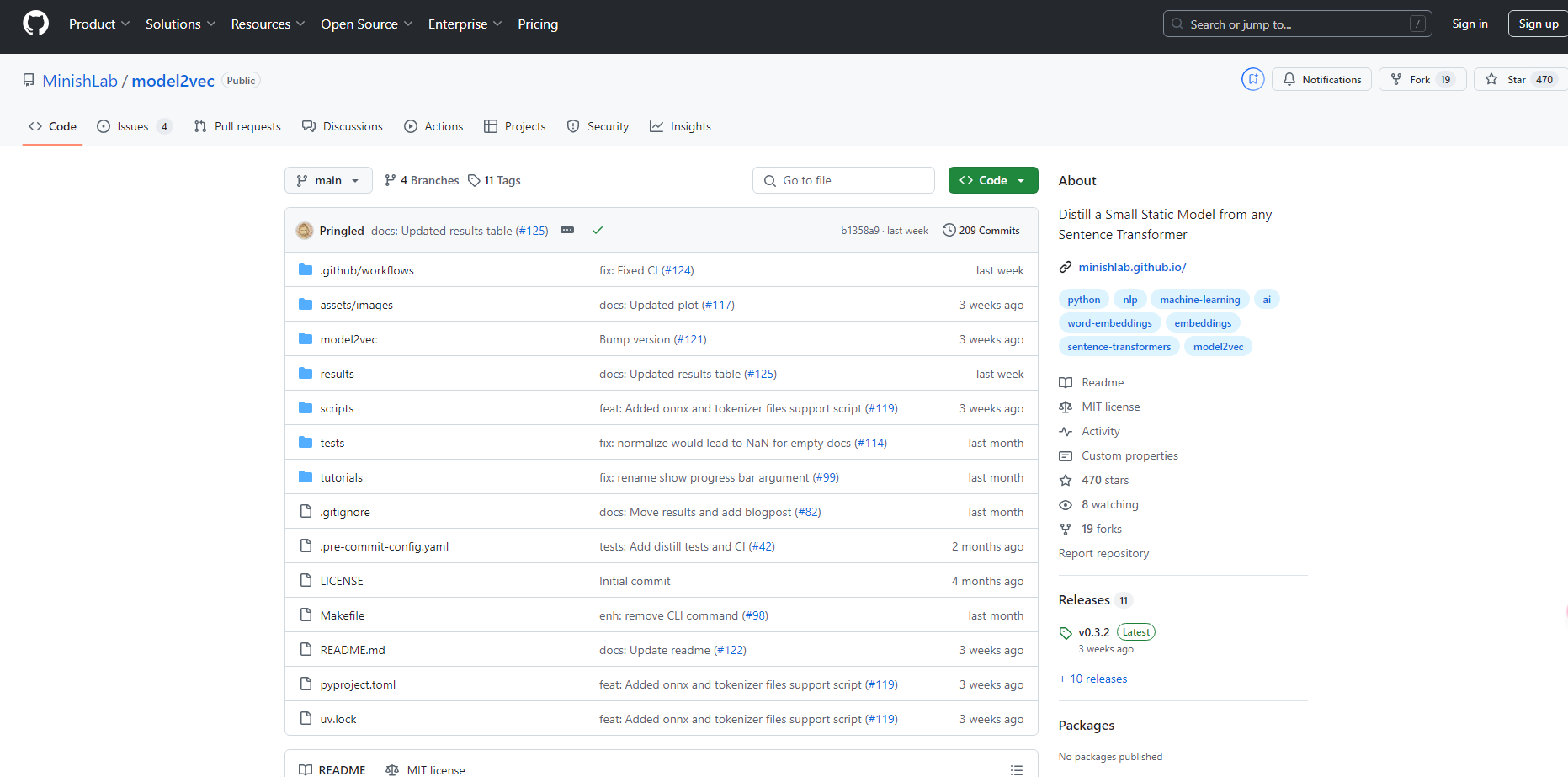

What is Model2vec?

Model2Vecは、あらゆるSentence Transformerをコンパクトで静的なモデルに変換する画期的な技術です。モデルサイズを最大15倍削減し、推論速度を500倍向上させることで、高速かつ小型で高性能なモデルを実現します。性能がわずかに低下するものの、Model2Vecは依然として、GLoVeやBPEmbなどの代替手段を凌駕する、最も効率的な静的埋め込みモデルです。

主な特長:

?️ コンパクトなモデル:Sentence Transformerのサイズを15倍縮小し、1億2000万パラメータのモデルをわずか750万パラメータ(ディスク上では30MB)に削減します。

⚡ 超高速推論:CPU上で最大500倍高速な推論速度を実現し、大規模なタスクを迅速かつ環境に優しく実行できます。

?️ データ不要:トークンレベルで蒸留が行われるため、モデル作成時にデータセットは必要ありません。

? 多言語対応:あらゆる言語でシームレスに動作し、さまざまな言語環境で多用途に使用できます。

ユースケース:

迅速なプロトタイピング:開発者は、パフォーマンスを犠牲にすることなく、テストと展開のために迅速に小型で効率的なモデルを作成できます。

多言語NLPプロジェクト:多言語自然言語処理タスクに取り組むチームは、言語や語彙を容易に切り替えることができます。

リソース制約のある環境:計算リソースが限られている組織は、高速で小型のモデルを活用して、CPU上でNLPアプリケーションを円滑に実行できます。

結論:

Model2Vecは、高速でコンパクト、そして高性能なSentence Transformerモデルを必要とする方のための革新的なソリューションを提供します。モデルサイズを削減し、推論速度を大幅に向上させることで、パフォーマンスの大幅な低下なしに、さまざまなアプリケーションへの効率的な展開を可能にします。その多言語対応機能と使いやすさは、さらにその魅力を高め、NLPの実務者にとって最適な選択肢となっています。

よくある質問:

Model2VecはSentence Transformerモデルをどの程度小さくできますか?

Model2Vecはモデルサイズを15分の1に削減し、1億2000万パラメータのモデルを750万パラメータのモデルにします。Model2Vecを使用するには、モデル蒸留のためのデータセットが必要ですか?

いいえ、Model2Vecはトークンレベルでモデルを蒸留するため、蒸留プロセスにはデータセットは必要ありません。Model2Vecを多言語NLPタスクに使用できますか?

はい、Model2Vecはあらゆる言語に対応しているため、多言語NLPプロジェクトに最適です。

More information on Model2vec

Model2vec 代替ソフト

もっと見る 代替ソフト-

Tsinghua大学のKVCache.AIチームとQuJing Techが開発したオープンソースプロジェクト、KTransformersは、大規模言語モデルの推論を最適化します。ハードウェアの敷居を下げ、24GB VRAMのシングルGPU上で671Bパラメータのモデルを実行可能にし、推論速度を向上(前処理最大286トークン/秒、生成最大14トークン/秒)させ、個人利用、企業利用、学術利用に適しています。

-

-

-

DeepSeek-AIが開発したビジョン・言語モデル、DeepSeek-VL2は、高解像度画像を処理し、MLAによる高速応答を提供、VQAやOCRなど多様な視覚タスクで優れた性能を発揮します。研究者、開発者、そしてBIアナリストにとって理想的なツールです。

-