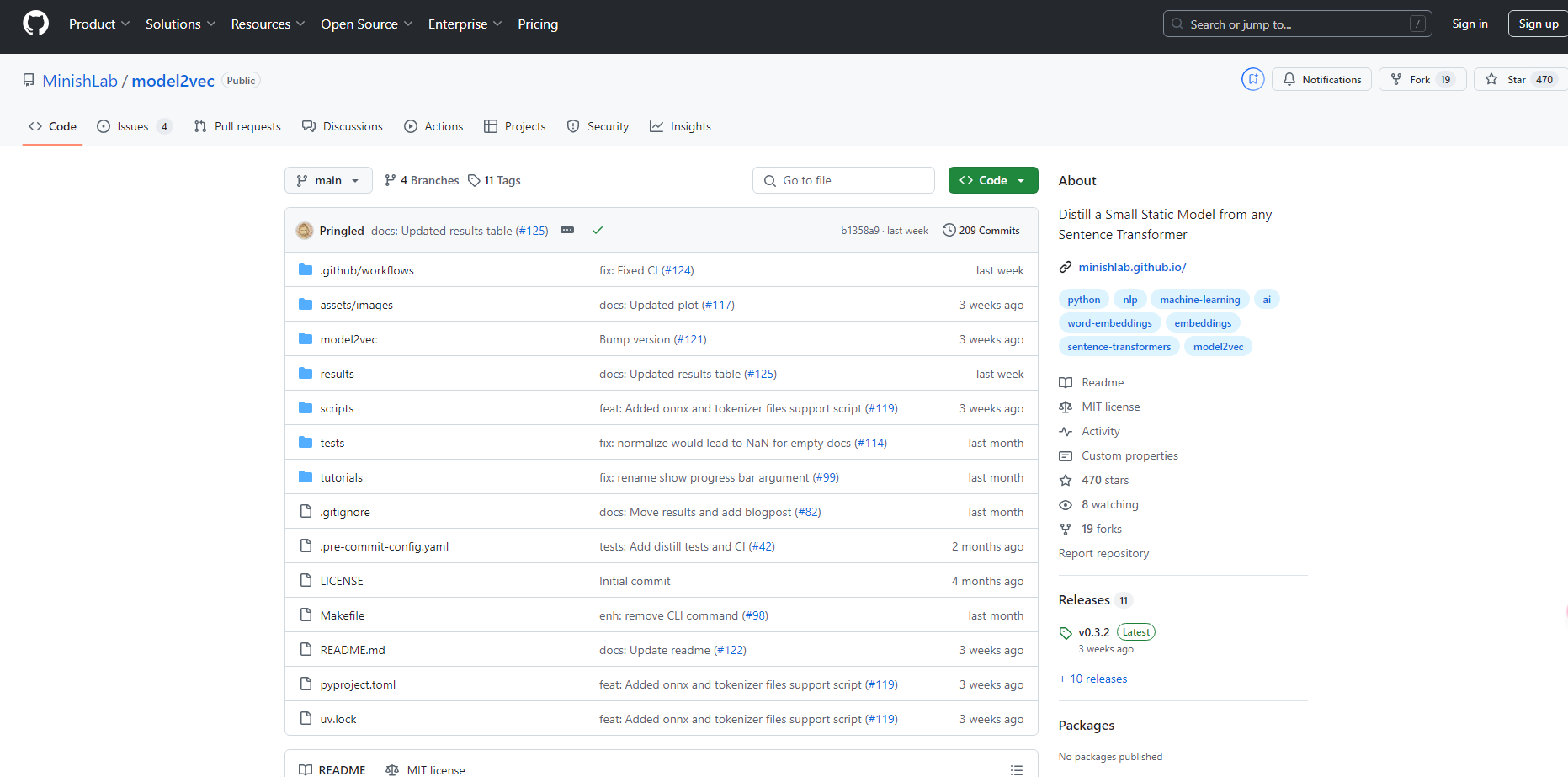

What is Model2vec?

Model2Vec은 어떤 Sentence Transformer라도 작고 정적인 모델로 변환하는 획기적인 기술입니다. 모델 크기를 최대 15배까지 줄이고 추론 속도를 500배까지 높여 빠르고 작으면서도 성능이 뛰어난 모델을 구현할 수 있도록 합니다. 성능이 약간 저하되기는 하지만, Model2Vec은 GLoVe나 BPEmb와 같은 다른 대안보다 뛰어난 가장 효율적인 정적 임베딩 모델입니다.

주요 기능:

?️ 압축된 모델: Sentence Transformer 크기를 15배 축소하여 1억 2천만 개 매개변수 모델을 750만 개(디스크에서 30MB)로 줄입니다.

⚡ 초고속 추론: CPU에서 최대 500배 빠른 추론 속도를 달성하여 대규모 작업을 더 빠르고 친환경적으로 만듭니다.

?️ 데이터 불필요: 토큰 수준에서 증류가 이루어지므로 모델 생성 중에 데이터셋이 필요하지 않습니다.

? 다국어 지원: 모든 언어에서 원활하게 작동하여 다양한 언어적 맥락에서 다용도로 사용할 수 있습니다.

활용 사례:

빠른 프로토타이핑: 개발자는 성능 저하 없이 테스트 및 배포를 위한 작고 효율적인 모델을 신속하게 생성할 수 있습니다.

다국어 NLP 프로젝트: 다국어 자연어 처리 작업을 수행하는 팀은 언어와 어휘를 쉽게 전환할 수 있습니다.

자원 제약 환경: 제한된 컴퓨팅 자원을 가진 조직은 빠르고 작은 모델을 활용하여 CPU에서 NLP 애플리케이션을 원활하게 실행할 수 있습니다.

결론:

Model2Vec은 빠르고, 작고, 성능이 뛰어난 Sentence Transformer 모델이 필요한 사용자를 위한 혁신적인 솔루션을 제공합니다. 모델 크기를 줄이고 추론 속도를 크게 높임으로써 성능 저하 없이 다양한 애플리케이션에 효율적으로 배포할 수 있습니다. 다국어 기능과 사용 편의성은 Model2Vec의 매력을 더욱 높여 NLP 실무자에게 최고의 선택이 되도록 합니다.

FAQ:

Model2Vec으로 Sentence Transformer 모델을 얼마나 작게 만들 수 있습니까?

Model2Vec은 모델 크기를 15배 줄여 1억 2천만 개 매개변수 모델을 750만 개 매개변수 모델로 만듭니다.Model2Vec을 사용하려면 모델 증류를 위한 데이터셋이 필요합니까?

아니요, Model2Vec은 토큰 수준에서 모델을 증류하므로 증류 과정에 데이터셋이 필요하지 않습니다.다국어 NLP 작업에 Model2Vec을 사용할 수 있습니까?

네, Model2Vec은 모든 언어를 지원하므로 다국어 NLP 프로젝트에 이상적입니다.

More information on Model2vec

Model2vec 대체품

더보기 대체품-

Tsinghua 대학의 KVCache.AI 팀과 QuJing Tech에서 개발한 오픈 소스 프로젝트인 KTransformers는 대규모 언어 모델 추론을 최적화합니다. 하드웨어 제약 조건을 낮추고, 24GB VRAM의 단일 GPU에서 6710억 개 파라미터 모델을 실행하며, 추론 속도를 향상(전처리 최대 286 토큰/초, 생성 최대 14 토큰/초)시켜 개인, 기업 및 학술 용도에 적합합니다.

-

-

-

DeepSeek-AI에서 개발한 시각-언어 모델인 DeepSeek-VL2는 고해상도 이미지를 처리하고, MLA를 통해 빠른 응답을 제공하며, VQA 및 OCR과 같은 다양한 시각적 작업에서 뛰어난 성능을 자랑합니다. 연구원, 개발자 및 BI 분석가에게 이상적입니다.

-