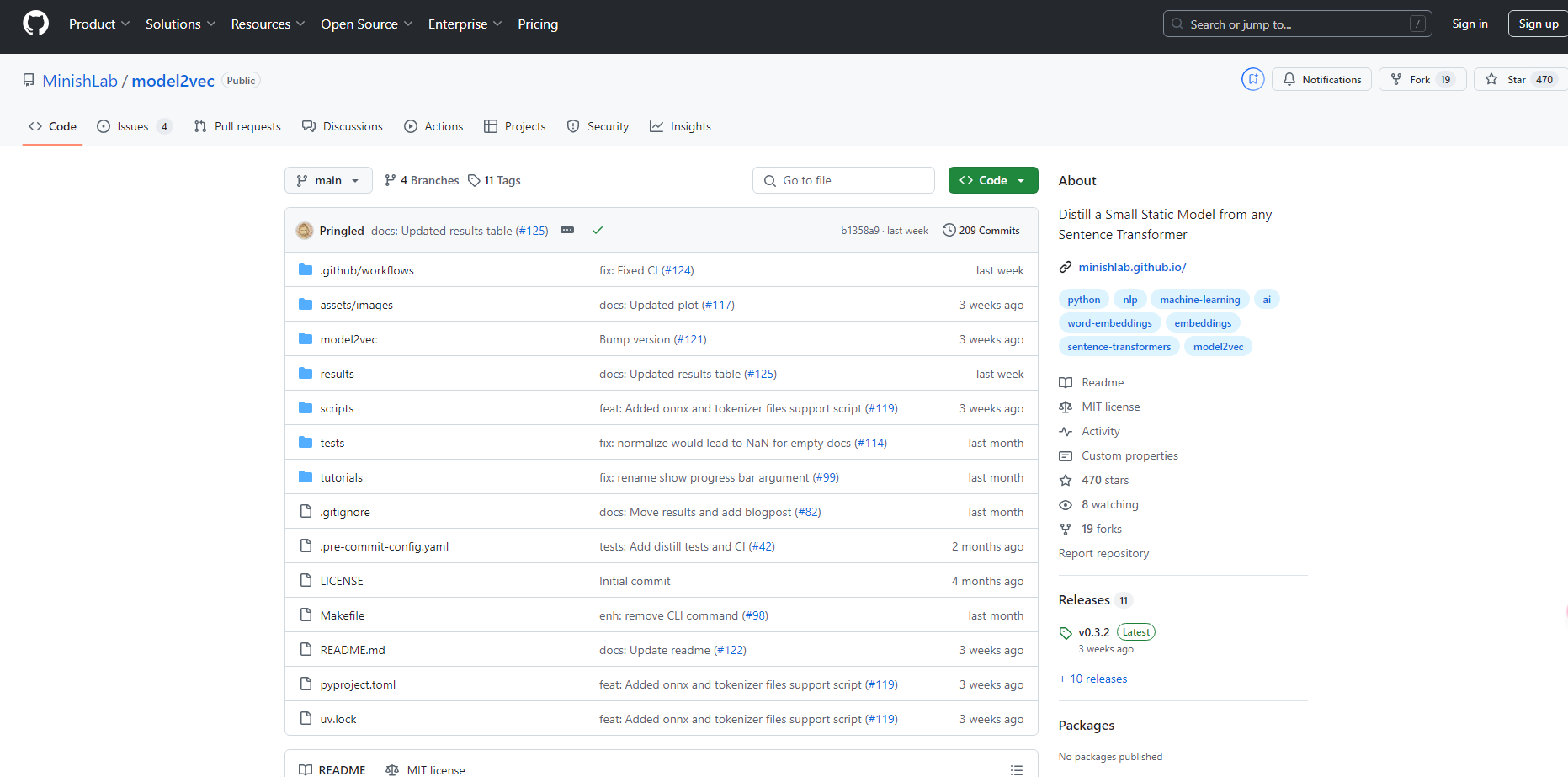

What is Model2vec?

Model2Vec est une technique révolutionnaire qui transforme n'importe quel Sentence Transformer en un modèle statique compact. En réduisant la taille du modèle jusqu'à 15 fois et en augmentant la vitesse d'inférence de 500 fois, Model2Vec permet d'obtenir des modèles performants, à la fois rapides et légers. Malgré une légère réduction des performances, Model2Vec reste le modèle d'embedding statique le plus efficace disponible, surpassant des alternatives telles que GLoVe et BPEmb.

Fonctionnalités clés :

?️ Modèles compacts : Réduit la taille du Sentence Transformer de 15 fois, passant d'un modèle à 120 millions de paramètres à seulement 7,5 millions (30 Mo sur disque).

⚡ Inférence ultrarapide : Atteint des vitesses d'inférence jusqu'à 500 fois plus rapides sur les processeurs, rendant les tâches à grande échelle plus rapides et plus écologiques.

?️ Aucune donnée requise : La distillation s'effectue au niveau des jetons, éliminant le besoin de jeux de données lors de la création du modèle.

? Support multilingue : Fonctionne parfaitement avec n'importe quelle langue, permettant une utilisation polyvalente dans différents contextes linguistiques.

Cas d'utilisation :

Prototypage rapide : Les développeurs peuvent rapidement créer des modèles petits et efficaces pour les tests et le déploiement sans sacrifier les performances.

Projets de PNL multilingues : Les équipes travaillant sur des tâches de traitement du langage naturel multilingue peuvent facilement passer d'une langue à l'autre et adapter les vocabulaires.

Environnements aux ressources limitées : Les organisations disposant de ressources informatiques limitées peuvent exploiter des modèles rapides et légers pour exécuter des applications de PNL en douceur sur les processeurs.

Conclusion :

Model2Vec offre une solution innovante pour ceux qui ont besoin de modèles Sentence Transformer rapides, compacts et performants. En réduisant considérablement la taille du modèle et en augmentant la vitesse d'inférence, il permet un déploiement efficace dans diverses applications sans perte de performance majeure. Ses capacités multilingues et sa facilité d'utilisation renforcent encore son attrait, ce qui en fait un choix privilégié pour les praticiens de la PNL.

FAQ :

De combien Model2Vec peut-il réduire la taille de mon modèle Sentence Transformer ?

Model2Vec réduit la taille du modèle d'un facteur 15, transformant un modèle à 120 millions de paramètres en un modèle à 7,5 millions de paramètres.L'utilisation de Model2Vec nécessite-t-elle un jeu de données pour la distillation du modèle ?

Non, Model2Vec distille les modèles au niveau des jetons, aucun jeu de données n'est donc nécessaire pour le processus de distillation.Puis-je utiliser Model2Vec pour des tâches de PNL multilingues ?

Oui, Model2Vec prend en charge toutes les langues, ce qui le rend idéal pour les projets de PNL multilingues.

More information on Model2vec

Model2vec alternatives

Model2vec alternatives-

KTransformers, un projet open source de l'équipe KVCache.AI de Tsinghua et de QuJing Tech, optimise l'inférence des grands modèles de langage. Il réduit les seuils matériels, permet d'exécuter des modèles de 671 milliards de paramètres sur des GPU uniques de 24 Go de VRAM, accélère la vitesse d'inférence (jusqu'à 286 tokens/s en pré-traitement, 14 tokens/s en génération) et convient à un usage personnel, professionnel et académique.

-

Formation de recherche en cours sur les modèles de transformateur à grande échelle

-

VectorDB est une solution simple, légère, entièrement locale et complète pour utiliser la récupération de texte basée sur les plongements.

-

DeepSeek-VL2, un modèle vision-langage développé par DeepSeek-AI, traite des images haute résolution, offre des réponses rapides grâce à MLA et excelle dans diverses tâches visuelles telles que le VQA et l'OCR. Il est idéal pour les chercheurs, les développeurs et les analystes BI.

-

SmolLM est une série de modèles de langage de pointe de petite taille disponibles en trois tailles : 135 M, 360 M et 1,7 milliard de paramètres.