What is OLMo 2 32B?

OLMo 2 32B es un modelo de lenguaje grande (LLM) de última generación que establece un nuevo estándar para la IA de código abierto. A diferencia de muchos LLM potentes que son de código cerrado, OLMo 2 32B proporciona acceso completo a sus datos, código y pesos. Esta transparencia te permite construir, personalizar e investigar modelos de lenguaje avanzados con una libertad sin precedentes. Se ha desarrollado para resolver el problema del acceso limitado a LLM de alto rendimiento para investigadores y desarrolladores.

Características principales:

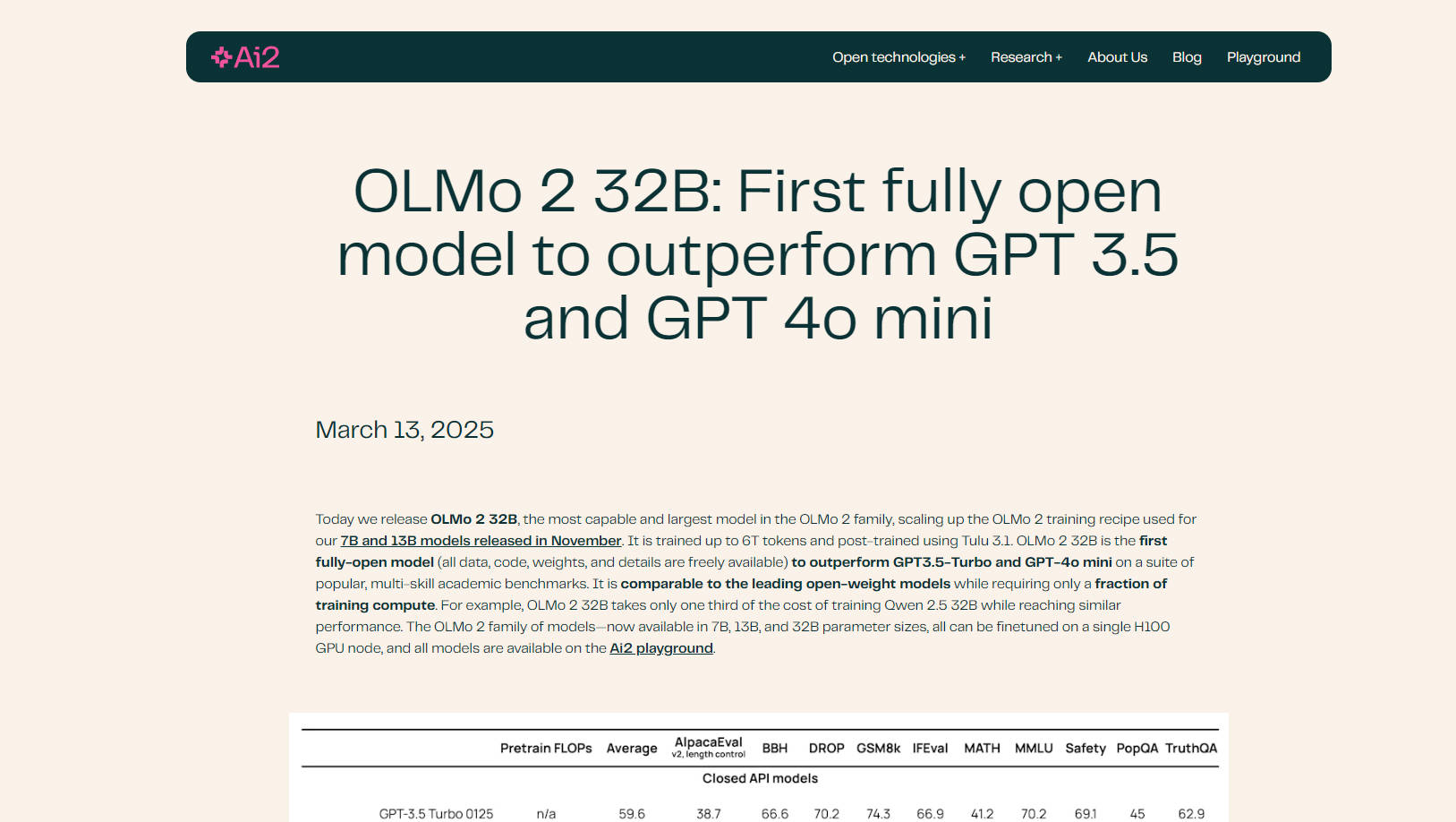

🤖 Supera a los modelos líderes: OLMo 2 32B supera a GPT-3.5 Turbo y GPT-4o mini en una variedad de evaluaciones académicas, lo que demuestra su comprensión y capacidades de generación de lenguaje superiores.

💻 Código completamente abierto: Obtén acceso completo a los datos de entrenamiento, el código, los pesos y la metodología del modelo. Esta transparencia permite una personalización y oportunidades de investigación sin precedentes.

⚙️ Entrenamiento eficiente: OLMo 2 32B logra su rendimiento con un coste computacional significativamente menor que el de los modelos comparables. Por ejemplo, requiere solo un tercio del coste de entrenamiento de Qwen 2.5 32B, al tiempo que logra resultados similares.

📚 Datos y preentrenamiento mejorados: Construido sobre una base de código de entrenamiento refinada (OLMo-core), OLMo 2 32B aprovecha conjuntos de datos extensos (OLMo-Mix-1124 y Dolmino) para un preentrenamiento y un entrenamiento intermedio completos.

🧠 Post-entrenamiento avanzado con RLVR: Incorpora el aprendizaje por refuerzo con recompensas verificables (RLVR) utilizando la optimización de políticas relativas grupales (GRPO), lo que mejora aún más su capacidad de seguir instrucciones y razonar.

⚡ Escalable y flexible: Diseñado para hardware moderno, OLMo-core admite paralelismo 4D+ y la creación de puntos de control de activación de grano fino, lo que lo hace adaptable a diversos escenarios de entrenamiento.

☁️ Optimizado para Google Cloud Engine: Entrenado en Augusta AI Hypercomputer de Google Cloud, lo que demuestra un rendimiento y una escalabilidad reales.

Casos de uso:

Investigación académica: Los investigadores pueden utilizar OLMo 2 32B para estudiar la dinámica del preentrenamiento, el impacto de los datos en el comportamiento del modelo y la interacción entre las diferentes etapas del entrenamiento. La naturaleza de código abierto facilita el análisis y la experimentación en profundidad. Por ejemplo, un investigador podría modificar los datos de entrenamiento para investigar cómo los tipos específicos de contenido influyen en la salida del modelo.

Desarrollo de LLM personalizado: Los desarrolladores pueden ajustar OLMo 2 32B en sus conjuntos de datos específicos para crear modelos de lenguaje personalizados para diversas aplicaciones, como chatbots, generación de contenido o herramientas de finalización de código. La compatibilidad del modelo con la biblioteca Transformers de Hugging Face y vLLM simplifica la integración en los flujos de trabajo existentes.

Seguimiento avanzado de instrucciones: El post-entrenamiento refinado, incluido RLVR, hace que OLMo 2 32B sea particularmente experto en la comprensión y la respuesta a instrucciones complejas. Esto es beneficioso para las tareas que requieren un razonamiento matizado o una generación de texto creativa. Por ejemplo, puedes probar las capacidades del modelo en problemas matemáticos complejos o dilemas éticos.

Conclusión:

OLMo 2 32B representa un avance significativo en los modelos de lenguaje de código abierto. Su rendimiento superior, su total transparencia y su entrenamiento eficiente lo convierten en una herramienta poderosa para los investigadores y desarrolladores que buscan superar los límites de la IA. Al proporcionar acceso completo a todos los aspectos del modelo, OLMo 2 32B fomenta la innovación y la colaboración dentro de la comunidad de la IA.

Preguntas frecuentes:

¿Qué hace que OLMo 2 32B sea "totalmente abierto"? Totalmente abierto significa que todos los componentes del modelo, incluidos los datos de entrenamiento, el código, los pesos y la metodología detallada, están disponibles públicamente. Este nivel de transparencia es poco común en el campo de los modelos de lenguaje grandes.

¿Cómo se compara el rendimiento de OLMo 2 32B con otros modelos de código abierto? OLMo 2 32B iguala o supera a los modelos líderes de peso abierto como Qwen 2.5 32B y Mistral 24B, al tiempo que requiere significativamente menos recursos computacionales para el entrenamiento.

¿Qué es OLMo-core? OLMo-core es el marco de entrenamiento recientemente desarrollado para OLMo 2 32B. Está diseñado para la eficiencia, la escalabilidad y la flexibilidad, y admite modelos más grandes, diferentes paradigmas de entrenamiento y modalidades más allá del texto.

¿Qué es RLVR y cómo beneficia al modelo? RLVR significa Reinforcement Learning with Verifiable Rewards (aprendizaje por refuerzo con recompensas verificables). Es una técnica que se utiliza durante el post-entrenamiento para mejorar la capacidad del modelo de seguir instrucciones y razonar eficazmente. Utiliza la optimización de políticas relativas grupales (GRPO) para un entrenamiento mejorado.

¿Puedo ajustar OLMo 2 32B en mis propios datos? Sí, una de las ventajas clave de OLMo 2 32B es su naturaleza de código abierto, que te permite ajustarlo en tus conjuntos de datos específicos para adaptar su rendimiento a tus necesidades. Es compatible con la biblioteca Transformers de HuggingFace.

¿Qué hardware se necesita para ejecutar OLMo 2 32b? Todos los modelos de la familia OLMo 2 (tamaños de parámetros de 7B, 13B y 32B) se pueden ajustar en un solo nodo de GPU H100.

More information on OLMo 2 32B

Top 5 Countries

Traffic Sources

OLMo 2 32B Alternativas

Más Alternativas-

Oumi es una plataforma completamente de código abierto que optimiza todo el ciclo de vida de los modelos fundacionales, desde la preparación y el entrenamiento de datos hasta la evaluación e implementación. Tanto si desarrolla en un portátil, como si lanza experimentos a gran escala en un clúster o implementa modelos en producción, Oumi le proporciona las herramientas y los flujos de trabajo que necesita.

-

-

-

-