What is OLMo 2 32B?

OLMo 2 32B는 최첨단 거대 언어 모델(LLM)로서, 오픈 소스 AI의 새로운 기준을 제시합니다. 폐쇄형 소스인 다른 강력한 LLM과는 달리, OLMo 2 32B는 데이터, 코드, 가중치에 대한 완전한 접근 권한을 제공합니다. 이러한 투명성은 전례 없는 자유로 고급 언어 모델을 구축, 맞춤화 및 연구할 수 있도록 지원합니다. 이는 연구자와 개발자가 고성능 LLM에 대한 접근이 제한적인 문제를 해결하기 위해 개발되었습니다.

주요 기능:

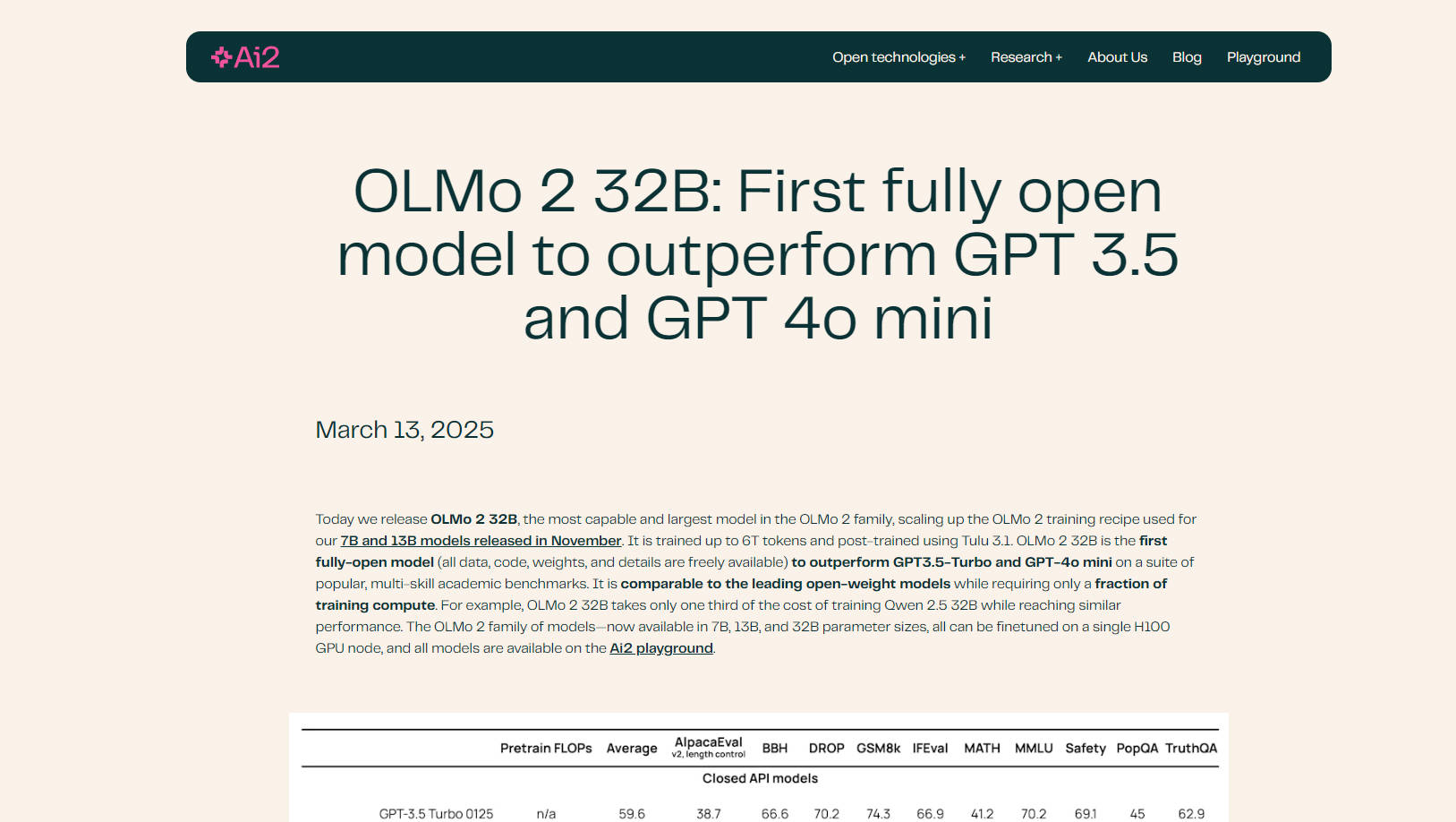

🤖 최고 모델 능가: OLMo 2 32B는 다양한 학술 벤치마크에서 GPT-3.5 Turbo 및 GPT-4o mini를 능가하여 뛰어난 언어 이해 및 생성 능력을 입증합니다.

💻 완전한 오픈 소스: 모델의 훈련 데이터, 코드, 가중치 및 방법론에 대한 완전한 접근 권한을 얻으세요. 이러한 투명성을 통해 전례 없는 사용자 정의 및 연구 기회를 얻을 수 있습니다.

⚙️ 효율적인 훈련: OLMo 2 32B는 유사한 모델보다 훨씬 적은 계산 비용으로 성능을 달성합니다. 예를 들어, Qwen 2.5 32B와 비슷한 결과를 얻으면서도 훈련 비용은 1/3에 불과합니다.

📚 개선된 데이터 및 사전 훈련: 개선된 훈련 코드베이스(OLMo-core)를 기반으로 구축된 OLMo 2 32B는 포괄적인 사전 훈련 및 중간 훈련을 위해 광범위한 데이터 세트(OLMo-Mix-1124 및 Dolmino)를 활용합니다.

🧠 RLVR을 사용한 고급 사후 훈련: Group Relative Policy Optimization(GRPO)을 사용하는 Reinforcement Learning with Verifiable Rewards(RLVR)를 통합하여 명령어 추종 및 추론 능력을 더욱 향상시킵니다.

⚡ 확장 가능하고 유연함: OLMo-core는 최신 하드웨어용으로 설계되었으며 4D+ 병렬 처리 및 세분화된 활성화 체크포인팅을 지원하여 다양한 훈련 시나리오에 적응할 수 있습니다.

☁️ Google Cloud Engine 최적화: Google Cloud의 Augusta AI Hypercomputer에서 훈련되어 실제 성능과 확장성을 입증합니다.

사용 사례:

학술 연구: 연구자들은 OLMo 2 32B를 사용하여 사전 훈련 역학, 데이터가 모델 행동에 미치는 영향, 다양한 훈련 단계 간의 상호 작용을 연구할 수 있습니다. 오픈 소스 특성으로 인해 심층적인 분석 및 실험이 용이합니다. 예를 들어, 연구자는 훈련 데이터를 수정하여 특정 유형의 콘텐츠가 모델 출력에 미치는 영향을 조사할 수 있습니다.

맞춤형 LLM 개발: 개발자는 OLMo 2 32B를 특정 데이터 세트에서 미세 조정하여 챗봇, 콘텐츠 생성 또는 코드 완성 도구와 같은 다양한 애플리케이션을 위한 맞춤형 언어 모델을 만들 수 있습니다. 이 모델은 Hugging Face의 Transformers 라이브러리 및 vLLM과의 호환성을 통해 기존 워크플로에 쉽게 통합할 수 있습니다.

고급 명령어 추종: RLVR을 포함한 개선된 사후 훈련을 통해 OLMo 2 32B는 복잡한 명령어를 이해하고 응답하는 데 특히 능숙합니다. 이는 미묘한 추론이나 창의적인 텍스트 생성이 필요한 작업에 유용합니다. 예를 들어, 복잡한 수학 문제나 윤리적 딜레마에 대한 모델의 능력을 테스트할 수 있습니다.

결론:

OLMo 2 32B는 오픈 소스 언어 모델의 중요한 발전을 나타냅니다. 뛰어난 성능, 완전한 투명성 및 효율적인 훈련을 통해 AI의 경계를 넓히고자 하는 연구원과 개발자를 위한 강력한 도구입니다. 모델의 모든 측면에 대한 완전한 접근 권한을 제공함으로써 OLMo 2 32B는 AI 커뮤니티 내에서 혁신과 협업을 촉진합니다.

FAQ:

무엇이 OLMo 2 32B를 "완전한 오픈"으로 만드는가? 완전한 오픈이란 훈련 데이터, 코드, 가중치 및 자세한 방법론을 포함한 모델의 모든 구성 요소를 공개적으로 사용할 수 있음을 의미합니다. 이러한 수준의 투명성은 거대 언어 모델 분야에서는 드뭅니다.

OLMo 2 32B의 성능은 다른 오픈 소스 모델과 비교하여 어떻습니까? OLMo 2 32B는 Qwen 2.5 32B 및 Mistral 24B와 같은 최고의 오픈 웨이트 모델과 일치하거나 능가하면서도 훈련에 필요한 계산 리소스는 훨씬 적습니다.

OLMo-core는 무엇입니까? OLMo-core는 OLMo 2 32B를 위해 새로 개발된 훈련 프레임워크입니다. 효율성, 확장성 및 유연성을 위해 설계되었으며 더 큰 모델, 다양한 훈련 패러다임 및 텍스트를 넘어서는 양식을 지원합니다.

RLVR은 무엇이며 모델에 어떤 이점을 제공합니까? RLVR은 Reinforcement Learning with Verifiable Rewards의 약자입니다. 이는 모델의 명령어 추종 및 효과적인 추론 능력을 향상시키기 위해 사후 훈련 중에 사용되는 기술입니다. 향상된 훈련을 위해 Group Relative Policy Optimization(GRPO)을 사용합니다.

내 데이터에 대해 OLMo 2 32B를 미세 조정할 수 있습니까? 예, OLMo 2 32B의 주요 장점 중 하나는 오픈 소스 특성이므로 특정 데이터 세트에서 미세 조정하여 요구 사항에 맞게 성능을 조정할 수 있습니다. HuggingFace의 Transformers 라이브러리에서 지원됩니다.

OLMo 2 32b를 실행하는 데 필요한 하드웨어는 무엇입니까? OLMo 2 제품군(7B, 13B 및 32B 파라미터 크기)의 모든 모델은 단일 H100 GPU 노드에서 미세 조정할 수 있습니다.