What is OLMo 2 32B?

OLMo 2 32Bは、オープンソースAIに新たな基準を打ち立てる、最先端の大規模言語モデル(LLM)です。多くの高性能LLMがクローズドソースであるのに対し、OLMo 2 32Bはそのデータ、コード、重みへの完全なアクセスを提供します。この透明性により、前例のない自由度で、高度な言語モデルの構築、カスタマイズ、研究が可能になります。研究者や開発者にとって、高性能LLMへのアクセスが限られているという問題を解決するために開発されました。

主な特徴:

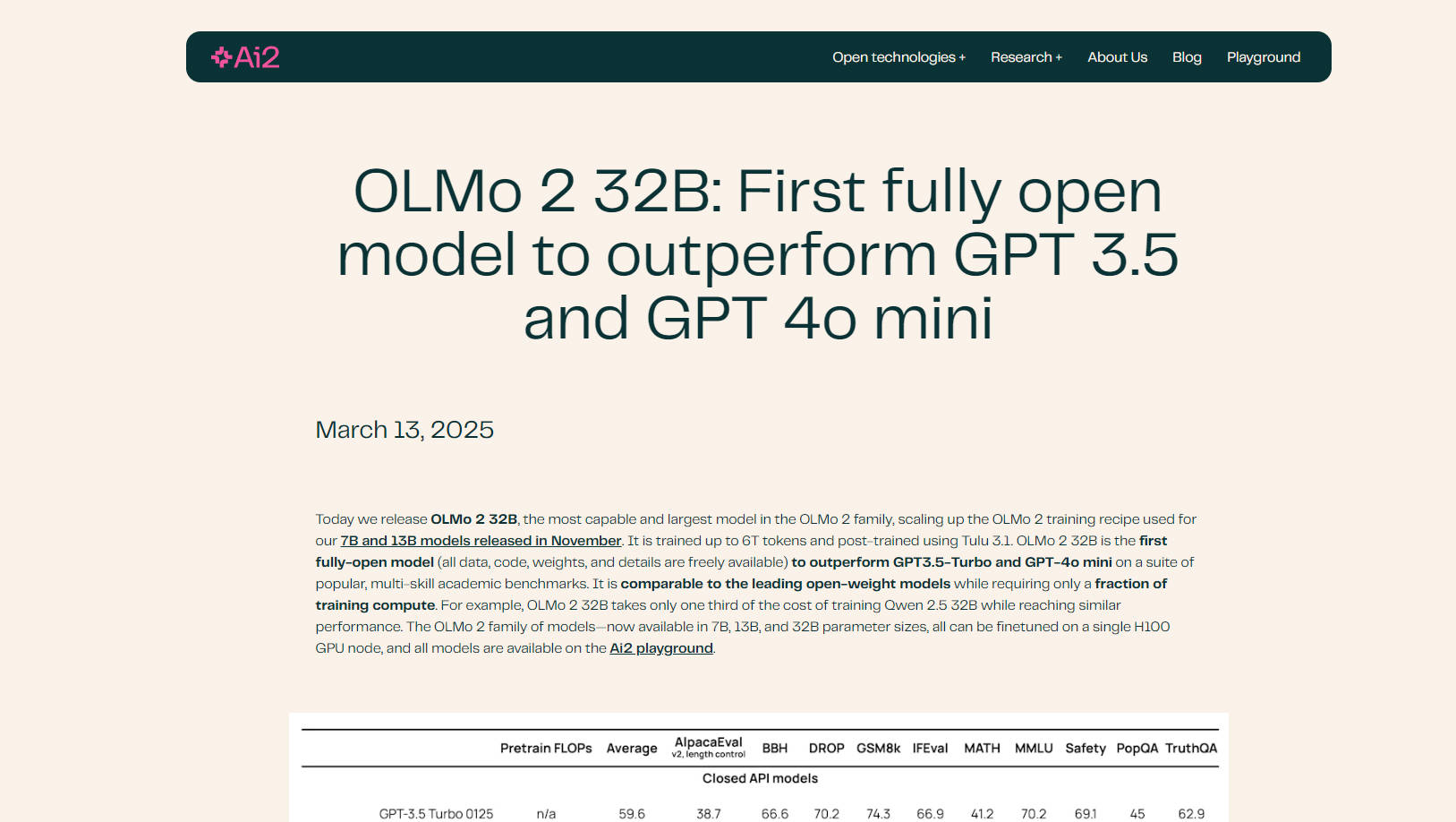

🤖 主要モデルを凌駕: OLMo 2 32Bは、さまざまな学術ベンチマークにおいてGPT-3.5 TurboやGPT-4o miniを上回り、優れた言語理解と生成能力を実証しています。

💻 完全なオープンソース: モデルのトレーニングデータ、コード、重み、および方法論への完全なアクセスが可能です。この透明性により、前例のないカスタマイズと研究の機会が得られます。

⚙️ 効率的なトレーニング: OLMo 2 32Bは、同等のモデルよりも大幅に少ない計算コストで、優れたパフォーマンスを実現します。たとえば、Qwen 2.5 32Bと同等の結果を達成しながら、トレーニングコストはわずか3分の1です。

📚 改善されたデータと事前学習: 洗練されたトレーニングコードベース(OLMo-core)上に構築されたOLMo 2 32Bは、包括的な事前学習と中間学習のために、広範なデータセット(OLMo-Mix-1124およびDolmino)を活用しています。

🧠 RLVRによる高度なポストトレーニング: Group Relative Policy Optimization(GRPO)を用いたReinforcement Learning with Verifiable Rewards(RLVR)を組み込むことで、指示遵守能力と推論能力をさらに強化しています。

⚡ スケーラブルかつ柔軟: 最新のハードウェア向けに設計されたOLMo-coreは、4D+並列処理と細粒度のアクティベーションチェックポイントをサポートし、さまざまなトレーニングシナリオに適応可能です。

☁️ Google Cloud Engineに最適化: Google CloudのAugusta AI Hypercomputerでトレーニングされており、実際のパフォーマンスとスケーラビリティを実証しています。

ユースケース:

学術研究: 研究者はOLMo 2 32Bを使用して、事前学習のダイナミクス、データがモデルの挙動に与える影響、およびさまざまなトレーニング段階間の相互作用を研究できます。オープンソースであるため、詳細な分析と実験が容易になります。たとえば、研究者はトレーニングデータを変更して、特定の種類のコンテンツがモデルの出力にどのように影響するかを調査できます。

カスタムLLMの開発: 開発者は、特定のデータセットでOLMo 2 32Bを微調整し、チャットボット、コンテンツ生成、またはコード補完ツールなど、さまざまなアプリケーション向けのカスタム言語モデルを作成できます。このモデルはHugging FaceのTransformersライブラリおよびvLLMとの互換性があり、既存のワークフローへの統合を簡素化します。

高度な指示追従: RLVRを含む洗練されたポストトレーニングにより、OLMo 2 32Bは、複雑な指示の理解と応答に特に優れています。これは、ニュアンスのある推論や創造的なテキスト生成を必要とするタスクに役立ちます。たとえば、複雑な数学の問題や倫理的なジレンマについて、モデルの能力をテストできます。

結論:

OLMo 2 32Bは、オープンソース言語モデルにおける重要な進歩を代表しています。その優れたパフォーマンス、完全な透明性、および効率的なトレーニングは、AIの限界を押し広げようとする研究者や開発者にとって、強力なツールとなります。モデルのすべての側面への完全なアクセスを提供することにより、OLMo 2 32BはAIコミュニティ内のイノベーションとコラボレーションを促進します。

FAQ:

OLMo 2 32Bが「完全にオープン」である理由は何ですか? 完全にオープンとは、トレーニングデータ、コード、重み、詳細な方法論など、モデルのすべてのコンポーネントが一般に公開されていることを意味します。このレベルの透明性は、大規模言語モデルの分野では一般的ではありません。

OLMo 2 32Bのパフォーマンスは、他のオープンソースモデルと比較してどうですか? OLMo 2 32Bは、Qwen 2.5 32BやMistral 24Bなどの主要なオープンウェイトモデルと同等またはそれ以上のパフォーマンスを発揮し、トレーニングに必要な計算リソースは大幅に少なくなっています。

OLMo-coreとは何ですか? OLMo-coreは、OLMo 2 32B向けに新しく開発されたトレーニングフレームワークです。効率性、スケーラビリティ、および柔軟性を実現するように設計されており、より大きなモデル、さまざまなトレーニングパラダイム、およびテキスト以外のモダリティをサポートしています。

RLVRとは何ですか?また、モデルにどのようなメリットがありますか? RLVRは、Reinforcement Learning with Verifiable Rewardsの略です。これは、モデルの指示に従い、効果的に推論する能力を向上させるために、ポストトレーニング中に使用される手法です。強化されたトレーニングのためにGroup Relative Policy Optimization(GRPO)を使用します。

OLMo 2 32Bを独自のデータで微調整できますか? はい、OLMo 2 32Bの重要な利点の1つは、そのオープンソースの性質であり、特定のデータセットで微調整して、ニーズに合わせてパフォーマンスを調整できます。HuggingFaceのTransformersライブラリでサポートされています。

OLMo 2 32Bを実行するには、どのようなハードウェアが必要ですか? OLMo 2ファミリー(7B、13B、および32Bのパラメータサイズ)のすべてのモデルは、単一のH100 GPUノードで微調整できます。