What is OLMo 2 32B?

OLMo 2 32B 是一款最先進的大型語言模型 (LLM),為開源 AI 樹立了新標準。與許多封閉原始碼的強大 LLM 不同,OLMo 2 32B 提供對其資料、程式碼和權重的完整存取權。這種透明性能夠讓您以前所未有的自由度來建構、自訂和研究先進的語言模型。它的開發是為了要解決研究人員和開發人員在取得高效能 LLM 時遇到的限制。

主要特色:

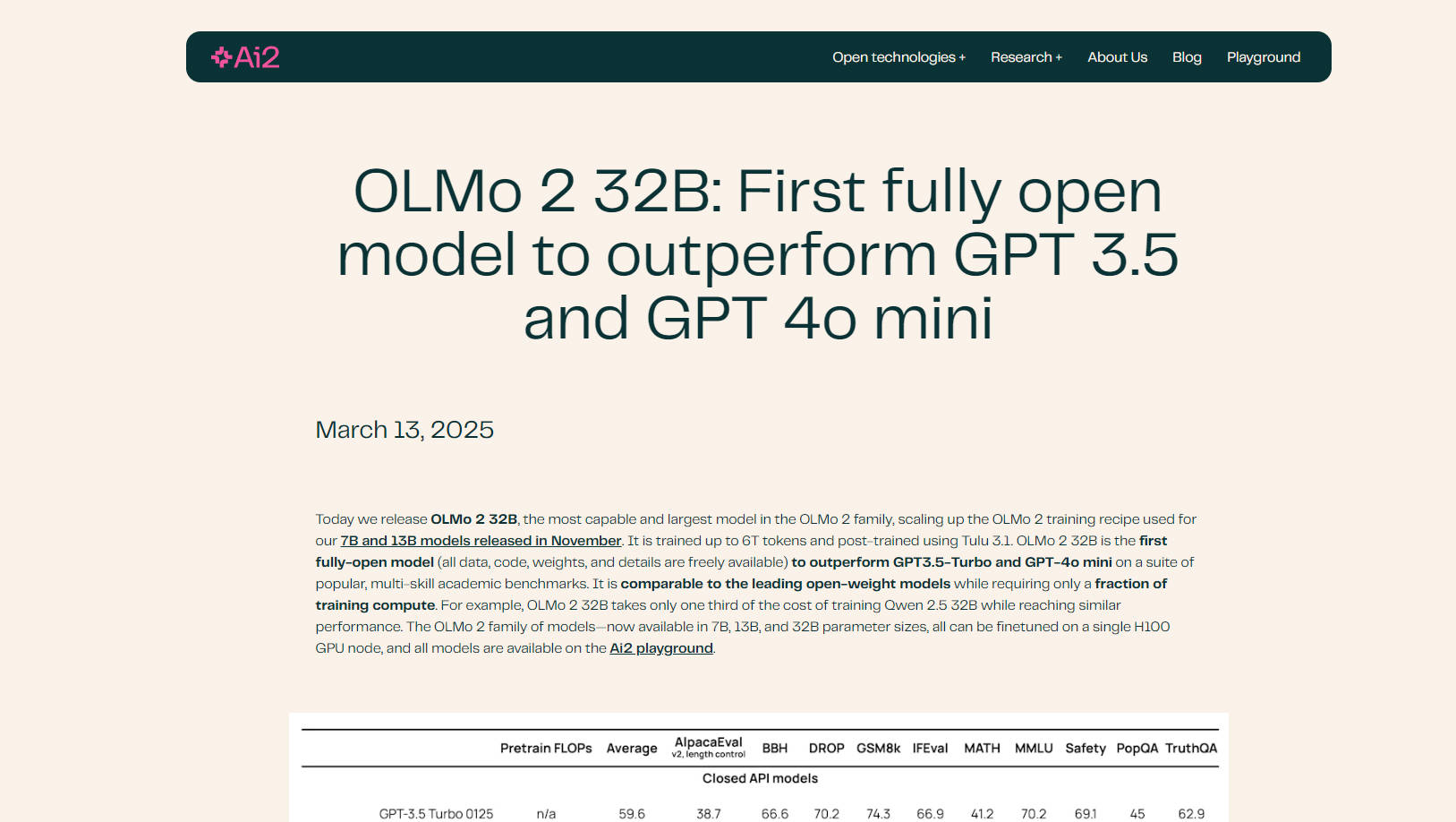

🤖 效能超越領先模型: OLMo 2 32B 在各種學術基準測試中超越了 GPT-3.5 Turbo 和 GPT-4o mini,展現了其卓越的語言理解和生成能力。

💻 完全開源: 完整存取模型的訓練資料、程式碼、權重和方法。這種透明性提供了前所未有的自訂和研究機會。

⚙️ 高效訓練: OLMo 2 32B 以明顯低於同類模型的計算成本實現了其效能。例如,它只需要 Qwen 2.5 32B 三分之一的訓練成本,同時達到相似的結果。

📚 改良的資料和預訓練: OLMo 2 32B 建立在精煉的訓練程式碼庫 (OLMo-core) 之上,並利用廣泛的資料集 (OLMo-Mix-1124 和 Dolmino) 進行全面的預訓練和中訓練。

🧠 使用 RLVR 進行進階後訓練: 結合使用可驗證獎勵的強化學習 (RLVR),使用群組相對策略優化 (GRPO),進一步增強其指令遵循和推理能力。

⚡ 可擴展且靈活: OLMo-core 專為現代硬體設計,支援 4D+ 並行處理和細粒度的啟動檢查點,使其能夠適應各種訓練情境。

☁️ Google Cloud Engine 最佳化: 在 Google Cloud 的 Augusta AI Hypercomputer 上進行訓練,展現了真實世界的效能和可擴展性。

使用案例:

學術研究: 研究人員可以使用 OLMo 2 32B 來研究預訓練動態、資料對模型行為的影響,以及不同訓練階段之間的相互作用。開源性質有助於深入分析和實驗。例如,研究人員可以修改訓練資料,以研究特定類型的內容如何影響模型的輸出。

自訂 LLM 開發: 開發人員可以在其特定資料集上微調 OLMo 2 32B,以建立用於各種應用程式的自訂語言模型,例如聊天機器人、內容生成或程式碼完成工具。該模型與 Hugging Face 的 Transformers 函式庫和 vLLM 的相容性簡化了整合到現有工作流程中的過程。

進階指令遵循: 經過改良的後訓練 (包括 RLVR) 使 OLMo 2 32B 特別擅長理解和回應複雜的指令。這對於需要細緻推理或創造性文字生成的任務非常有利。例如,您可以測試模型在複雜的數學問題或道德困境中的能力。

結論:

OLMo 2 32B 代表了開源語言模型的重大進步。其卓越的效能、完全的透明性和高效的訓練使其成為研究人員和開發人員尋求突破 AI 界限的強大工具。透過提供對模型各個方面的完整存取權,OLMo 2 32B 促進了 AI 社群內的創新和協作。

常見問題:

是什麼讓 OLMo 2 32B 成為「完全開放」? 完全開放意味著模型的所有組件,包括訓練資料、程式碼、權重和詳細方法,都是公開可用的。這種透明度在大型語言模型領域中並不常見。

OLMo 2 32B 的效能與其他開源模型相比如何? OLMo 2 32B 在效能上與 Qwen 2.5 32B 和 Mistral 24B 等領先的開放權重模型相符或超越,同時訓練所需的計算資源明顯更少。

什麼是 OLMo-core? OLMo-core 是為 OLMo 2 32B 新開發的訓練架構。它專為效率、可擴展性和靈活性而設計,支援更大的模型、不同的訓練範例以及超越文字的模式。

什麼是 RLVR,它如何使模型受益? RLVR 代表使用可驗證獎勵的強化學習。這是一種在後訓練期間使用的技術,旨在提高模型遵循指令和有效推理的能力。它使用群組相對策略優化 (GRPO) 來增強訓練。

我可以在我自己的資料上微調 OLMo 2 32B 嗎? 可以,OLMo 2 32B 的主要優勢之一是其開源性質,這讓您可以在您特定的資料集上對其進行微調,以根據您的需求調整其效能。HuggingFace 的 Transformers 函式庫支援它。

執行 OLMo 2 32b 需要什麼硬體? OLMo 2 系列中的所有模型(7B、13B 和 32B 參數大小)都可以在單個 H100 GPU 節點上進行微調。