What is OLMo 2 32B?

OLMo 2 32B 是一款先进的大型语言模型 (LLM),为开源 AI 树立了新的标杆。与许多闭源的强大 LLM 不同,OLMo 2 32B 提供了对其数据、代码和权重的完全访问权限。这种透明性使您能够以前所未有的自由度构建、定制和研究高级语言模型。它的开发旨在解决研究人员和开发人员难以获得高性能 LLM 的问题。

主要特性:

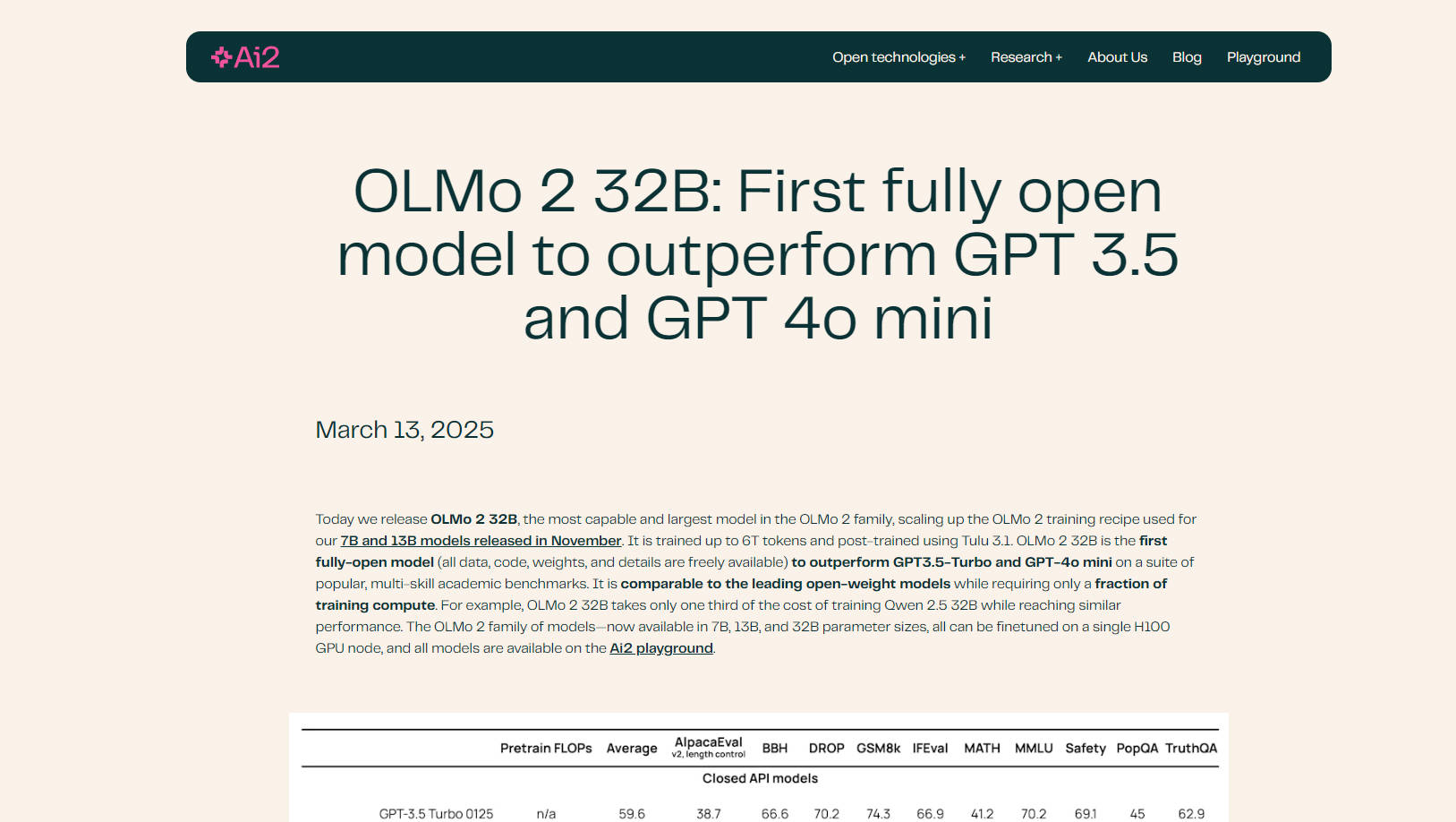

🤖 性能超越领先模型:OLMo 2 32B 在各种学术基准测试中超越了 GPT-3.5 Turbo 和 GPT-4o mini,展示了其卓越的语言理解和生成能力。

💻 完全开源:完全访问模型的训练数据、代码、权重和方法论。这种透明性为前所未有的定制和研究机会提供了可能。

⚙️ 高效训练:OLMo 2 32B 以远低于同类模型的计算成本实现了其性能。例如,它仅需 Qwen 2.5 32B 三分之一的训练成本即可达到类似的结果。

📚 改进的数据和预训练:OLMo 2 32B 建立在改进的训练代码库 (OLMo-core) 之上,利用广泛的数据集 (OLMo-Mix-1124 和 Dolmino) 进行全面的预训练和中期训练。

🧠 使用 RLVR 进行高级后训练:结合使用可验证奖励的强化学习 (RLVR),使用组相对策略优化 (GRPO),进一步增强了其指令遵循和推理能力。

⚡ 可扩展且灵活:OLMo-core 专为现代硬件设计,支持 4D+ 并行性和细粒度的激活检查点,使其能够适应各种训练场景。

☁️ Google Cloud Engine 优化:在 Google Cloud 的 Augusta AI Hypercomputer 上进行训练,展示了真实的性能和可扩展性。

应用场景:

学术研究:研究人员可以使用 OLMo 2 32B 来研究预训练动态、数据对模型行为的影响以及不同训练阶段之间的相互作用。开源性质有助于深入分析和实验。例如,研究人员可以修改训练数据,以研究特定类型的内容如何影响模型的输出。

定制 LLM 开发:开发人员可以在其特定数据集上微调 OLMo 2 32B,以创建用于各种应用程序的定制语言模型,例如聊天机器人、内容生成或代码完成工具。该模型与 Hugging Face 的 Transformers 库和 vLLM 的兼容性简化了与现有工作流程的集成。

高级指令遵循:改进的后训练,包括 RLVR,使 OLMo 2 32B 特别擅长理解和响应复杂指令。这对于需要细致推理或创造性文本生成的任务非常有利。例如,您可以测试模型在复杂的数学问题或伦理困境中的能力。

结论:

OLMo 2 32B 代表了开源语言模型的重大进步。其卓越的性能、完全的透明度和高效的训练使其成为研究人员和开发人员寻求突破 AI 界限的强大工具。通过提供对模型各个方面的完全访问权限,OLMo 2 32B 促进了 AI 社区内的创新与协作。

常见问题解答:

是什么让 OLMo 2 32B “完全开放”?完全开放意味着模型的所有组件,包括训练数据、代码、权重和详细的方法论,都是公开可用的。这种透明度在大型语言模型领域并不常见。

OLMo 2 32B 的性能与其他开源模型相比如何?OLMo 2 32B 的性能与 Qwen 2.5 32B 和 Mistral 24B 等领先的开放权重模型相当或优于这些模型,同时训练所需的计算资源要少得多。

什么是 OLMo-core?OLMo-core 是 OLMo 2 32B 的新开发的训练框架。它专为效率、可扩展性和灵活性而设计,支持更大的模型、不同的训练范例以及文本之外的其他模式。

什么是 RLVR,它如何使模型受益?RLVR 代表使用可验证奖励的强化学习。这是一种在后训练期间使用的技术,旨在提高模型遵循指令和有效推理的能力。它使用组相对策略优化 (GRPO) 来增强训练。

我可以在自己的数据上微调 OLMo 2 32B 吗?是的,OLMo 2 32B 的主要优势之一是其开源性质,允许您在特定数据集上对其进行微调,以根据您的需求定制其性能。HuggingFace 的 Transformers 库支持它。

运行 OLMo 2 32B 需要什么硬件?OLMo 2 系列中的所有模型(7B、13B 和 32B 参数大小)都可以在单个 H100 GPU 节点上进行微调。