What is OLMo 2 32B?

OLMo 2 32B — это передовая большая языковая модель (LLM), задающая новую планку для искусственного интеллекта с открытым исходным кодом. В отличие от многих мощных LLM с закрытым исходным кодом, OLMo 2 32B предоставляет полный доступ к своим данным, коду и весам. Эта прозрачность позволяет вам создавать, настраивать и исследовать передовые языковые модели с беспрецедентной свободой. Она разработана для решения проблемы ограниченного доступа к высокопроизводительным LLM для исследователей и разработчиков.

Ключевые особенности:

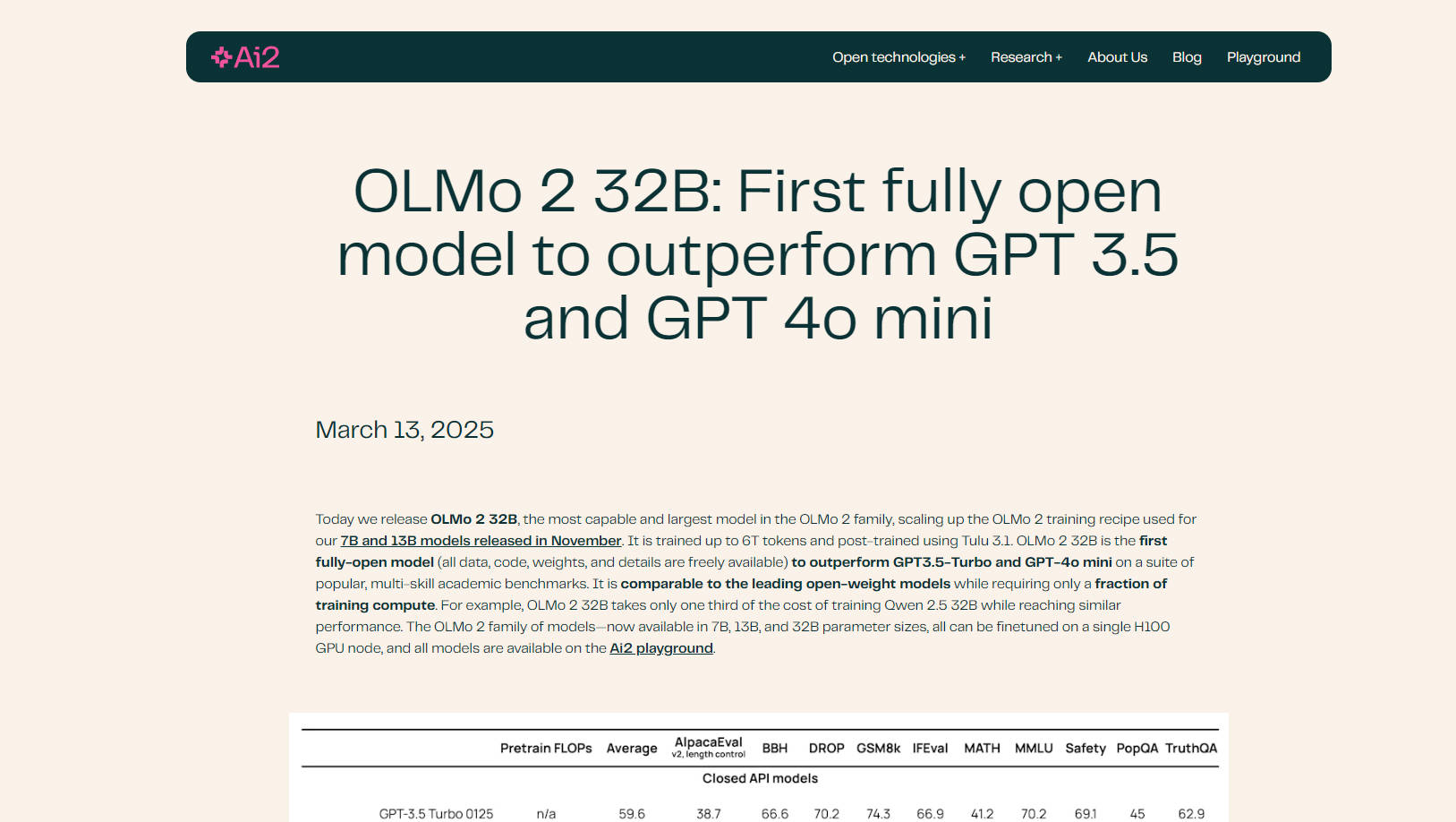

🤖 Превосходит ведущие модели: OLMo 2 32B превосходит GPT-3.5 Turbo и GPT-4o mini по ряду академических бенчмарков, демонстрируя свои превосходные возможности понимания и генерации языка.

💻 Полностью открытый исходный код: Получите полный доступ к обучающим данным модели, коду, весам и методологии. Такая прозрачность открывает беспрецедентные возможности для настройки и исследований.

⚙️ Эффективное обучение: OLMo 2 32B достигает своей производительности со значительно меньшими вычислительными затратами, чем сопоставимые модели. Например, для обучения требуется лишь одна треть вычислительных ресурсов по сравнению с Qwen 2.5 32B при достижении аналогичных результатов.

📚 Улучшенные данные и предварительное обучение: OLMo 2 32B, построенная на усовершенствованной кодовой базе для обучения (OLMo-core), использует обширные наборы данных (OLMo-Mix-1124 и Dolmino) для комплексного предварительного и промежуточного обучения.

🧠 Продвинутое постобработка с RLVR: Включает обучение с подкреплением с проверяемыми наградами (Reinforcement Learning with Verifiable Rewards, RLVR) с использованием Group Relative Policy Optimization (GRPO), что еще больше улучшает ее способность следовать инструкциям и рассуждать.

⚡ Масштабируемая и гибкая: OLMo-core, разработанная для современного оборудования, поддерживает 4D+ параллелизм и точную контрольную точку активации, что делает ее адаптируемой к различным сценариям обучения.

☁️ Оптимизировано для Google Cloud Engine: Обучено на Augusta AI Hypercomputer от Google Cloud, демонстрируя реальную производительность и масштабируемость.

Сценарии использования:

Академические исследования: Исследователи могут использовать OLMo 2 32B для изучения динамики предварительного обучения, влияния данных на поведение модели и взаимодействия между различными этапами обучения. Открытый исходный код способствует углубленному анализу и экспериментам. Например, исследователь может изменить обучающие данные, чтобы изучить, как конкретные типы контента влияют на выходные данные модели.

Разработка пользовательских LLM: Разработчики могут дорабатывать OLMo 2 32B на своих конкретных наборах данных для создания специализированных языковых моделей для различных приложений, таких как чат-боты, генерация контента или инструменты для завершения кода. Совместимость модели с библиотекой Transformers от Hugging Face и vLLM упрощает интеграцию в существующие рабочие процессы.

Расширенное следование инструкциям: Усовершенствованная постобработка, включая RLVR, делает OLMo 2 32B особенно способной понимать и отвечать на сложные инструкции. Это полезно для задач, требующих тонкого рассуждения или творческой генерации текста. Например, вы можете проверить возможности модели на сложных математических задачах или этических дилеммах.

Заключение:

OLMo 2 32B представляет собой значительный шаг вперед в развитии языковых моделей с открытым исходным кодом. Ее превосходная производительность, полная прозрачность и эффективное обучение делают ее мощным инструментом для исследователей и разработчиков, стремящихся расширить границы искусственного интеллекта. Предоставляя полный доступ ко всем аспектам модели, OLMo 2 32B способствует инновациям и сотрудничеству в рамках ИИ-сообщества.

FAQ:

Что делает OLMo 2 32B "полностью открытой"? Полностью открытая означает, что все компоненты модели, включая обучающие данные, код, веса и подробную методологию, находятся в открытом доступе. Такой уровень прозрачности не является распространенным в области больших языковых моделей.

Как производительность OLMo 2 32B соотносится с другими моделями с открытым исходным кодом? OLMo 2 32B соответствует или превосходит ведущие модели с открытыми весами, такие как Qwen 2.5 32B и Mistral 24B, при этом требуя значительно меньше вычислительных ресурсов для обучения.

Что такое OLMo-core? OLMo-core — это новая платформа для обучения OLMo 2 32B. Она разработана для эффективности, масштабируемости и гибкости, поддерживая более крупные модели, различные парадигмы обучения и модальности, выходящие за рамки текста.

Что такое RLVR и как это помогает модели? RLVR расшифровывается как Reinforcement Learning with Verifiable Rewards (Обучение с подкреплением с проверяемыми наградами). Это метод, используемый во время постобработки для улучшения способности модели следовать инструкциям и эффективно рассуждать. В нем используется Group Relative Policy Optimization (GRPO) для расширенного обучения.

Могу ли я доработать OLMo 2 32B на своих собственных данных? Да, одним из ключевых преимуществ OLMo 2 32B является ее открытый исходный код, который позволяет вам дорабатывать ее на ваших конкретных наборах данных, чтобы адаптировать ее производительность к вашим потребностям. Она поддерживается в библиотеке Transformers от HuggingFace.

Какое оборудование необходимо для запуска OLMo 2 32b? Все модели семейства OLMo 2 (размеры параметров 7B, 13B и 32B) можно дорабатывать на одном узле GPU H100.

More information on OLMo 2 32B

Top 5 Countries

Traffic Sources

OLMo 2 32B Альтернативи

Больше Альтернативи-

Oumi — это полностью открытая платформа, которая оптимизирует весь жизненный цикл фундаментальных моделей — от подготовки данных и обучения до оценки и развертывания. Независимо от того, разрабатываете ли вы модели на ноутбуке, запускаете крупномасштабные эксперименты на кластере или внедряете модели в промышленную эксплуатацию, Oumi предоставляет необходимые инструменты и рабочие процессы.

-

-

-

-