What is OLMo 2 32B?

OLMo 2 32B est un modèle de langage étendu (LLM) de pointe qui redéfinit les standards de l'IA open source. Contrairement à de nombreux LLM puissants qui sont en closed source, OLMo 2 32B offre un accès complet à ses données, son code et ses poids. Cette transparence vous permet de construire, de personnaliser et de rechercher des modèles de langage avancés avec une liberté sans précédent. Il a été développé pour résoudre le problème de l'accès limité aux LLM très performants pour les chercheurs et les développeurs.

Principales caractéristiques :

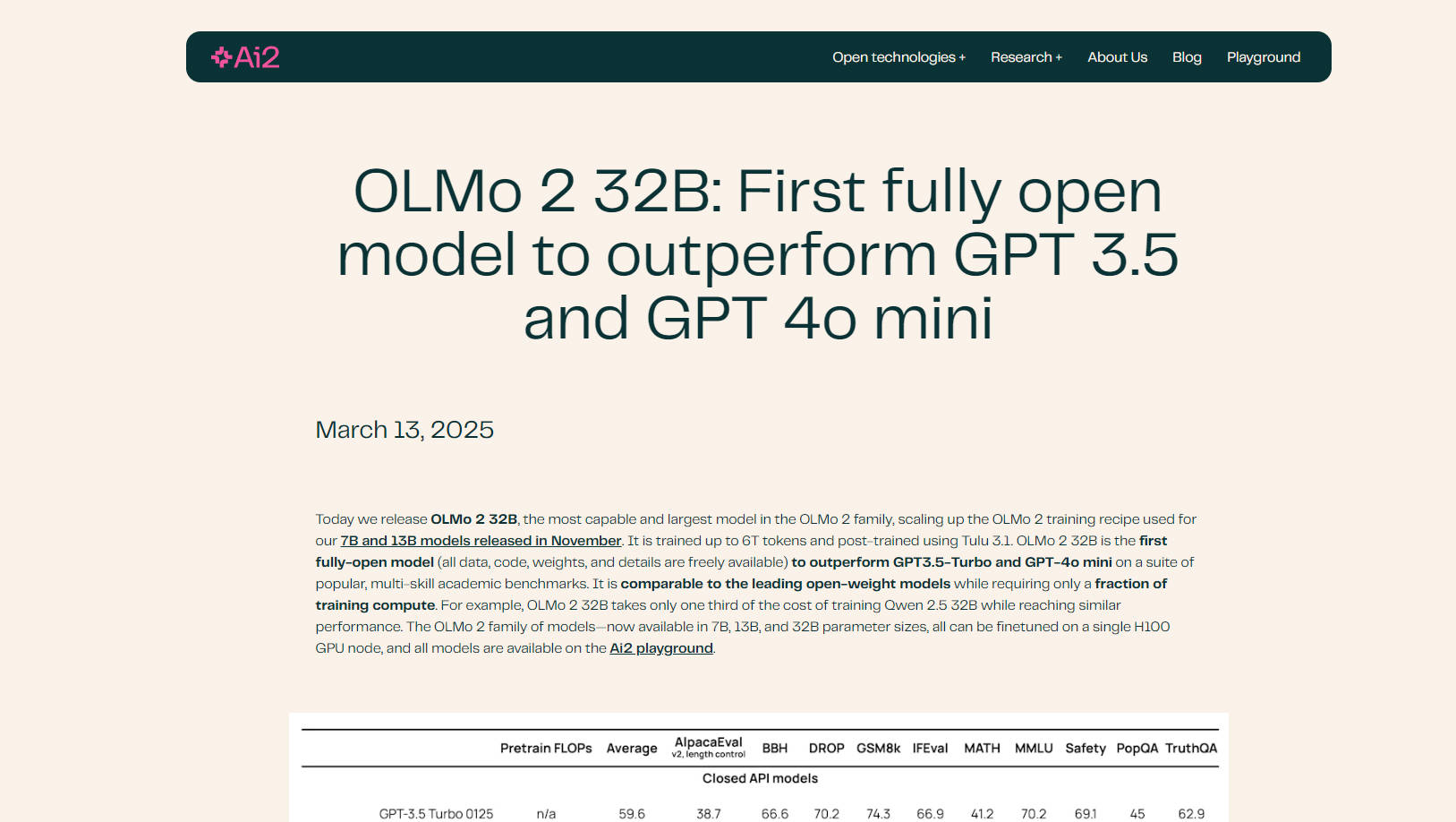

🤖 Surpasse les modèles leaders : OLMo 2 32B surpasse GPT-3.5 Turbo et GPT-4o mini sur une variété de benchmarks académiques, démontrant sa compréhension et ses capacités de génération de langage supérieures.

💻 Entièrement Open Source : Bénéficiez d'un accès complet aux données d'entraînement, au code, aux poids et à la méthodologie du modèle. Cette transparence offre des possibilités de personnalisation et de recherche sans précédent.

⚙️ Entraînement efficace : OLMo 2 32B atteint ses performances avec un coût de calcul nettement inférieur à celui des modèles comparables. Par exemple, il ne nécessite qu'un tiers du coût d'entraînement de Qwen 2.5 32B tout en obtenant des résultats similaires.

📚 Données et pré-entraînement améliorés : Construit sur une base de code d'entraînement affinée (OLMo-core), OLMo 2 32B exploite des ensembles de données étendus (OLMo-Mix-1124 et Dolmino) pour un pré-entraînement et un entraînement intermédiaire complets.

🧠 Post-entraînement avancé avec RLVR : Intègre l'apprentissage par renforcement avec des récompenses vérifiables (Reinforcement Learning with Verifiable Rewards - RLVR) en utilisant l'optimisation de la politique relative de groupe (Group Relative Policy Optimization - GRPO), ce qui améliore encore ses capacités de suivi des instructions et de raisonnement.

⚡ Évolutif et flexible : Conçu pour le matériel moderne, OLMo-core prend en charge le parallélisme 4D+ et la mise en cache des activations à granularité fine, ce qui le rend adaptable à divers scénarios d'entraînement.

☁️ Optimisé pour Google Cloud Engine : Entraîné sur l'Augusta AI Hypercomputer de Google Cloud, démontrant des performances et une évolutivité réelles.

Cas d'utilisation :

Recherche académique : Les chercheurs peuvent utiliser OLMo 2 32B pour étudier la dynamique du pré-entraînement, l'impact des données sur le comportement du modèle et l'interaction entre les différentes étapes de l'entraînement. La nature open source facilite l'analyse approfondie et l'expérimentation. Par exemple, un chercheur pourrait modifier les données d'entraînement pour étudier comment des types de contenu spécifiques influencent la sortie du modèle.

Développement de LLM personnalisé : Les développeurs peuvent affiner OLMo 2 32B sur leurs ensembles de données spécifiques pour créer des modèles de langage personnalisés pour diverses applications, telles que les chatbots, la génération de contenu ou les outils de complétion de code. La compatibilité du modèle avec la bibliothèque Transformers de Hugging Face et vLLM simplifie l'intégration dans les flux de travail existants.

Suivi avancé des instructions : Le post-entraînement affiné, y compris RLVR, rend OLMo 2 32B particulièrement apte à comprendre et à répondre à des instructions complexes. Ceci est avantageux pour les tâches nécessitant un raisonnement nuancé ou une génération de texte créative. Par exemple, vous pouvez tester les capacités du modèle sur des problèmes mathématiques complexes ou des dilemmes éthiques.

Conclusion :

OLMo 2 32B représente une avancée significative dans les modèles de langage open source. Ses performances supérieures, sa transparence totale et son entraînement efficace en font un outil puissant pour les chercheurs et les développeurs qui cherchent à repousser les limites de l'IA. En offrant un accès complet à tous les aspects du modèle, OLMo 2 32B favorise l'innovation et la collaboration au sein de la communauté de l'IA.

FAQ :

Qu'est-ce qui rend OLMo 2 32B "entièrement ouvert" ? Entièrement ouvert signifie que tous les composants du modèle, y compris les données d'entraînement, le code, les poids et la méthodologie détaillée, sont accessibles au public. Ce niveau de transparence est rare dans le domaine des modèles de langage étendus.

Comment les performances de OLMo 2 32B se comparent-elles à celles des autres modèles open source ? OLMo 2 32B égale ou surpasse les principaux modèles open-weight tels que Qwen 2.5 32B et Mistral 24B, tout en nécessitant beaucoup moins de ressources de calcul pour l'entraînement.

Qu'est-ce que OLMo-core ? OLMo-core est le framework d'entraînement nouvellement développé pour OLMo 2 32B. Il est conçu pour l'efficacité, l'évolutivité et la flexibilité, prenant en charge des modèles plus grands, différents paradigmes d'entraînement et des modalités au-delà du texte.

Qu'est-ce que RLVR et comment profite-t-il au modèle ? RLVR signifie Reinforcement Learning with Verifiable Rewards (apprentissage par renforcement avec des récompenses vérifiables). Il s'agit d'une technique utilisée pendant le post-entraînement pour améliorer la capacité du modèle à suivre les instructions et à raisonner efficacement. Il utilise l'optimisation de la politique relative de groupe (GRPO) pour un entraînement amélioré.

Puis-je affiner OLMo 2 32B sur mes propres données ? Oui, l'un des principaux avantages de OLMo 2 32B est sa nature open source, qui vous permet de l'affiner sur vos ensembles de données spécifiques afin d'adapter ses performances à vos besoins. Il est pris en charge dans la bibliothèque Transformers de HuggingFace.

Quel matériel est nécessaire pour exécuter OLMo 2 32b ? Tous les modèles de la famille OLMo 2 (tailles de paramètres 7B, 13B et 32B) peuvent être affinés sur un seul nœud GPU H100.

More information on OLMo 2 32B

Top 5 Countries

Traffic Sources

OLMo 2 32B Alternatives

Plus Alternatives-

Oumi est une plateforme entièrement open-source qui rationalise l'intégralité du cycle de vie des modèles fondamentaux – de la préparation des données et de l'entraînement à l'évaluation et au déploiement. Que vous développiez sur un ordinateur portable, lanciez des expériences à grande échelle sur un cluster, ou déployiez des modèles en production, Oumi fournit les outils et les flux de travail nécessaires.

-

-

-

-