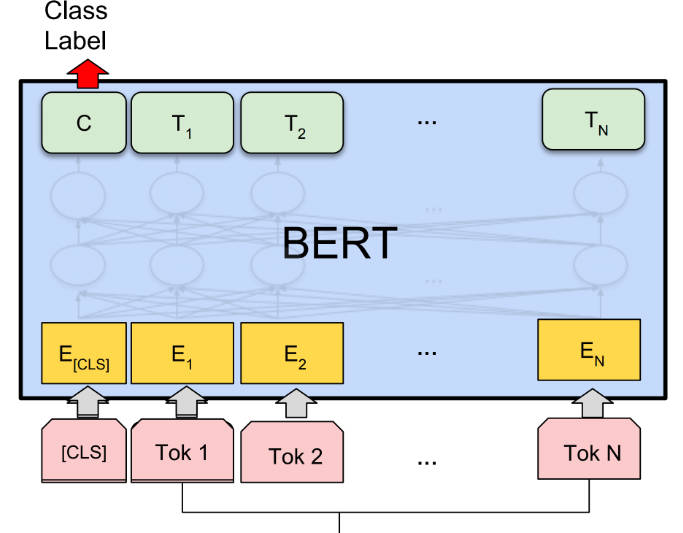

What is BERT?

BERT(双向编码器表示来自 Transformer)是一种预训练语言表示方法,在各种自然语言处理 (NLP) 任务中取得了最先进的结果。它是非监督的,并且是深度双向的,可以更好地理解上下文。BERT 可以针对特定的 NLP 任务进行微调,从而使其具有通用性和有效性。

主要特性:

? 预训练语言表示:BERT 在一个大型文本语料库上预训练一个通用的「语言理解」模型,使其能够捕获单词之间的上下文关系。

? 双向和深度上下文:与之前的模型不同,BERT 在表示一个单词时会考虑左右上下文,从而产生更准确和细微的表示。

? 针对特定任务进行微调:BERT 可以针对特定的 NLP 任务进行微调,例如问答、情感分析和命名实体识别,只需很少的任务特定修改。

用例:

? 问答:BERT 可以根据给定的上下文准确地回答问题,使其成为聊天机器人和虚拟助手等应用程序的宝贵工具。

? 情感分析:BERT 可以分析给定文本的情感,帮助企业了解客户反馈和情感趋势。

? 命名实体识别:BERT 可以识别和分类文本中的命名实体,有助于信息提取和数据挖掘等任务。

结论:

BERT 是一款用于 NLP 任务的强大 AI 工具,提供预训练的语言表示,并能够针对特定应用进行微调。凭借其双向和上下文理解,BERT 在各种任务上取得了最先进的结果。它的通用性和准确性使其成为研究人员、开发人员和寻求利用 NLP 技术的企业宝贵的资产。

More information on BERT

Launched

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used

Related Searches