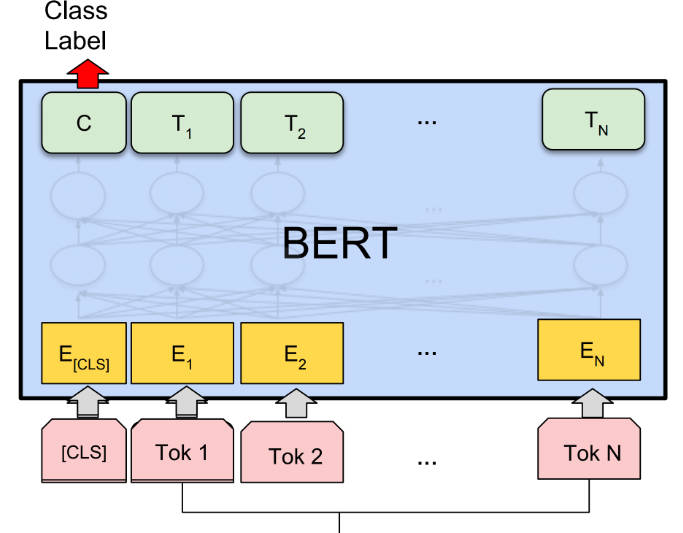

What is BERT?

BERT(雙向 Transformer 編碼器表徵)是一種預訓練語言表徵方法,在各種自然語言處理(NLP)任務上都能達到最先進的結果。它是非監督的,並且具有深度雙向性,能更佳地理解上下文。BERT 可以針對特定的 NLP 任務進行微調,使其用途廣泛且有效。

主要特點:

? 預訓練語言表徵:BERT 在大量文本語料庫上預先訓練一個通用的「語言理解」模型,使它能夠捕捉字詞之間的上下文關係。

? 雙向且深度語境:與先前的模型不同,BERT 在表徵一個字詞時會考慮左右兩側的上下文,能產生更準確和細微的表徵。

? 針對特定任務微調:BERT 可以針對特定的 NLP 任務進行微調,例如問答、情緒分析和命名實體識別,只需進行最少的任務特定修改。

使用案例:

? 問答:BERT 能根據給定的上下文準確回答問題,使其對於聊天機器人和虛擬助理等應用程式非常有價值。

? 情緒分析:BERT 能分析給定文本的情緒,幫助企業了解客戶回饋和情緒趨勢。

? 命名實體識別:BERT 能識別和分類文本中的命名實體,有助於資訊萃取和資料探勘等任務。

結論:

BERT 是用於 NLP 任務的強大 AI 工具,提供預訓練的語言表徵,並有能力針對特定應用程式進行微調。憑藉其雙向和語境理解能力,BERT 在各種任務上都達到了最先進的成果。它的多功能性和準確性使其成為研究人員、開發人員和尋求利用 NLP 技術的企業的寶貴資產。

More information on BERT

Launched

Pricing Model

Free

Starting Price

Global Rank

Follow

Month Visit

<5k

Tech used

Related Searches