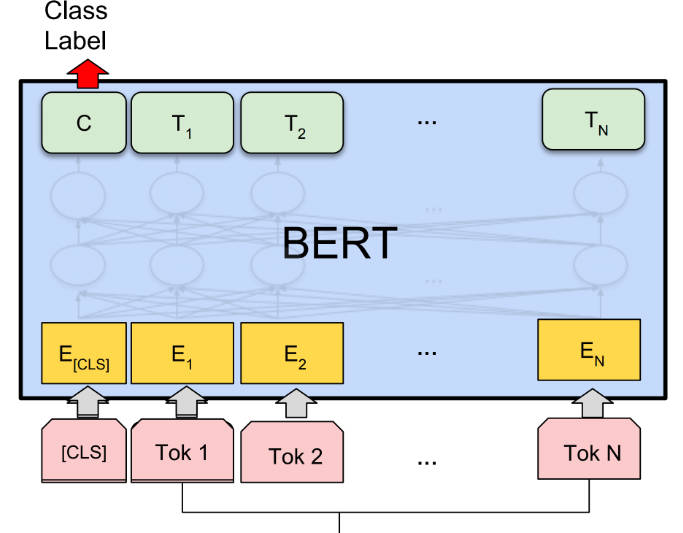

What is BERT?

BERT(Bidirectional Encoder Representations from Transformers)は、さまざまな自然言語処理(NLP)タスクで最先端の結果が得られる、事前トレーニング済み言語表現手法です。教師なしで深い双方向性を備えており、コンテキストの理解が向上します。BERTは、特定のNLPタスクに合わせて微調整することができ、用途が広く効果的です。

主要な機能:

? 事前トレーニング済み言語表現: BERTは大規模テキストコーパスで汎用「言語理解」モデルを事前トレーニングし、単語間の文脈関係を把握します。

? 双方向で深い文脈: 従来のモデルとは異なり、BERTは単語を表すときに左右のコンテキストの両方を考慮し、より正確で微妙な表現を実現します。

? 特定のタスク向けの微調整: BERTは、質問応答、感情分析、命名エンティティ認識などの特定のNLPタスクに合わせて微調整することができ、タスク固有の変更は最小限です。

ユースケース:

? 質問応答: BERTは与えられたコンテキストに基づいて質問に正確に答えることができ、チャットボットや仮想アシスタントなどのアプリケーションに役立ちます。

? 感情分析: BERTは特定のテキストの感情を分析でき、企業は顧客からのフィードバックや感情の傾向を理解できます。

? 命名エンティティ認識: BERTはテキスト内の命名エンティティを識別して分類することができ、情報抽出やデータマイニングなどのタスクに役立ちます。

結論:

BERTは、NLPタスク向けの強力なAIツールで、事前トレーニングされた言語表現と特定のアプリケーションに合わせて微調整する機能を提供します。BERTは双方向で文脈を理解するため、さまざまなタスクで最先端の結果を得ることができます。汎用性と正確性により、NLPテクノロジーを活用しようとする研究者、開発者、企業にとって貴重な資産となります。