What is BERT?

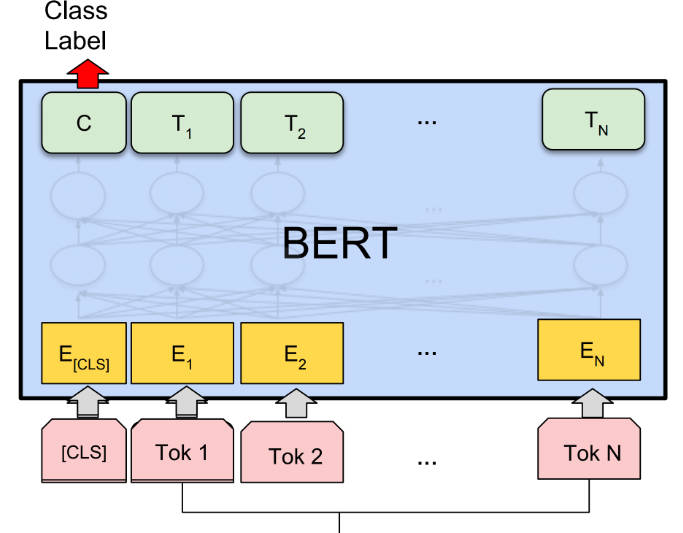

BERT (двунаправленные представления кодировщика из трансформаторов) — это метод предварительной подготовки представления языка, который достигает передовых результатов в различных задачах обработки естественного языка (NLP). Он неконтролируемый и глубоко двунаправленный, что обеспечивает лучшее понимание контекста. BERT можно точно настроить для конкретных задач NLP, что делает его универсальным и эффективным.

Ключевые особенности:

? Предварительная подготовка представлений языка: BERT предварительно обучает универсальную модель "понимания языка" на большом текстовом корпусе, что позволяет ему улавливать контекстные взаимосвязи между словами.

? Двунаправленный и глубоко контекстный: в отличие от предыдущих моделей, BERT учитывает как левый, так и правый контекст при представлении слова, что приводит к более точным и нюансированным представлениям.

? Точная настройка для конкретных задач: BERT можно точно настроить для конкретных задач NLP, таких как ответы на вопросы, анализ настроений и распознавание именованных сущностей, с минимальными модификациями, специфичными для задачи.

Варианты использования:

? Ответы на вопросы: BERT может точно отвечать на вопросы на основе заданного контекста, что делает его ценным для таких приложений, как чат-боты и виртуальные помощники.

? Анализ настроений: BERT может анализировать настроение заданного текста, помогая предприятиям понимать отзывы клиентов и тенденции настроений.

? Распознавание именованных сущностей: BERT может идентифицировать и классифицировать именованные сущности в тексте, что помогает в таких задачах, как извлечение информации и анализ данных.

Вывод:

BERT — это мощный инструмент ИИ для задач NLP, предлагающий предварительно обученные представления языка и возможность точной настройки для конкретных приложений. Благодаря своему двунаправленному и контекстному пониманию BERT достигает передовых результатов в различных задачах. Его универсальность и точность делают его ценным активом для исследователей, разработчиков и предприятий, стремящихся использовать технологию NLP.

More information on BERT

BERT Альтернативи

Больше Альтернативи-

-

Продолжающееся обучение исследовательских моделей трансформаторов в масштабе

-

Улучшите свои возможности NLP с Baichuan-7B — новаторской моделью, которая превосходно справляется с обработкой языка и генерацией текста. Откройте для себя ее двуязычные возможности, универсальность применения и впечатляющую производительность. Формируйте будущее взаимодействия человека и компьютера с Baichuan-7B.

-

-

Jina ColBERT v2 поддерживает 89 языков с превосходной производительностью поиска, управляемыми пользователем размерностями вывода и длиной токена 8192.