What is BERT?

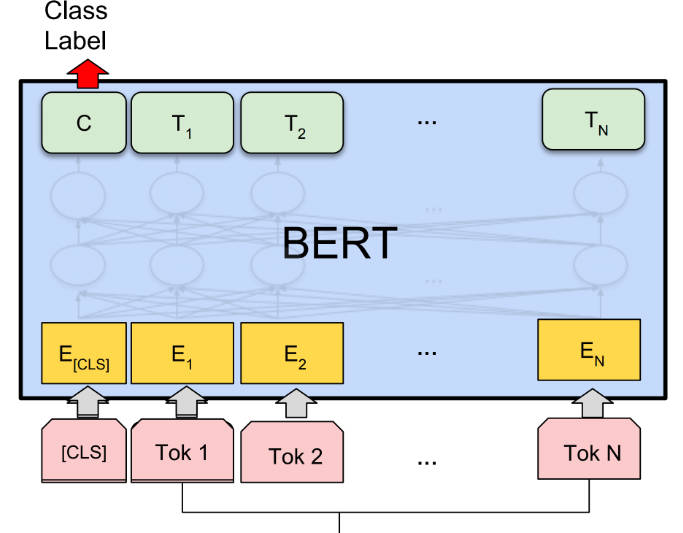

BERT (Bidirectional Encoder Representations from Transformers) es un método de representación de lenguaje de preentrenamiento que logra resultados de vanguardia en diversas tareas de Procesamiento del Lenguaje Natural (PNL). No tiene supervisión y es profundamente bidireccional, lo que permite una mejor comprensión del contexto. BERT se puede ajustar para tareas específicas de PNL, lo que lo hace versátil y eficaz.

Características principales:

? Representaciones de lenguaje de preentrenamiento: BERT preentrena un modelo de "comprensión del lenguaje" de propósito general en un corpus de texto grande, lo que le permite capturar relaciones contextuales entre palabras.

? Bidireccional y profundamente contextual: a diferencia de los modelos anteriores, BERT considera tanto el contexto izquierdo como el derecho al representar una palabra, lo que da como resultado representaciones más precisas y matizadas.

? Ajuste para tareas específicas: BERT se puede ajustar para tareas específicas de PNL, como respuesta a preguntas, análisis de sentimientos y reconocimiento de entidades nombradas, con mínimas modificaciones específicas de la tarea.

Casos de uso:

? Respuesta a preguntas: BERT puede responder preguntas con precisión según un contexto determinado, lo que lo hace valioso para aplicaciones como chatbots y asistentes virtuales.

? Análisis de sentimientos: BERT puede analizar el sentimiento de un texto determinado, lo que ayuda a las empresas a comprender los comentarios de los clientes y las tendencias de sentimientos.

? Reconocimiento de entidades nombradas: BERT puede identificar y clasificar entidades nombradas en el texto, lo que ayuda en tareas como la extracción de información y la minería de datos.

Conclusión:

BERT es una potente herramienta de IA para tareas de PNL, que ofrece representaciones de lenguaje preentrenadas y la capacidad de ajustar para aplicaciones específicas. Con su comprensión bidireccional y contextual, BERT logra resultados de vanguardia en diversas tareas. Su versatilidad y precisión lo convierten en un activo valioso para investigadores, desarrolladores y empresas que buscan aprovechar la tecnología de PNL.

More information on BERT

BERT Alternativas

Más Alternativas-

-

-

Mejora las capacidades de NLP con Baichuan-7B, un modelo innovador que destaca en el procesamiento del lenguaje y la generación de texto. Descubre sus capacidades bilingües, aplicaciones versátiles y rendimiento impresionante. Da forma al futuro de la comunicación hombre-computadora con Baichuan-7B.

-

-

Jina ColBERT v2 admite 89 idiomas con un rendimiento de recuperación superior, dimensiones de salida controladas por el usuario y una longitud de token de 8192.