What is BERT?

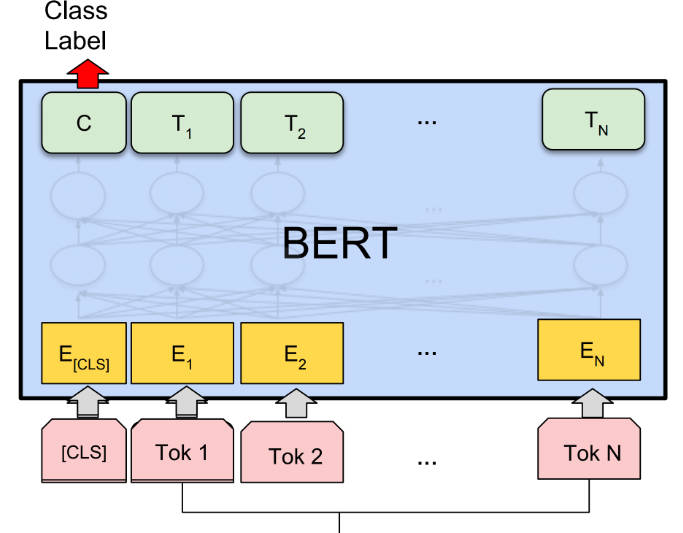

BERT(Bidirectional Encoder Representations from Transformers)는 다양한 자연어 처리(NLP) 과제에서 첨단 성과를 달성하는 사전 훈련된 언어 표현 방법입니다. 이는 무지도이며 깊게 양방향으로 진행되어 더 나은 맥락 이해를 가능하게 합니다. BERT는 특정 NLP 과제에 맞게 미세 조정이 가능하여 다목적이고 효과적입니다.

주요 특징:

? 사전 훈련된 언어 표현: BERT는 대규모 텍스트 말뭉치에 대해 일반적인 용도의 "언어 이해" 모델을 사전 훈련하여 단어 간의 맥락적 관계를 파악할 수 있습니다.

? 양방향적이고 깊게 맥락적: BERT는 이전 모델과 달리 단어를 표현할 때 왼쪽과 오른쪽 맥락을 모두 고려하여 더 정확하고 미묘한 표현을 만듭니다.

? 특정 과제 맞춤형 미세 조정: BERT는 질문 답변, 감성 분석, 개체명 인식 등의 특정 NLP 과제에 대해 과제별 수정을 최소화하여 미세 조정이 가능합니다.

사례:

? 질문 답변: BERT는 주어진 맥락을 기반으로 질문에 정확하게 답변할 수 있어 챗봇 및 가상 비서와 같은 응용 프로그램에 가치가 있습니다.

? 감성 분석: BERT는 주어진 텍스트의 감성을 분석하여 기업이 고객 피드백과 감성 동향을 이해하는 데 도움이 됩니다.

? 개체명 인식: BERT는 텍스트에서 개체명을 식별하고 분류하여 정보 추출 및 데이터 마이닝과 같은 과제에 도움이 됩니다.

결론:

BERT는 사전 훈련된 언어 표현과 특정 응용 프로그램에 맞게 미세 조정하는 기능을 제공하는 NLP 과제를 위한 강력한 AI 도구입니다. 양방향적이고 맥락적 이해를 통해 BERT는 다양한 과제에서 첨단 성과를 달성합니다. 그 다목적성과 정확성은 NLP 기술을 활용하고자 하는 연구자, 개발자, 기업에 가치 있는 자산이 됩니다.