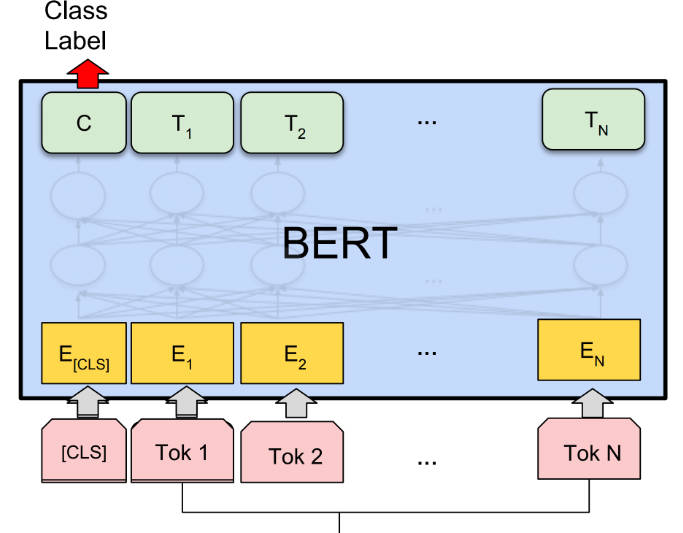

What is BERT?

BERT (Bidirectional Encoder Representations from Transformers) est une méthode de représentation linguistique pré-entraînée qui atteint des résultats de pointe sur diverses tâches de traitement du langage naturel (PNL). Elle est non supervisée et profondément bidirectionnelle, ce qui permet une meilleure compréhension du contexte. BERT peut être ajusté pour des tâches PNL spécifiques, ce qui le rend polyvalent et efficace.

Caractéristiques principales :

? Représentations linguistiques pré-entraînées : BERT pré-entraîne un modèle de « compréhension linguistique » à usage général sur un grand corpus de texte, ce qui lui permet de saisir les relations contextuelles entre les mots.

? Bidirectionnel et profondément contextuel : Contrairement aux modèles précédents, BERT considère à la fois le contexte de gauche et de droite lors de la représentation d'un mot, ce qui entraîne des représentations plus précises et nuancées.

? Ajustement pour des tâches spécifiques : BERT peut être ajusté pour des tâches PNL spécifiques, telles que la réponse aux questions, l'analyse des sentiments et la reconnaissance d'entités nommées, avec des modifications minimales spécifiques à la tâche.

Cas d'utilisation :

? Réponse aux questions : BERT peut répondre avec précision aux questions en fonction d'un contexte donné, ce qui le rend précieux pour des applications telles que les chatbots et les assistants virtuels.

? Analyse des sentiments : BERT peut analyser le sentiment d'un texte donné, aidant les entreprises à comprendre les commentaires des clients et les tendances des sentiments.

? Reconnaissance d'entités nommées : BERT peut identifier et classer les entités nommées dans le texte, aidant dans des tâches telles que l'extraction d'informations et l'exploration de données.

Conclusion :

BERT est un puissant outil d'IA pour les tâches PNL, offrant des représentations linguistiques pré-entraînées et la possibilité d'un ajustement pour des applications spécifiques. Grâce à sa compréhension bidirectionnelle et contextuelle, BERT atteint des résultats de pointe dans diverses tâches. Sa polyvalence et sa précision en font un atout précieux pour les chercheurs, les développeurs et les entreprises cherchant à exploiter la technologie PNL.

More information on BERT

BERT Alternatives

Plus Alternatives-

-

Formation de recherche en cours sur les modèles de transformateur à grande échelle

-

Développez vos capacités de PNL avec Baichuan-7B, un modèle révolutionnaire qui excelle dans le traitement du langage et la génération de texte. Découvrez ses capacités bilingues, ses applications polyvalentes et ses performances impressionnantes. Façonnez l'avenir de la communication homme-machine avec Baichuan-7B.

-

-

Jina ColBERT v2 prend en charge 89 langues avec des performances de récupération supérieures, des dimensions de sortie contrôlées par l'utilisateur et une longueur de jeton de 8192.