What is ModelBench?

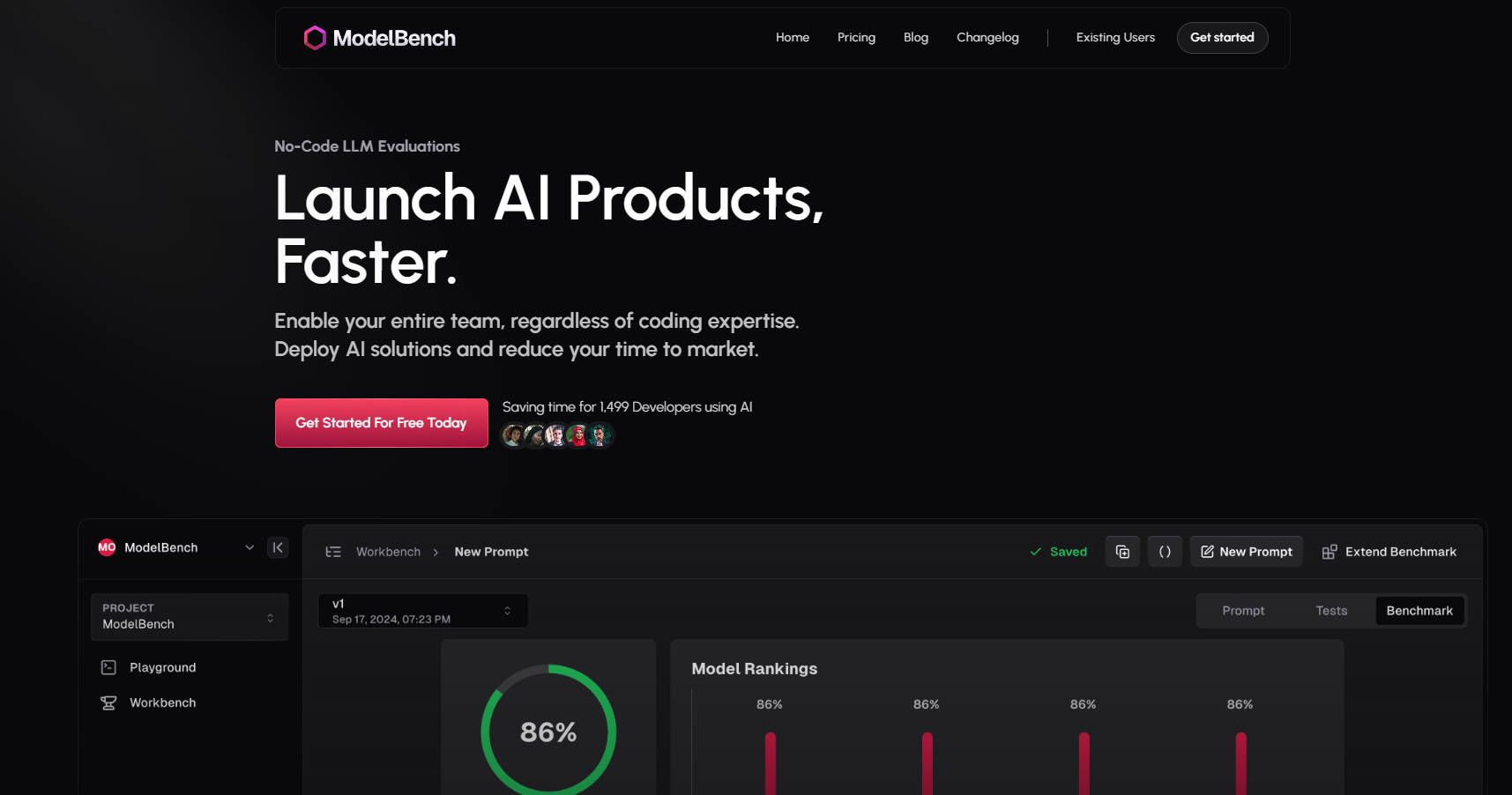

ModelBench es tu plataforma integral para construir, probar e implementar soluciones de IA más rápido. Ya seas gestor de producto, ingeniero de prompts o desarrollador, ModelBench permite a tu equipo experimentar, comparar y optimizar modelos de lenguaje extenso (LLM) sin la molestia de programar.

¿Por qué ModelBench?

Ahorra Tiempo: Compara más de 180 LLM uno al lado del otro e identifica los modelos y prompts con mejor rendimiento en minutos.

Simplicidad sin Código: Permite a todo tu equipo experimentar e iterar, independientemente de su experiencia técnica.

Implementación más Rápida: Reduce drásticamente el tiempo de desarrollo y prueba, acortando el tiempo de lanzamiento al mercado.

Características Clave ?

✅ Compara más de 180 Modelos Simultáneamente

Prueba y evalúa múltiples LLM al mismo tiempo para encontrar el ajuste perfecto para tu caso de uso.

✅ Crea y Ajusta Prompts

Diseña, refina y prueba prompts con retroalimentación inmediata de múltiples modelos.

✅ Entradas Dinámicas para Pruebas Escalables

Importa conjuntos de datos desde herramientas como Google Sheets y prueba prompts en innumerables escenarios.

✅ Comparativas con Humanos o IA

Realiza evaluaciones utilizando IA, revisores humanos o una combinación de ambos para obtener resultados fiables.

✅ Rastrea y Repite Ejecuciones de LLM

Monitoriza las interacciones, reproduce las respuestas y detecta resultados de baja calidad con integraciones sin código.

✅ Colabora con tu Equipo

Comparte prompts, resultados y comparativas sin problemas para acelerar el desarrollo.

Cómo Funciona ModelBench

Entorno de Pruebas (Playground):

Compara más de 180 modelos en tiempo real.

Prueba prompts e integra herramientas personalizadas sin esfuerzo.

Banco de Trabajo (Workbench):

Convierte experimentos en comparativas estructuradas.

Prueba prompts a escala con entradas dinámicas y control de versiones.

Comparativas (Benchmarking):

Realiza múltiples rondas de pruebas en diferentes modelos.

Analiza los resultados para refinar y mejorar tus prompts.

¿Para Quién es ModelBench?

Gestores de Producto: Valida rápidamente soluciones de IA y reduce el tiempo de lanzamiento al mercado.

Ingenieros de Prompts: Ajusta prompts y compara el rendimiento entre modelos.

Desarrolladores: Experimenta con LLM sin necesidad de programación compleja o frameworks.

Casos de Uso

Chatbots para Comercio Electrónico: Prueba y optimiza prompts para atención al cliente en múltiples LLM.

Generación de Contenido: Compara modelos para encontrar el más adecuado para generar contenido de alta calidad y acorde a la marca.

Herramientas con IA: Compara LLM para tareas como resumen, traducción o análisis de sentimiento.

Comienza Hoy

Únete a 1499 desarrolladores y equipos de empresas como Amazon, Google y Twitch que ya están ahorrando tiempo con ModelBench.

More information on ModelBench

Top 5 Countries

Traffic Sources

ModelBench Alternativas

Más Alternativas-

Evalúa modelos de lenguaje grandes fácilmente con PromptBench. Evalúa el rendimiento, mejora las capacidades del modelo y prueba la robustez frente a indicaciones adversas.

-

PromptTools es una plataforma de código abierto que ayuda a los desarrolladores a construir, monitorizar y mejorar aplicaciones de LLM mediante la experimentación, la evaluación y la retroalimentación.

-

PromptBuilder brinda resultados de LLM de nivel experto de forma consistente. Optimiza tus prompts para ChatGPT, Claude y Gemini en cuestión de segundos.

-

BenchLLM: Evalúe las respuestas de LLM, cree conjuntos de pruebas, automatice las evaluaciones. Mejore los sistemas impulsados por IA con evaluaciones de rendimiento integrales.

-

WildBench es una herramienta de evaluación avanzada que evalúa los LLM en un conjunto diverso de tareas del mundo real. Es esencial para aquellos que buscan mejorar el rendimiento de la IA y comprender las limitaciones del modelo en escenarios prácticos.