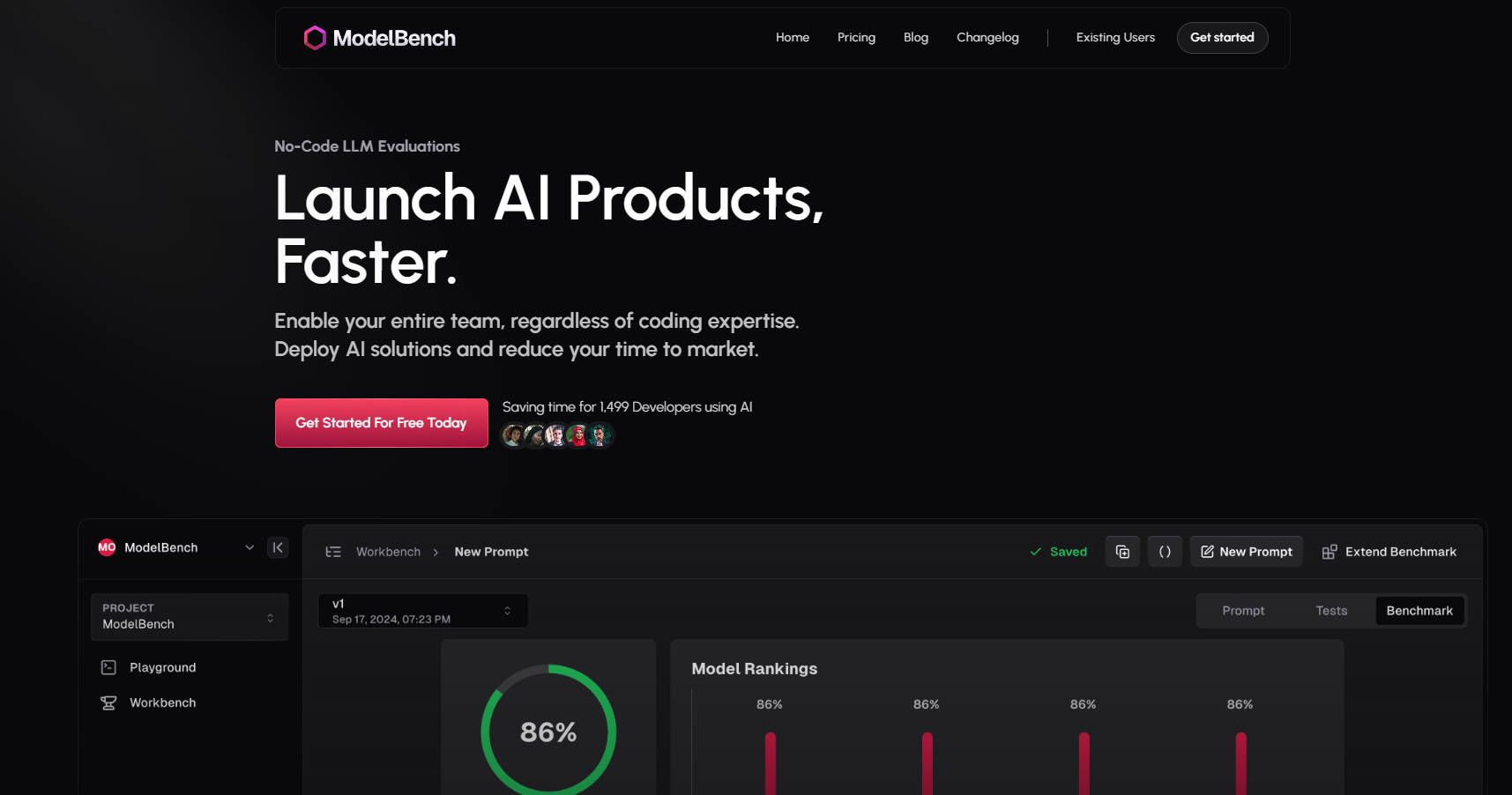

What is ModelBench?

ModelBench est votre plateforme tout-en-un pour construire, tester et déployer des solutions d'IA plus rapidement. Que vous soyez chef de produit, ingénieur d'invite ou développeur, ModelBench permet à votre équipe d'expérimenter, de comparer et d'optimiser les grands modèles de langage (LLM) sans les tracas du codage.

Pourquoi ModelBench ?

Gain de temps : Comparez plus de 180 LLM côte à côte et identifiez les modèles et les invites les plus performants en quelques minutes.

Simplicité sans code : Permettez à toute votre équipe d'expérimenter et d'itérer, quelle que soit son expertise technique.

Déploiement accéléré : Réduisez considérablement les délais de développement et de test, diminuant ainsi votre délai de mise sur le marché.

Fonctionnalités clés ?

✅ Comparer plus de 180 modèles côte à côte

Testez et évaluez simultanément plusieurs LLM pour trouver le modèle parfaitement adapté à votre cas d'utilisation.

✅ Concevoir et affiner les invites

Concevez, affinez et testez les invites avec un retour immédiat de plusieurs modèles.

✅ Entrées dynamiques pour des tests évolutifs

Importez des jeux de données à partir d'outils comme Google Sheets et testez les invites dans d'innombrables scénarios.

✅ Étalonnage avec des humains ou une IA

Effectuez des évaluations à l'aide de l'IA, de relecteurs humains ou d'un mélange des deux pour des résultats fiables.

✅ Tracer et rejouer les exécutions de LLM

Surveillez les interactions, rejouez les réponses et détectez les sorties de faible qualité grâce à des intégrations sans code.

✅ Collaborer avec votre équipe

Partagez des invites, des résultats et des analyses comparatives en toute transparence pour accélérer le développement.

Fonctionnement de ModelBench

Espace de jeu :

Comparez plus de 180 modèles en temps réel.

Testez les invites et intégrez des outils personnalisés sans effort.

Atelier :

Transformez les expériences en analyses comparatives structurées.

Testez les invites à grande échelle avec des entrées dynamiques et le contrôle de version.

Analyse comparative :

Effectuez plusieurs séries de tests sur différents modèles.

Analysez les résultats pour affiner et améliorer vos invites.

À qui s'adresse ModelBench ?

Chefs de produit : Validez rapidement les solutions d'IA et réduisez le délai de mise sur le marché.

Ingénieurs d'invite : Affinez les invites et évaluez les performances des modèles.

Développeurs : Expérimentez avec les LLM sans codage complexe ni framework.

Cas d'utilisation

Chatbots e-commerce : Testez et optimisez les invites pour le support client sur plusieurs LLM.

Génération de contenu : Comparez les modèles pour trouver celui qui convient le mieux à la génération de contenu de haute qualité et fidèle à la marque.

Outils basés sur l'IA : Évaluez les LLM pour des tâches telles que la summarisation, la traduction ou l'analyse des sentiments.

Commencez dès aujourd'hui

Rejoignez 1 499 développeurs et équipes d'entreprises comme Amazon, Google et Twitch qui économisent déjà du temps grâce à ModelBench.

More information on ModelBench

Top 5 Countries

Traffic Sources

ModelBench Alternatives

Plus Alternatives-

Évaluez facilement les grands modèles linguistiques avec PromptBench. Estimez les performances, améliorez les capacités du modèle et testez la robustesse face aux invites adverses.

-

PromptTools est une plateforme open-source qui aide les développeurs à construire, surveiller et améliorer les applications LLM grâce à l'expérimentation, l'évaluation et la rétroaction.

-

PromptBuilder génère systématiquement des résultats de LLM de niveau expert. Optimisez les prompts pour ChatGPT, Claude et Gemini en quelques secondes.

-

BenchLLM : Évaluez les réponses des LLM, construisez des suites de tests, automatisez les évaluations. Améliorez les systèmes pilotés par l’IA grâce à des évaluations de performance complètes.

-

WildBench est un outil de benchmark avancé qui évalue les LLM sur un ensemble diversifié de tâches du monde réel. Il est essentiel pour ceux qui cherchent à améliorer les performances de l'IA et à comprendre les limites des modèles dans des scénarios pratiques.