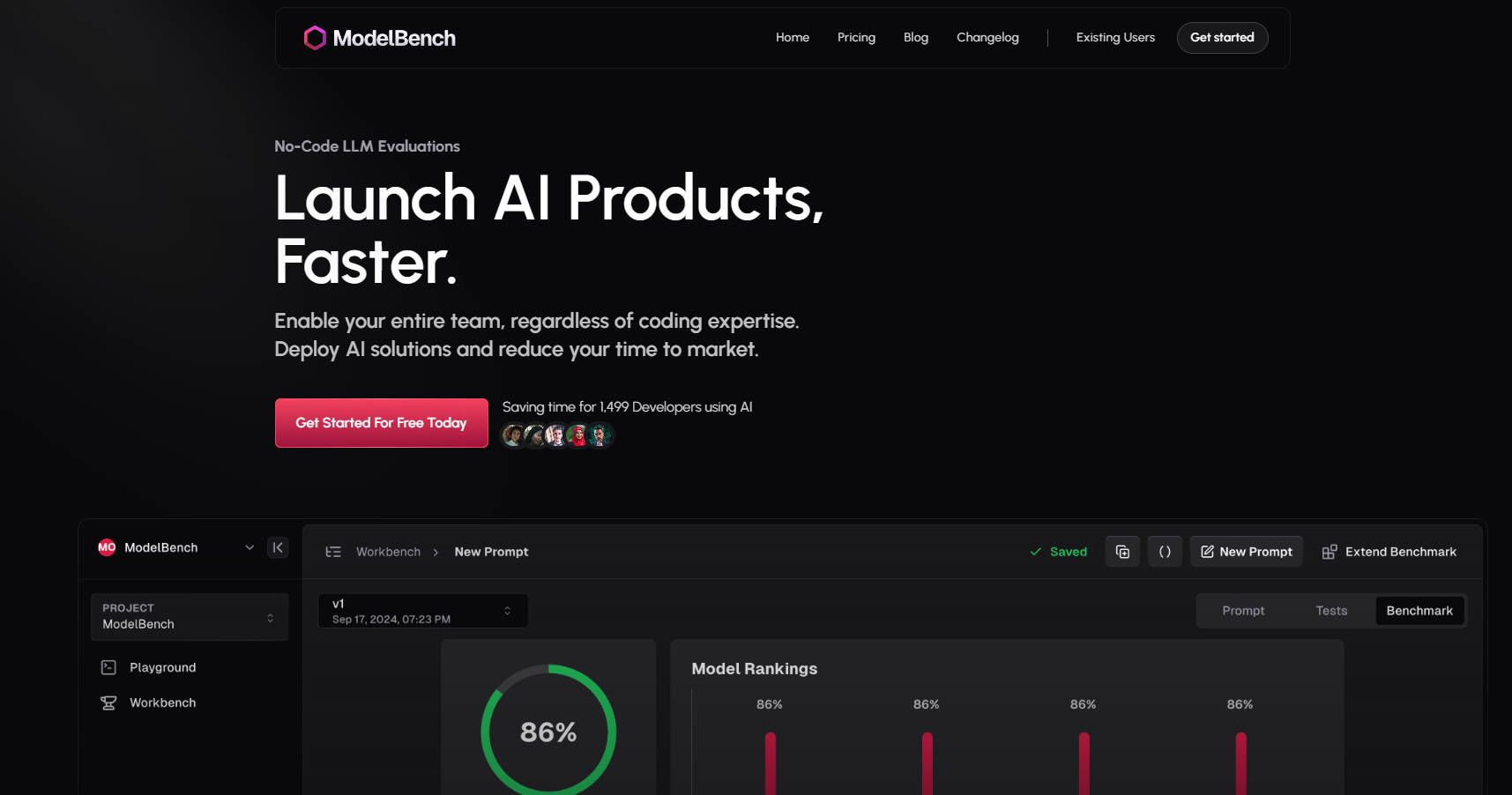

What is ModelBench?

ModelBenchは、AIソリューションの構築、テスト、展開を迅速化するオールインワンプラットフォームです。プロダクトマネージャー、プロンプトエンジニア、開発者の皆様、ModelBenchは、コーディングの手間をかけることなく、大規模言語モデル(LLM)を自由に実験、比較、最適化できる環境を提供します。

ModelBenchを選ぶ理由

時間の節約:180種類以上のLLMを並べて比較し、最良のパフォーマンスを発揮するモデルとプロンプトを数分で特定できます。

ノーコードのシンプルさ:技術的な専門知識に関わらず、チーム全体が実験と反復作業を行うことができます。

迅速な展開:開発とテストの時間を大幅に短縮し、市場投入までの時間を短縮します。

主な機能?

✅ 180種類以上のモデルを並べて比較

複数のLLMを同時にテストおよび評価し、ユースケースに最適なモデルを見つけます。

✅ プロンプトの作成と微調整

複数のモデルからの即時フィードバックにより、プロンプトを設計、改良、テストします。

✅ スケーラブルなテストのための動的入力

Googleスプレッドシートなどのツールからデータセットをインポートし、無数のシナリオでプロンプトをテストします。

✅ 人間またはAIによるベンチマーク

AI、ヒューマンレビューアー、またはその両方を使用して評価を実行し、信頼性の高い結果を得ます。

✅ LLM実行の追跡と再生

ノーコード統合により、インタラクションの監視、応答の再生、低品質な出力の検出が可能です。

✅ チームとの連携

プロンプト、結果、ベンチマークをシームレスに共有して、開発を加速します。

ModelBenchの仕組み

Playground:

180種類以上のモデルをリアルタイムで比較します。

プロンプトをテストし、カスタムツールを簡単に統合します。

Workbench:

実験を構造化されたベンチマークに変換します。

動的入力とバージョン管理を使用して、大規模にプロンプトをテストします。

Benchmarking:

モデル間で複数ラウンドのテストを実行します。

結果を分析して、プロンプトを改良します。

ModelBenchの対象ユーザー

プロダクトマネージャー:AIソリューションを迅速に検証し、市場投入までの時間を短縮します。

プロンプトエンジニア:プロンプトを微調整し、モデル間のパフォーマンスをベンチマークします。

開発者:複雑なコーディングやフレームワークを使用せずに、LLMを試行できます。

ユースケース

Eコマースチャットボット:複数のLLMで顧客サポートのプロンプトをテストおよび最適化します。

コンテンツ生成:高品質でブランドに合ったコンテンツを生成するために最適なモデルを見つけます。

AI搭載ツール:要約、翻訳、感情分析などのタスクについて、LLMをベンチマークします。

今すぐ始めましょう

Amazon、Google、Twitchなどの企業の1,499人の開発者およびチームと共に、ModelBenchで時間を節約しましょう。

More information on ModelBench

Top 5 Countries

Traffic Sources

ModelBench 代替ソフト

もっと見る 代替ソフト-

PromptBench で大規模言語モデルを簡単に評価しましょう。パフォーマンスを評価し、モデルの機能を強化し、敵対的なプロンプトに対する堅牢性をテストします。

-

PromptToolsは、実験、評価、フィードバックを通じて、開発者がLLMアプリケーションを構築、監視、改善するのを支援するオープンソースプラットフォームです。

-

PromptBuilderは、常に専門家レベルのLLM結果を安定して実現します。ChatGPT、Claude、Gemini向けのプロンプトを、わずか数秒で最適化できます。

-

BenchLLM: LLMレスポンスを評価し、テストスイートを構築し、評価を自動化します。包括的なパフォーマンス評価により、AI駆動システムを強化します。

-

WildBenchは、現実世界のさまざまなタスクでLLMを評価する、高度なベンチマークツールです。AIのパフォーマンスを向上させ、実際のシナリオにおけるモデルの限界を理解したいと考えている人にとって不可欠です。