What is ModelBench?

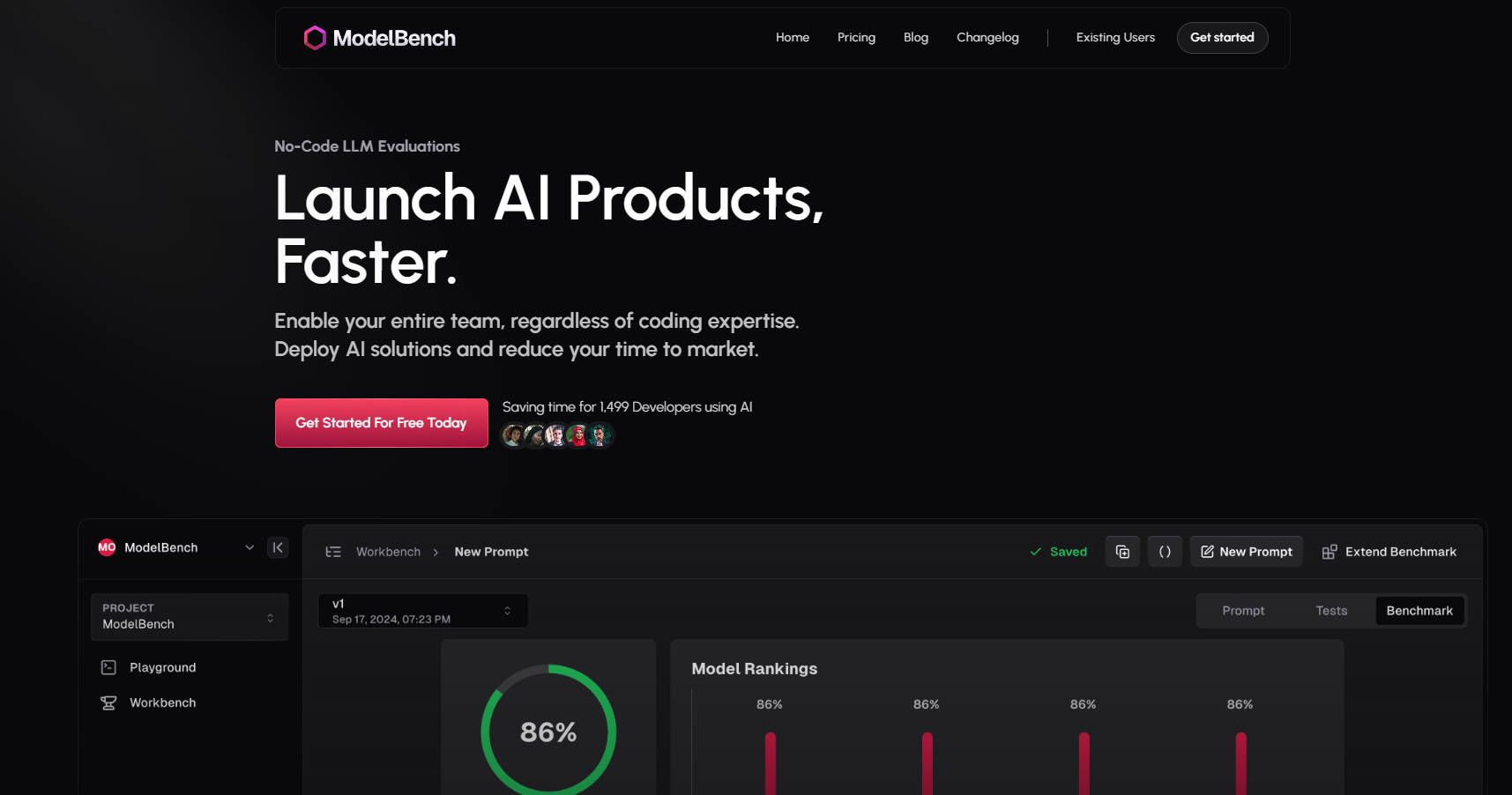

ModelBench 是您构建、测试和部署 AI 解决方案的“一站式”平台,可显著加快开发速度。无论您是产品经理、提示词工程师还是开发者,ModelBench 都能赋能您的团队,让您轻松实验、比较和优化大型语言模型 (LLM),无需繁琐的编码。

为什么选择 ModelBench?

节省时间:并排比较 180 多个 LLM,在几分钟内即可找到性能最佳的模型和提示词。

无需代码的简易性:让您的整个团队都能参与实验和迭代,无论其技术专长如何。

更快的部署:大幅缩短开发和测试时间,缩短上市时间。

主要功能?

✅ 并排比较 180 多个模型

同时测试和评估多个 LLM,以找到最适合您用例的模型。

✅ 创建和微调提示词

设计、改进和测试提示词,并从多个模型获得即时反馈。

✅ 动态输入,实现可扩展的测试

从 Google Sheets 等工具导入数据集,并在无数场景中测试提示词。

✅ 与人类或 AI 进行基准测试

使用 AI、人工审核员或两者结合进行评估,以获得可靠的结果。

✅ 追踪和回放 LLM 运行

监控交互、回放响应并检测低质量输出,无需代码集成。

✅ 与您的团队协作

无缝共享提示词、结果和基准,从而加快开发速度。

ModelBench 的工作原理

Playground(实验场):

实时比较 180 多个模型。

轻松测试提示词并集成自定义工具。

Workbench(工作台):

将实验转化为结构化的基准测试。

使用动态输入和版本控制大规模测试提示词。

Benchmarking(基准测试):

对多个模型进行多轮测试。

分析结果以改进和优化您的提示词。

谁适合使用 ModelBench?

产品经理:快速验证 AI 解决方案并缩短上市时间。

提示词工程师:微调提示词并在多个模型中进行性能基准测试。

开发者:无需复杂的编码或框架即可体验 LLM。

用例

电子商务聊天机器人:测试和优化针对多个 LLM 的客户支持提示词。

内容生成:比较模型以找到最适合生成高质量、符合品牌形象内容的模型。

AI 驱动的工具:对 LLM 进行基准测试,以完成摘要、翻译或情感分析等任务。

立即开始

加入来自亚马逊、谷歌和 Twitch 等公司的 1499 位开发者和团队,一起使用 ModelBench 节省时间。