What is AI2 WildBench Leaderboard?

WildBench es una herramienta de evaluación de vanguardia diseñada para evaluar las capacidades de los modelos de lenguaje grandes (LLM) enfrentándolos a un conjunto diverso de tareas desafiantes que imitan las interacciones del usuario en el mundo real. Esta plataforma innovadora garantiza que el rendimiento de los LLM se evalúe en base a una comprensión matizada del lenguaje humano y el contexto, proporcionando información valiosa sobre sus fortalezas y debilidades.

Características Clave

Simulación de Tareas del Mundo Real: WildBench utiliza tareas recopiladas de WildChat, un conjunto de datos extenso de interacciones humano-GPT, asegurando que las evaluaciones reflejen escenarios de usuarios genuinos.

Diversas Categorías de Tareas: Con 12 categorías de tareas, WildBench abarca una amplia gama de escenarios de usuarios reales, manteniendo una distribución equilibrada que los benchmarks tradicionales no pueden igualar.

Anotación Integral: Cada tarea incluye anotaciones detalladas como tipos de tareas secundarias e intenciones del usuario, ofreciendo un nivel más profundo de información para las evaluaciones de respuesta.

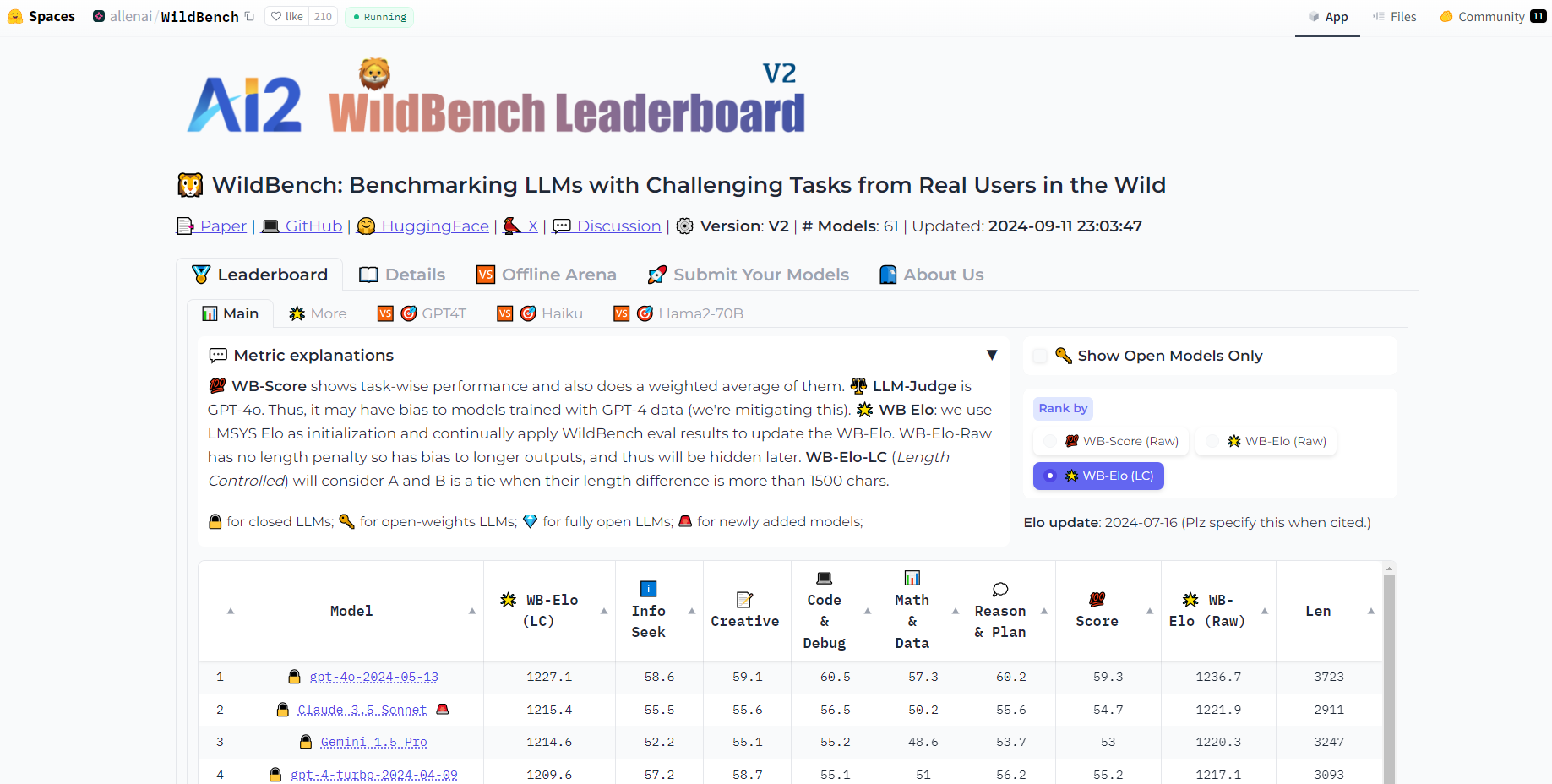

Métricas de Evaluación Innovadoras: WildBench emplea un sistema de puntuación basado en listas de verificación, una puntuación WB para la evaluación individual del modelo y una recompensa WB para el análisis comparativo entre modelos.

Mitigación del Sesgo de Longitud: Para garantizar evaluaciones justas, WildBench ha introducido un método de penalización de longitud personalizable que contrarresta la倾向 de los jueces de LLM a favorecer las respuestas más largas.

Casos de Uso

Desarrolladores de Modelos: Mejore el rendimiento de los LLM identificando sus debilidades a través de las evaluaciones integrales de WildBench.

Investigadores de IA: Obtenga nuevas ideas sobre las capacidades de los LLM cuando se enfrentan a las complejidades de las tareas del mundo real, informando las futuras direcciones de investigación.

Soluciones Empresariales: Las empresas pueden utilizar WildBench para seleccionar los LLM más adecuados para la atención al cliente, la creación de contenido y otras aplicaciones comerciales.

Conclusión

WildBench está revolucionando la forma en que evaluamos los modelos de lenguaje de IA al proporcionar una plataforma de evaluación realista y matizada. Su impacto práctico se extiende a través de las industrias, permitiendo el desarrollo de soluciones de IA más capaces y confiables. Descubra el verdadero potencial de la IA con WildBench, donde los desafíos del mundo real se encuentran con la IA de vanguardia.

More information on AI2 WildBench Leaderboard

AI2 WildBench Leaderboard Alternativas

Más Alternativas-

-

Lanza productos de IA más rápido con evaluaciones LLM sin código. Compara más de 180 modelos, crea prompts y prueba con confianza.

-

BenchLLM: Evalúe las respuestas de LLM, cree conjuntos de pruebas, automatice las evaluaciones. Mejore los sistemas impulsados por IA con evaluaciones de rendimiento integrales.

-

Web Bench es un conjunto de datos de evaluación comparativa (benchmark) novedoso, abierto e integral, diseñado específicamente para evaluar el rendimiento de los agentes de IA de navegación web en tareas complejas y del mundo real, que abarcan una amplia diversidad de sitios web activos.

-