What is Felafax?

Felafax revoluciona el panorama del entrenamiento de IA optimizando el ajuste fino del modelo Llama 3.1 405B en GPUs que no son de NVIDIA, particularmente TPUs, a un costo significativamente menor. Esta plataforma de vanguardia agiliza la configuración y la gestión de clústeres de entrenamiento a gran escala, aprovechando una arquitectura XLA personalizada para igualar el rendimiento de NVIDIA H100 con una reducción del 30% en los gastos. Adaptado para empresas y startups, Felafax introduce una orquestación sin esfuerzo para tareas complejas de múltiples GPU, mejorada por entornos preconfigurados y la promesa de una próxima implementación de JAX para una mayor eficiencia.

Características clave:

Clústeres de entrenamiento grandes con un solo clic: cree instantáneamente clústeres de entrenamiento escalables de 8 a 1024 chips GPU que no sean de NVIDIA, con una orquestación perfecta para cualquier tamaño de modelo.

Rendimiento insuperable y rentabilidad: utilizando un marco XLA personalizado que no es CUDA, Felafax ofrece un rendimiento equivalente a NVIDIA H100 con una reducción del 30% en el costo, ideal para modelos grandes.

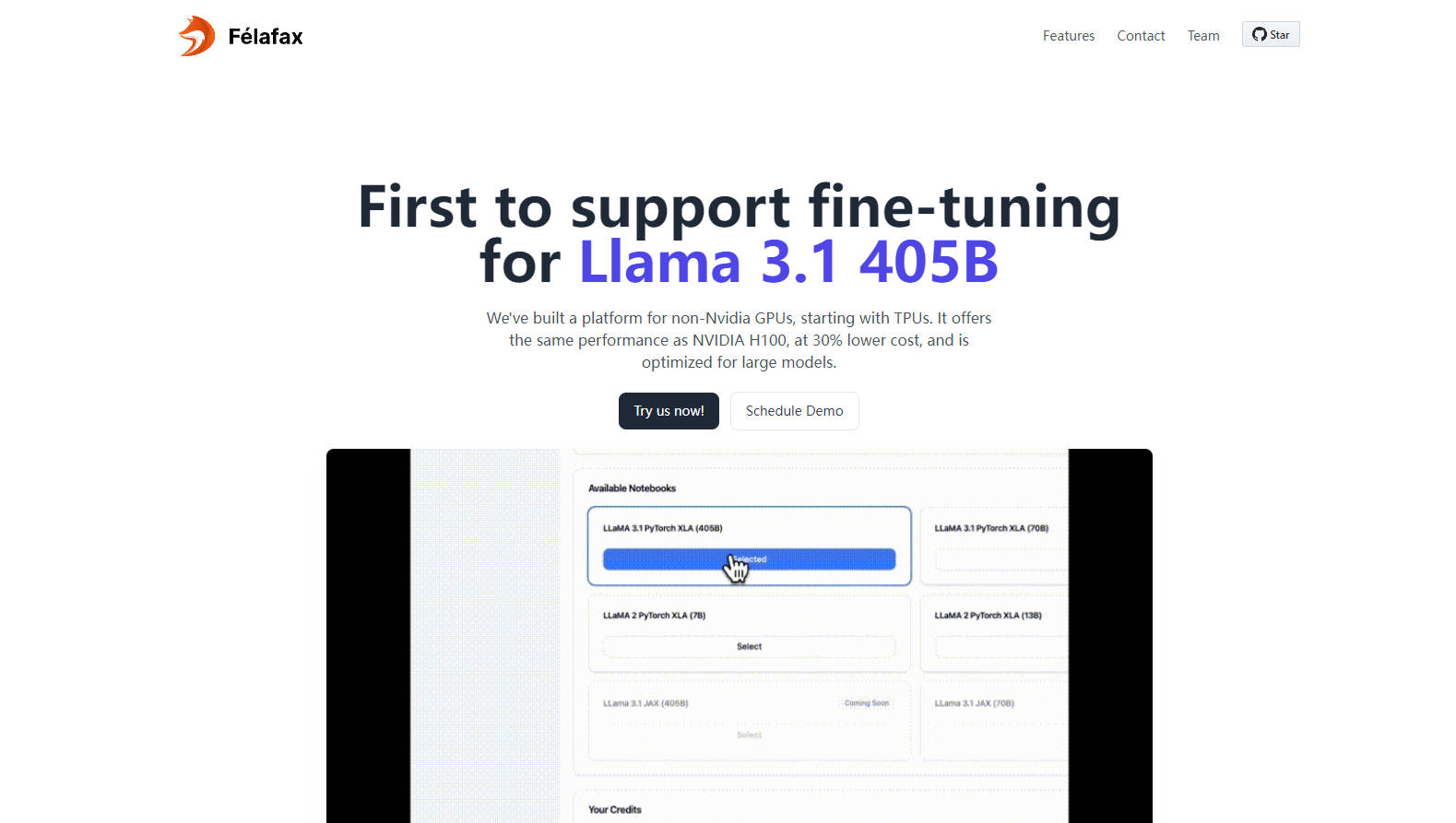

Personalización y control completos: acceda a entornos de cuaderno Jupyter totalmente personalizables para ejecuciones de entrenamiento personalizadas, asegurando un control completo y cero compromisos.

Particionamiento avanzado de modelos y orquestación: optimizado para Llama 3.1 405B, Felafax administra el particionamiento de modelos, los puntos de control distribuidos y el entrenamiento multicanal para una facilidad incomparable.

Entornos preconfigurados e integración JAX próximamente: elija entre Pytorch XLA o JAX con todas las dependencias preinstaladas, listas para usar de inmediato, y anticipe un entrenamiento 25% más rápido con la implementación de JAX.

Casos de uso:

Proyectos de aprendizaje automático empresarial: las startups que se embarcan en proyectos de IA ahora pueden lograr resultados de vanguardia en TPUs sin la sobrecarga o el gasto del hardware de NVIDIA.

Instituciones académicas: las universidades obtienen una solución rentable para las necesidades de computación de alto rendimiento, lo que potencia la investigación y la educación en modelos de IA complejos.

Empresas que escalan la IA: las empresas multinacionales pueden optimizar el desarrollo e implementación de la IA aprovechando la infraestructura asequible y de alta capacidad para sus necesidades de ajuste fino del modelo Llama 3.1 405B.

Conclusión:

Felafax es un faro para la comunidad de la IA, siendo pionero en el entrenamiento rentable y de alto rendimiento en GPUs que no son de NVIDIA. Ya sea que sea un investigador, una startup o una empresa que necesita soluciones de IA escalables, Felafax lo invita a experimentar el futuro del ajuste fino de modelos hoy. Descubra su crédito de $200 y comience a dar forma al panorama de la IA en sus términos.

Preguntas frecuentes:

Pregunta: ¿Cómo logra Felafax un costo 30% más bajo en comparación con el rendimiento de NVIDIA H100?

Respuesta: Felafax utiliza un marco XLA personalizado y que no es CUDA que optimiza el entrenamiento en GPUs alternativas, como TPUs, AWS Trainium, AMD GPU e Intel GPU, asegurando un rendimiento igual con costos significativamente reducidos.

Pregunta: ¿Para qué puedo usar Felafax en este momento?

Respuesta: Actualmente, Felafax ofrece una configuración de capa de nube sin problemas para clústeres de entrenamiento de IA, entornos personalizados para Pytorch XLA y JAX, y un ajuste fino simplificado para modelos Llama 3.1. ¡Esté atento a la implementación de JAX próximamente!

Pregunta: ¿Puede Felafax manejar modelos grandes como Llama 405B?

Respuesta: Sí, Felafax está optimizado para modelos grandes, incluido Llama 3.1 405B, administrando el particionamiento de modelos, los puntos de control distribuidos y la orquestación del entrenamiento para facilitar las complejidades de las tareas de múltiples GPU.

More information on Felafax

Top 5 Countries

Traffic Sources

Felafax Alternativas

Más Alternativas-

-

-

-

Impulsa tus proyectos de IA generativa con PeriFlow de FriendliAI. El motor de servicio LLM más rápido, opciones de implementación flexibles, con la confianza de líderes de la industria.

-

LLaMA Factory es un marco de ajuste fino de modelos grandes de código bajo de código abierto que integra las técnicas de ajuste fino ampliamente utilizadas en la industria y admite el ajuste fino de modelos grandes sin código a través de la interfaz de usuario web.