What is Felafax?

Felafax révolutionne le paysage de l'entraînement de l'IA en optimisant l'ajustement fin du modèle Llama 3.1 405B sur des GPU non-NVIDIA, en particulier les TPU, à un coût significativement inférieur. Cette plateforme de pointe simplifie la configuration et la gestion des clusters d'entraînement à grande échelle, tirant parti d'une architecture XLA personnalisée pour égaler les performances du NVIDIA H100 avec une réduction de 30 % des dépenses. Conçue pour les entreprises et les startups, Felafax introduit une orchestration sans effort pour les tâches multi-GPU complexes, renforcée par des environnements préconfigurés et la promesse d'une implémentation JAX à venir pour une efficacité accrue.

Fonctionnalités clés :

Clusters d'entraînement de grande taille en un clic - Créez instantanément des clusters d'entraînement évolutifs de 8 à 1024 puces GPU non-NVIDIA, avec une orchestration transparente pour toute taille de modèle.

Performances imbattables et rentabilité - Utilisant un framework XLA non-CUDA personnalisé, Felafax offre des performances équivalentes à celles du NVIDIA H100 à un coût réduit de 30 %, idéal pour les grands modèles.

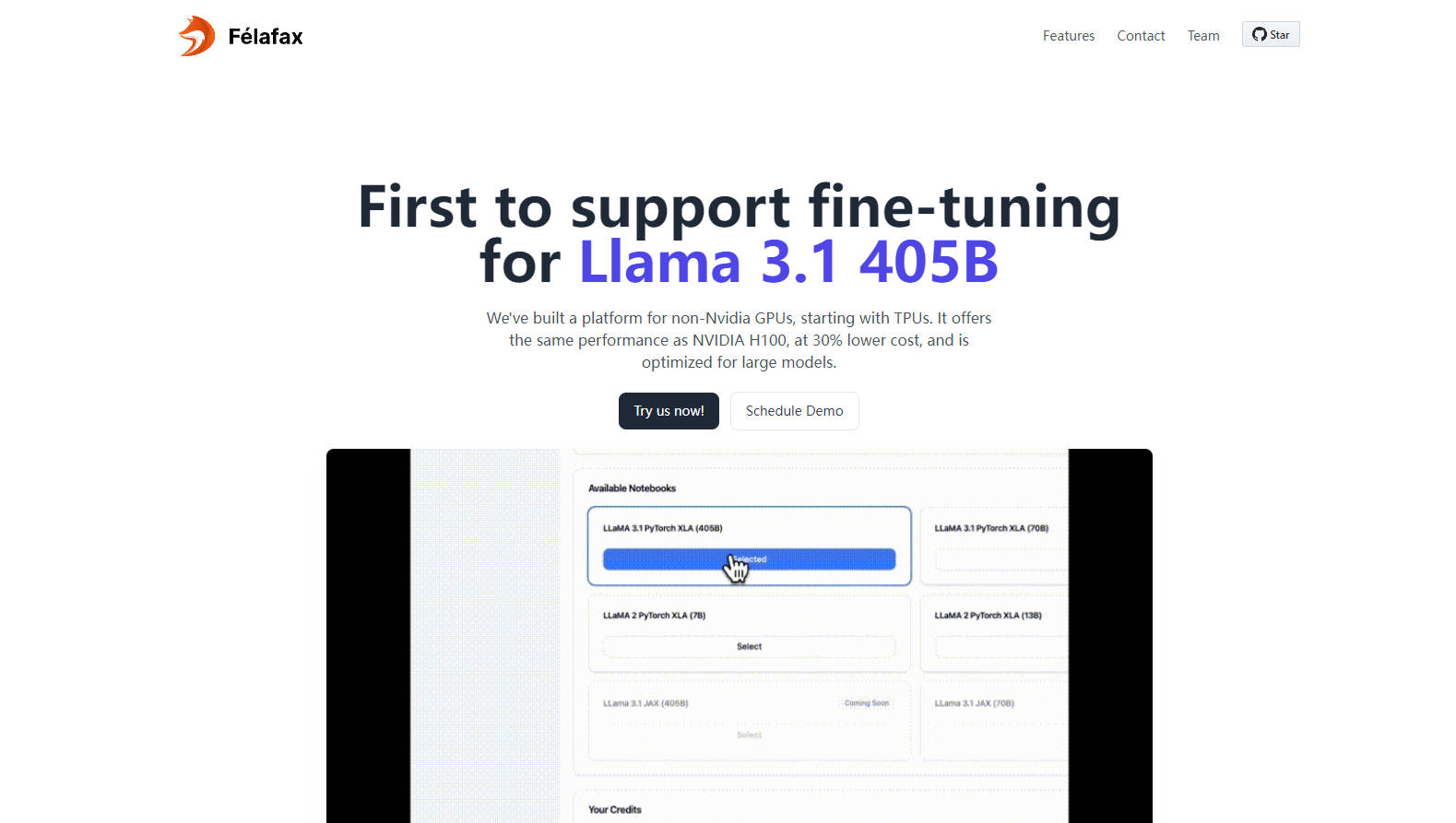

Personnalisation et contrôle complets - Accédez à des environnements de bloc-notes Jupyter entièrement personnalisables pour des exécutions d'entraînement sur mesure, garantissant un contrôle total et zéro compromis.

Partitionnement et orchestration avancés du modèle - Optimisé pour Llama 3.1 405B, Felafax gère le partitionnement du modèle, les points de contrôle distribués et l'entraînement multi-contrôleurs pour une simplicité inégalée.

Environnements préconfigurés et intégration JAX à venir - Choisissez entre Pytorch XLA ou JAX avec toutes les dépendances préinstallées, prêtes à l'emploi, et prévoyez un entraînement 25 % plus rapide avec l'implémentation JAX.

Cas d'utilisation :

Projets de machine learning entrepreneuriaux : Les startups qui se lancent dans des projets d'IA peuvent désormais obtenir des résultats de pointe sur les TPU sans les frais généraux ni les dépenses liés au matériel NVIDIA.

Établissements d'enseignement : Les universités bénéficient d'une solution rentable pour les besoins de calcul haute performance, favorisant la recherche et l'éducation dans les modèles d'IA complexes.

Entreprises qui mettent l'IA à l'échelle : Les multinationales peuvent optimiser le développement et le déploiement de l'IA en tirant parti d'une infrastructure abordable et de haute capacité pour leurs besoins d'ajustement fin du modèle Llama 3.1 405B.

Conclusion :

Felafax est un phare pour la communauté de l'IA, ouvrant la voie à un entraînement rentable et performant sur des GPU non-NVIDIA. Que vous soyez un chercheur, une startup ou une entreprise ayant besoin de solutions d'IA évolutives, Felafax vous invite à découvrir l'avenir de l'ajustement fin du modèle dès aujourd'hui. Découvrez votre crédit de 200 $ et commencez à façonner le paysage de l'IA à votre façon.

FAQ :

Question : Comment Felafax parvient-il à un coût inférieur de 30 % par rapport aux performances du NVIDIA H100 ?

Réponse : Felafax utilise un framework XLA personnalisé, non-CUDA, qui optimise l'entraînement sur des GPU alternatifs, tels que les TPU, AWS Trainium, AMD GPU et Intel GPU, garantissant des performances égales à des coûts considérablement réduits.

Question : À quoi puis-je utiliser Felafax dès maintenant ?

Réponse : Actuellement, Felafax offre une configuration transparente de la couche cloud pour les clusters d'entraînement de l'IA, des environnements adaptés pour Pytorch XLA et JAX, et un ajustement fin simplifié pour les modèles Llama 3.1. Restez à l'écoute pour l'implémentation de JAX à venir !

Question : Felafax peut-il gérer les grands modèles comme Llama 405B ?

Réponse : Oui, Felafax est optimisé pour les grands modèles, y compris Llama 3.1 405B, gérant le partitionnement du modèle, les points de contrôle distribués et l'orchestration de l'entraînement pour faciliter les complexités des tâches multi-GPU.

More information on Felafax

Top 5 Countries

Traffic Sources

Felafax Alternatives

Plus Alternatives-

-

-

-

Boostez vos projets d'IA générative avec PeriFlow de FriendliAI. Moteur de service LLM le plus rapide, options de déploiement flexibles, approuvé par les leaders de l'industrie.

-

LLaMA Factory est un framework open source de réglage fin de modèles volumineux à faible code qui intègre les techniques de réglage fin largement utilisées dans l'industrie et prend en charge le réglage fin sans code des grands modèles via l'interface Web UI.