What is Felafax?

Felafax меняет ландшафт обучения ИИ, оптимизируя тонкую настройку модели Llama 3.1 405B на не-NVIDIA GPU, в частности TPU, с значительно более низкой стоимостью. Эта передовая платформа упрощает настройку и управление крупномасштабными учебными кластерами, используя собственную архитектуру XLA для соответствия производительности NVIDIA H100 с сокращением расходов на 30%. Предназначенная для предприятий и стартапов, Felafax вводит простую оркестровку для сложных задач с несколькими GPU, дополненную предварительно настроенными средами и обещанием скорой реализации JAX для еще большей эффективности.

Ключевые особенности:

Учебные кластеры большого размера одним щелчком мыши - мгновенно создавайте масштабируемые учебные кластеры от 8 до 1024 не-NVIDIA GPU, с бесшовной оркестровкой для любого размера модели.

Непревзойденная производительность и рентабельность - используя собственную не-CUDA XLA-платформу, Felafax обеспечивает производительность, эквивалентную NVIDIA H100, с сокращением затрат на 30%, что идеально подходит для больших моделей.

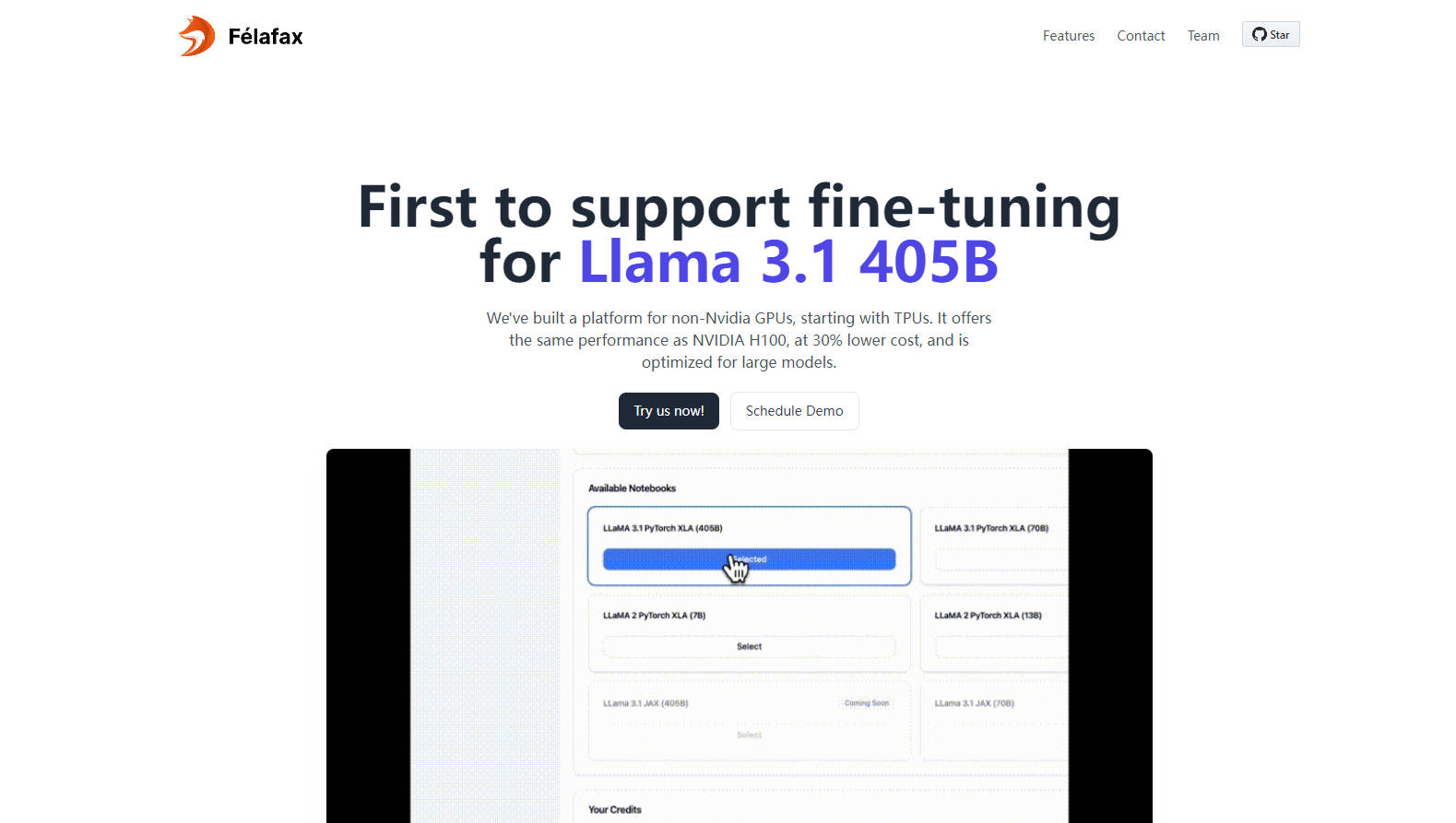

Полная настройка и контроль - получите доступ к полностью настраиваемым средам Jupyter Notebook для индивидуальных учебных запусков, гарантируя полный контроль и отсутствие компромиссов.

Расширенное разбиение и оркестровка моделей - оптимизированная для Llama 3.1 405B, Felafax управляет разбиением модели, распределенными контрольными точками и обучением с несколькими контроллерами для беспрецедентной простоты.

Предварительно настроенные среды и грядущая интеграция JAX - выбирайте между Pytorch XLA или JAX со всеми предварительно установленными зависимостями, готовыми к немедленному использованию, и ожидайте ускорения обучения на 25% с реализацией JAX.

Сферы применения:

Стартап-проекты в области машинного обучения: Стартапы, начинающие проекты в области искусственного интеллекта, теперь могут достигать передовых результатов на TPU без накладных расходов или затрат на оборудование NVIDIA.

Учебные заведения: Университеты получают экономичное решение для потребностей в высокопроизводительных вычислениях, способствуя исследованиям и образованию в области сложных моделей искусственного интеллекта.

Предприятия, масштабирующие ИИ: Транснациональные корпорации могут оптимизировать разработку и развертывание ИИ, используя доступную инфраструктуру с высокой пропускной способностью для своих потребностей в тонкой настройке модели Llama 3.1 405B.

Заключение:

Felafax является маяком для сообщества искусственного интеллекта, являясь пионером в области экономичного, высокопроизводительного обучения на не-NVIDIA GPU. Будь вы исследователем, стартапом или предприятием, нуждающимся в масштабируемых решениях в области искусственного интеллекта, Felafax приглашает вас испытать будущее тонкой настройки моделей уже сегодня. Ознакомьтесь с вашим кредитом в размере $200 и начните формировать ландшафт искусственного интеллекта на своих условиях.

Часто задаваемые вопросы:

Вопрос: Как Felafax достигает 30% более низкой стоимости по сравнению с производительностью NVIDIA H100?

Ответ: Felafax использует собственную не-CUDA XLA-платформу, которая оптимизирует обучение на альтернативных GPU, таких как TPU, AWS Trainium, AMD GPU и Intel GPU, обеспечивая равную производительность при значительно сниженных затратах.

Вопрос: Для чего я могу использовать Felafax прямо сейчас?

Ответ: В настоящее время Felafax предлагает бесшовную настройку облачного слоя для учебных кластеров искусственного интеллекта, специализированные среды для Pytorch XLA и JAX, а также упрощенную тонкую настройку для моделей Llama 3.1. Следите за обновлениями, скоро выйдет реализация JAX!

Вопрос: Может ли Felafax обрабатывать большие модели, такие как Llama 405B?

Ответ: Да, Felafax оптимизирован для больших моделей, включая Llama 3.1 405B, управляет разбиением модели, распределенными контрольными точками и оркестровкой обучения, чтобы упростить сложности задач с несколькими GPU.

More information on Felafax

Top 5 Countries

Traffic Sources

Felafax Альтернативи

Больше Альтернативи-

-

-

-

Ускорьте свои проекты в области генеративного ИИ с помощью PeriFlow от FriendliAI. Быстрейший движок для обслуживания больших языковых моделей (LLM), гибкие варианты развертывания, используется ведущими отраслевыми компаниями.

-

LLaMA Factory — это платформа с открытым исходным кодом для дообучения больших языковых моделей с минимальным количеством кода. Она объединяет в себе популярные методы дообучения, используемые в отрасли, и поддерживает дообучение моделей без кода через веб-интерфейс.