What is Felafax?

Felafax 颠覆了 AI 训练领域,通过优化 Llama 3.1 405B 模型在非 NVIDIA GPU(特别是 TPU)上的微调,以显著更低的成本实现。这个尖端平台简化了大规模训练集群的设置和管理,利用定制的 XLA 架构,以 30% 的成本降低匹配 NVIDIA H100 的性能。Felafax 专为企业和初创公司打造,为复杂的多个 GPU 任务引入了轻松的编排,并通过预配置环境和即将推出的 JAX 实现承诺,以实现更高的效率。

主要功能:

一键式大型训练集群 - 立即创建可扩展的训练集群,从 8 到 1024 个非 NVIDIA GPU 芯片,并为任何模型大小提供无缝编排。

无与伦比的性能和成本效益 - 利用定制的非 CUDA XLA 框架,Felafax 以 30% 的成本降低提供与 NVIDIA H100 相当的性能,非常适合大型模型。

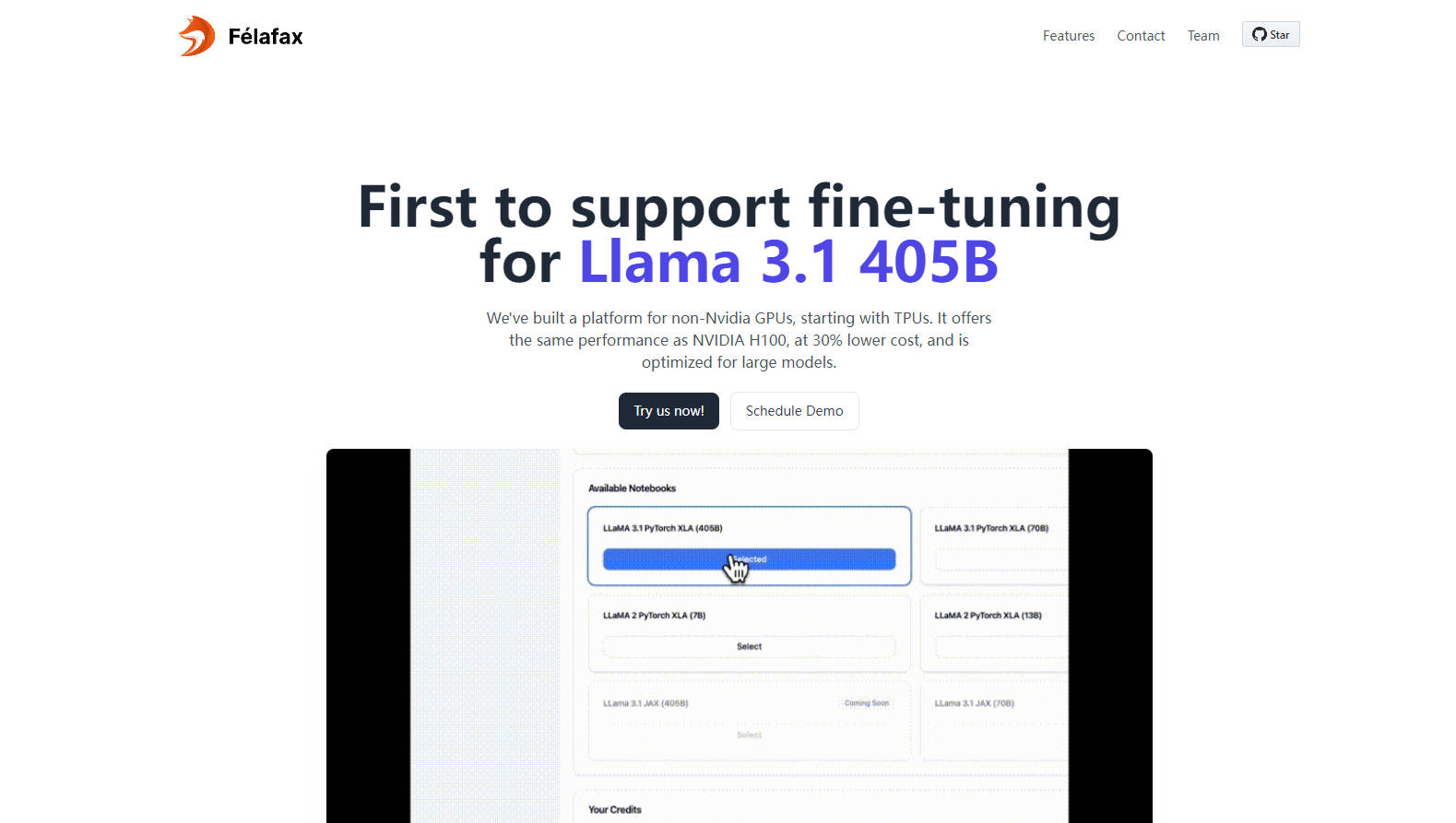

完全定制和控制 - 访问完全可定制的 Jupyter 笔记本环境,以进行定制的训练运行,确保完全控制且零妥协。

高级模型分区和编排 - Felafax 针对 Llama 3.1 405B 进行了优化,管理模型分区、分布式检查点和多控制器训练,以实现无与伦比的轻松体验。

预配置的环境和即将推出的 JAX 集成 - 在 Pytorch XLA 或 JAX 之间进行选择,所有依赖项都已预安装,可立即使用,并预计 JAX 实现将使训练速度提高 25%。

用例:

创业机器学习项目:现在,正在进行 AI 项目的初创公司可以在 TPU 上实现最先进的结果,而无需 NVIDIA 硬件的开销或成本。

学术机构:大学获得了经济高效的解决方案,用于满足高性能计算需求,从而推动复杂 AI 模型的研究和教育。

扩展 AI 的企业:跨国公司可以通过利用负担得起的高容量基础设施来优化 AI 开发和部署,以满足其 Llama 3.1 405B 模型微调需求。

结论:

Felafax 是 AI 社区的灯塔,开创了在非 NVIDIA GPU 上进行经济高效、高性能训练的先河。无论您是研究人员、初创公司还是需要可扩展 AI 解决方案的企业,Felafax 都邀请您体验模型微调的未来。发现您的 $200 信用额度,并开始按照您的条件塑造 AI 领域。

常见问题解答:

问题:Felafax 如何实现比 NVIDIA H100 性能低 30% 的成本?

答案:Felafax 利用定制的非 CUDA XLA 框架,优化在替代 GPU(如 TPU、AWS Trainium、AMD GPU 和 Intel GPU)上的训练,确保以大幅降低的成本实现同等性能。

问题:我现在可以使用 Felafax 做什么?

答案:目前,Felafax 为 AI 训练集群提供无缝的云层设置,为 Pytorch XLA 和 JAX 提供定制的环境,并简化了 Llama 3.1 模型的微调。敬请期待即将推出的 JAX 实现!

问题:Felafax 可以处理像 Llama 405B 这样的大型模型吗?

答案:是的,Felafax 针对大型模型(包括 Llama 3.1 405B)进行了优化,管理模型分区、分布式检查点和训练编排,以简化多 GPU 任务的复杂性。