What is nanochat?

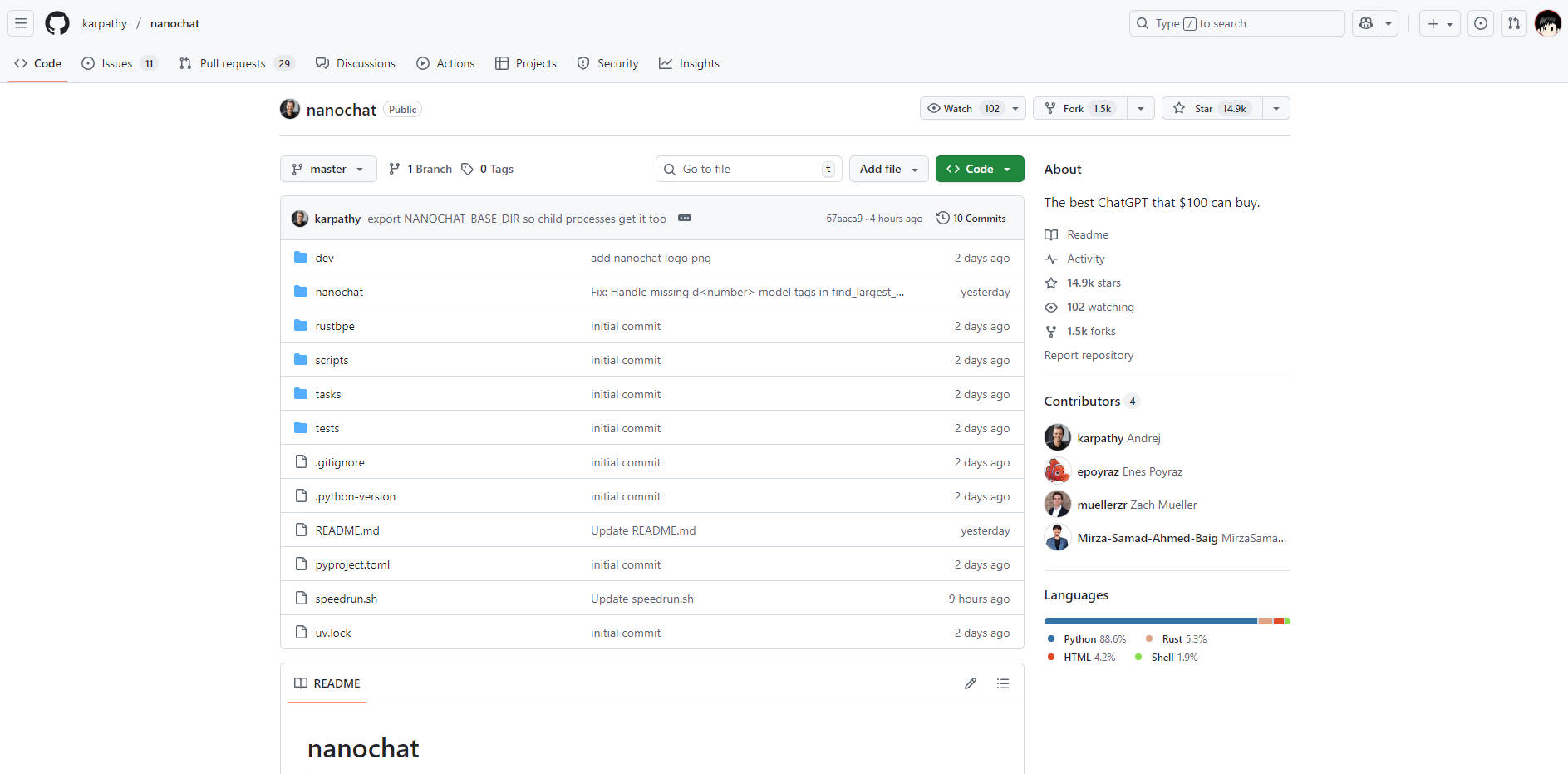

nanochat es una implementación completa, mínima y altamente accesible de un Modelo de Lenguaje Grande (LLM) moderno, diseñada para desarrolladores e investigadores. Aborda la complejidad y el coste prohibitivo típicamente asociados con el desarrollo de LLMs al encapsular toda la pipeline —desde la tokenización hasta una interfaz de usuario web funcional— en aproximadamente 1000 líneas de código limpio y adaptable. Para cualquiera que busque dominar el stack de LLMs construyendo y ejecutando su propio modelo de principio a fin, nanochat ofrece un entorno de aprendizaje y prototipado sin igual.

Características Clave

nanochat está diseñado para una comprensión integral y una accesibilidad total, permitiéndote controlar cada fase del ciclo de vida del LLM en un sistema compacto y dedicado.

🛠️ Integración de Pipeline de Principio a Fin

A diferencia de los frameworks que abstraen componentes críticos, nanochat ofrece una implementación full-stack que abarca tokenización, preentrenamiento, ajuste fino (finetuning), evaluación, inferencia y una interfaz web sencilla. Este diseño cohesivo asegura que puedas ejecutar todo el proceso utilizando un único script automatizado (speedrun.sh), proporcionando resultados inmediatos y verificables.

💡 Código Base Mínimo y Adaptable

Toda la implementación reside en una base de código con pocas dependencias de aproximadamente 1000 líneas (utilizando Python, Rust, HTML y Shell). Esta arquitectura mínima reduce drásticamente la carga cognitiva, permitiendo a los desarrolladores leer, comprender y modificar cada componente del sistema sin tener que navegar por objetos de configuración masivos o patrones de fábrica complejos.

💰 Despliegue Asequible en Nodo Único

Logra el entrenamiento y despliegue completo de un LLM en un único nodo 8XH100 por menos de $1000. El modelo del nivel de $100 , por ejemplo, puede ser entrenado e inferido en unas cuatro horas, haciendo que la experimentación con LLMs a gran escala sea accesible con un presupuesto práctico. Esta eficiencia se logra mediante una gestión cuidadosa de los recursos y un código optimizado, evitando la necesidad de un gasto de capital multimillonario.

📈 Niveles de Rendimiento Escalables

Aunque la ejecución por defecto (speedrun) ofrece un modelo fundacional (~4e19 FLOPs) para prueba de concepto, nanochat está estructurado para escalar. Los desarrolladores pueden pasar a modelos más grandes y capaces (como el nivel de ~$300 , que supera ligeramente la puntuación CORE de GPT-2) simplemente ajustando algunos parámetros como la profundidad del modelo y gestionando la memoria a través del tamaño de lote del dispositivo.

Casos de Uso

nanochat está diseñado para transformar el conocimiento teórico en modelos tangibles y ejecutables, lo que lo hace ideal tanto para la educación como para el desarrollo rápido.

1. Dominando el Stack de LLMs

Si eres un desarrollador que busca ir más allá de las llamadas a API de caja negra y comprender genuinamente la mecánica de los modelos de lenguaje grandes, nanochat es tu laboratorio. Al ejecutar el script completo de la pipeline, serás testigo de todo el proceso de entrenamiento —desde los datos brutos hasta una interfaz de usuario web conversacional— lo que permite un dominio profundo y práctico de los principios y algoritmos subyacentes.

2. Prototipado e Iteración Rápidos

Utiliza la base de código mínima para probar rápidamente modificaciones en la arquitectura del modelo, técnicas de optimización o métodos novedosos de ajuste fino. Dado que todo el stack está contenido y es fácilmente ejecutable en un solo nodo, puedes reducir drásticamente el tiempo del ciclo de desarrollo típico requerido para validar nuevas ideas en el ámbito de los LLMs.

3. Construcción de Micromodelos Altamente Especializados

Aprovecha la eficiencia de nanochat para crear modelos personalizados y más pequeños, adaptados a tareas de dominio específicas o aplicaciones internas. La capacidad de ejecutar la pipeline completa de entrenamiento y ajuste fino de manera rentable permite a las organizaciones desarrollar micromodelos propietarios sin invertir en una infraestructura de aprendizaje automático extensa y dedicada.

Ventajas Únicas

La propuesta de valor de nanochat reside en su equilibrio único entre completitud, accesibilidad y eficiencia de costes, ofreciendo una alternativa clara a los frameworks de LLMs excesivamente complejos.

Accesibilidad Cognitiva Inigualable: El enfoque intencional en una base de código mínima significa que no hay objetos de configuración complejos y laberínticos ni "monstruos de if-then-else". El código está diseñado para ser una "base sólida" que es legible, cohesiva y maximamente "forkeable" (permitiendo bifurcaciones), reduciendo drásticamente el tiempo necesario para que un desarrollador logre una comprensión completa del sistema.

Métricas y Evaluación Verificables: Cada ejecución produce un archivo

report.mdexhaustivo que contiene métricas de evaluación detalladas (por ejemplo, puntuaciones de ARC-Challenge, MMLU, GSM8K). Este compromiso con resultados medibles asegura que puedas rastrear científicamente el rendimiento y el impacto de tus modificaciones y ejecuciones de entrenamiento.Diseñado para Aprender Haciendo: Como proyecto final para LLM101n, nanochat está fundamentalmente diseñado como una herramienta educativa. Toma la complejidad del desarrollo moderno de LLMs y la destila en un proyecto alcanzable y ejecutable, asegurando que la curva de aprendizaje sea pronunciada en conocimiento adquirido, no en frustración por la configuración.

Conclusión

nanochat ofrece una vía directa y potente para que los desarrolladores logren una verdadera comprensión y maestría en la implementación de modelos de lenguaje grandes. Al ejecutar todo el stack con un presupuesto accesible, obtendrás una visión profunda de cada fase de la creación de LLMs.

Explora el repositorio de nanochat hoy mismo y empieza a construir el mejor clon de ChatGPT que tu presupuesto pueda permitir.

More information on nanochat

nanochat Alternativas

Más Alternativas-

-

-

LM Studio es una aplicación de escritorio fácil de usar para experimentar con Modelos de Lenguaje Grandes (LLMs) locales y de código abierto. La aplicación de escritorio multiplataforma LM Studio permite descargar y ejecutar cualquier modelo compatible con ggml de Hugging Face, y proporciona una interfaz de usuario (UI) sencilla pero potente para la configuración e inferencia de modelos. La aplicación aprovecha tu GPU cuando es posible.

-

-