What is nanochat?

nanochat est une implémentation complète, minimale et hautement accessible d'un Grand Modèle de Langage (LLM) moderne, conçue pour les développeurs et les chercheurs. Il s'attaque à la complexité et au coût prohibitif habituellement associés au développement de LLM en encapsulant l'intégralité du pipeline — de la tokenisation à une interface utilisateur web fonctionnelle — en environ 1000 lignes de code propre et facilement modifiable. Pour quiconque cherche à maîtriser l'ensemble de la pile LLM en construisant et en exécutant son propre modèle de bout en bout, nanochat offre un environnement d'apprentissage et de prototypage sans précédent.

Fonctionnalités Clés

nanochat est conçu pour une compréhension approfondie et une accessibilité optimale, vous permettant de contrôler chaque phase du cycle de vie des LLM sur un système compact et dédié.

🛠️ Intégration Complète du Pipeline

Contrairement aux frameworks qui masquent les composants critiques, nanochat propose une implémentation complète couvrant la tokenisation, le pré-entraînement, le finetuning, l'évaluation, l'inférence et une interface web simple. Cette conception cohérente garantit que vous pouvez exécuter l'ensemble du processus à l'aide d'un unique script automatisé (speedrun.sh), fournissant des résultats immédiats et vérifiables.

💡 Base de Code Minimaliste et Modifiable

L'intégralité de l'implémentation repose sur une base de code légère en dépendances d'environ 1000 lignes (utilisant Python, Rust, HTML et Shell). Cette architecture minimale réduit drastiquement la charge cognitive, permettant aux développeurs de lire, comprendre et modifier chaque composant du système sans avoir à naviguer dans des objets de configuration massifs ou des schémas de fabrique complexes.

💰 Déploiement Abordable sur un Nœud Unique

Réalisez l'entraînement et le déploiement complets de LLM sur un seul nœud 8XH100 pour moins de 1000 $. Le modèle de la catégorie $100 tier, par exemple, peut être entraîné et inféré en environ quatre heures, rendant l'expérimentation de LLM à grande échelle accessible avec un budget raisonnable. Cette efficacité est obtenue grâce à une gestion rigoureuse des ressources et un code optimisé, évitant ainsi le besoin de dépenses d'investissement de plusieurs millions de dollars.

📈 Niveaux de Performance Évolutifs

Alors que le speedrun par défaut offre un modèle fondamental (~4e19 FLOPs) pour une preuve de concept, nanochat est conçu pour être évolutif. Les développeurs peuvent passer à des modèles plus grands et plus performants (tels que la catégorie ~$300 tier, qui surpasse légèrement le score GPT-2 CORE) simplement en ajustant quelques paramètres comme la profondeur du modèle et en gérant la mémoire via la taille de lot par périphérique.

Cas d'Utilisation

nanochat est conçu pour transformer les connaissances théoriques en modèles tangibles et exécutables, le rendant idéal aussi bien pour l'éducation que pour le développement rapide.

1. Maîtriser la Pile LLM

Si vous êtes un développeur souhaitant dépasser les appels d'API « boîte noire » et comprendre réellement la mécanique des grands modèles de langage, nanochat est votre laboratoire. En exécutant le script complet du pipeline, vous assistez à l'intégralité du processus d'entraînement — des données brutes à une interface utilisateur web conversationnelle — permettant une maîtrise pratique et approfondie des principes et algorithmes sous-jacents.

2. Prototypage Rapide et Itération

Utilisez la base de code minimale pour tester rapidement les modifications de l'architecture des modèles, les techniques d'optimisation ou les nouvelles méthodes de finetuning. Étant donné que l'ensemble de la pile est contenu et facilement exécutable sur un nœud unique, vous pouvez réduire drastiquement le temps de cycle de développement typique nécessaire pour valider de nouvelles idées dans l'espace des LLM.

3. Construction de Micro-Modèles Hautement Spécialisés

Tirez parti de l'efficacité de nanochat pour créer des modèles personnalisés et plus petits, adaptés à des tâches spécifiques ou à des applications internes. La capacité d'exécuter l'intégralité du pipeline d'entraînement et de finetuning de manière rentable permet aux organisations de développer des micro-modèles propriétaires sans investir dans une infrastructure d'apprentissage automatique étendue et dédiée.

Avantages Uniques

La proposition de valeur de nanochat réside dans son équilibre unique entre complétude, accessibilité et rentabilité, offrant une alternative claire aux frameworks LLM excessivement complexes.

Accessibilité Cognitive Inégalée : L'accent intentionnel mis sur une base de code minimale signifie qu'il n'y a pas d'objets de configuration complexes et labyrinthiques ni de « monstres if-then-else ». Le code est conçu comme une « base de référence solide », lisible, cohérente et maximalement forkable, réduisant drastiquement le temps nécessaire à un développeur pour atteindre une compréhension complète du système.

Métriques et Évaluation Vérifiables : Chaque exécution produit un fichier

report.mdcomplet contenant des métriques d'évaluation détaillées (par exemple, les scores ARC-Challenge, MMLU, GSM8K). Cet engagement envers des résultats mesurables garantit que vous pouvez suivre scientifiquement la performance et l'impact de vos modifications et de vos exécutions d'entraînement.Conçu pour l'Apprentissage par la Pratique : En tant que projet de synthèse de LLM101n, nanochat est fondamentalement conçu comme un outil pédagogique. Il prend la complexité du développement moderne des LLM et la distille en un projet réalisable et exécutable, garantissant que la courbe d'apprentissage est abrupte en termes de connaissances acquises, et non en frustration de configuration.

Conclusion

nanochat offre une voie directe et puissante aux développeurs pour acquérir une compréhension et une maîtrise réelles de l'implémentation des grands modèles de langage. En exécutant l'intégralité de la pile avec un budget accessible, vous obtenez un aperçu approfondi de chaque phase de la création de LLM.

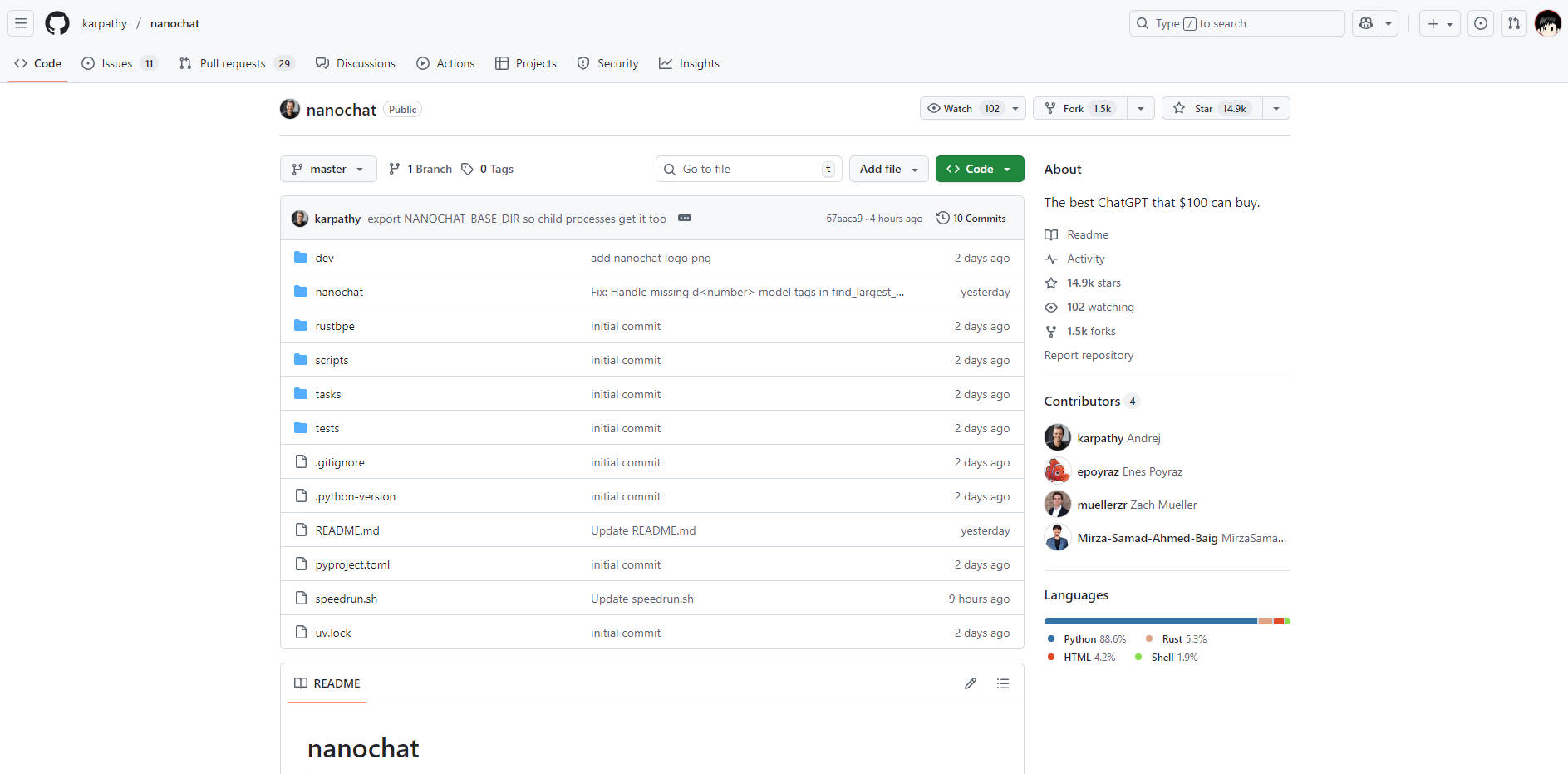

Explorez le dépôt nanochat dès aujourd'hui et commencez à construire le meilleur clone ChatGPT que votre budget puisse se permettre.

More information on nanochat

nanochat Alternatives

Plus Alternatives-

-

-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.

-

-