What is nanochat?

nanochat — это полноценная, минималистичная и легкодоступная реализация современной большой языковой модели (LLM), разработанная для разработчиков и исследователей. Она решает проблему сложности и непомерной стоимости, обычно связанных с разработкой LLM, упаковывая весь конвейер — от токенизации до функционального веб-интерфейса — примерно в 1000 строк чистого, легко модифицируемого кода. Для тех, кто стремится освоить стек LLM, создавая и запуская собственную модель от начала до конца, nanochat предлагает беспрецедентную среду для обучения и прототипирования.

Ключевые особенности

nanochat разработан с учетом всестороннего понимания и доступности, позволяя вам контролировать каждую фазу жизненного цикла LLM на компактной, специализированной системе.

🛠️ Сквозная интеграция конвейера

В отличие от фреймворков, которые абстрагируют критически важные компоненты, nanochat предлагает полнофункциональную реализацию, охватывающую токенизацию, предварительное обучение, дообучение, оценку, вывод (инференс) и простой веб-интерфейс. Такая целостная архитектура гарантирует, что вы можете выполнить весь процесс с помощью единого автоматизированного скрипта (speedrun.sh), обеспечивая немедленные, проверяемые результаты.

💡 Минимальная, легко модифицируемая кодовая база

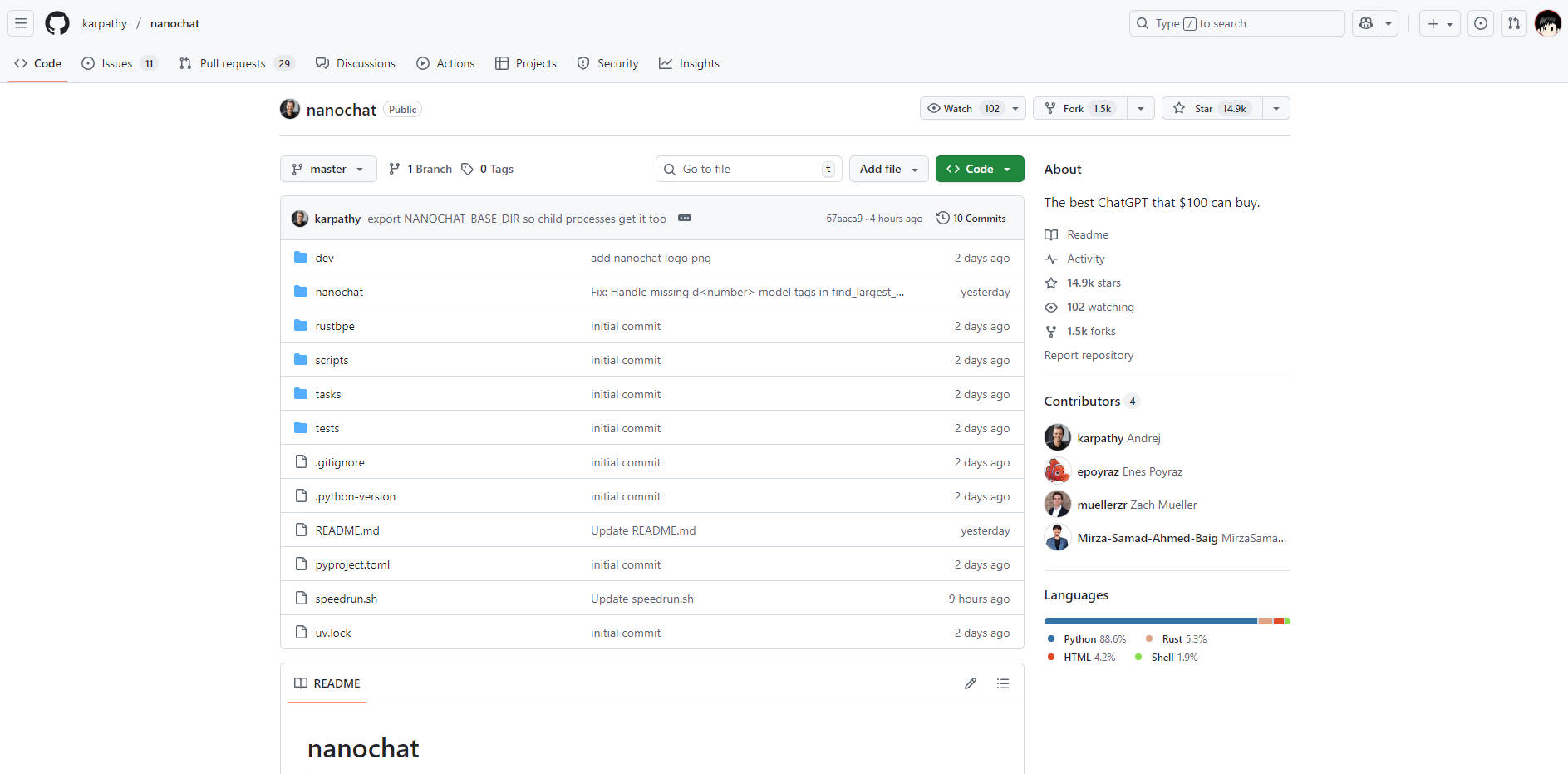

Вся реализация содержится в кодовой базе с минимальными зависимостями объемом около 1000 строк (с использованием Python, Rust, HTML и Shell). Эта минималистичная архитектура значительно снижает когнитивную нагрузку, позволяя разработчикам читать, понимать и модифицировать каждый компонент системы без необходимости разбираться в огромных объектах конфигурации или сложных фабричных паттернах.

💰 Доступное развертывание на одном узле

Осуществите полное обучение и развертывание LLM на одном узле 8XH100 менее чем за 1000 долларов. Например, модель уровня $100 tier может быть обучена, а инференс для нее выполнен примерно за четыре часа, что делает крупномасштабные эксперименты с LLM доступными в рамках разумного бюджета. Такая эффективность достигается за счет тщательного управления ресурсами и оптимизированного кода, избегая необходимости многомиллионных капитальных вложений.

📈 Масштабируемые уровни производительности

Хотя стандартный speedrun предлагает базовую модель (~4e19 FLOPs) для демонстрации концепции, nanochat спроектирован для масштабирования. Разработчики могут переходить к более крупным, мощным моделям (таким как уровень ~$300 tier, который незначительно превосходит GPT-2 CORE score), просто регулируя несколько параметров, таких как глубина модели, и управляя памятью с помощью размера пакета устройства (device batch size).

Варианты использования

nanochat разработан для превращения теоретических знаний в осязаемые, исполняемые модели, что делает его идеальным как для обучения, так и для быстрой разработки.

1. Освоение стека LLM

Если вы разработчик, стремящийся выйти за рамки вызовов API «черного ящика» и по-настоящему понять механику больших языковых моделей, nanochat — это ваша лаборатория. Запуская скрипт полного конвейера, вы становитесь свидетелем всего процесса обучения — от необработанных данных до диалогового веб-интерфейса — что позволяет глубоко, на практике освоить базовые принципы и алгоритмы.

2. Быстрое прототипирование и итерации

Используйте минимальную кодовую базу для быстрого тестирования модификаций архитектуры модели, методов оптимизации или новых подходов к дообучению. Поскольку весь стек содержится в одном месте и легко запускается на одном узле, вы можете значительно сократить типичное время цикла разработки, необходимое для проверки новых идей в области LLM.

3. Создание узкоспециализированных микромоделей

Используйте эффективность nanochat для создания пользовательских, меньших моделей, адаптированных для конкретных доменных задач или внутренних приложений. Возможность экономично запускать полный конвейер обучения и дообучения позволяет организациям разрабатывать собственные микромодели без инвестиций в обширную, специализированную инфраструктуру машинного обучения.

Уникальные преимущества

Ценностное предложение nanochat заключается в его уникальном балансе полноты, доступности и экономической эффективности, предлагая четкую альтернативу чрезмерно сложным фреймворкам LLM.

Непревзойденная когнитивная доступность: Целенаправленный акцент на минимальной кодовой базе означает отсутствие сложных, лабиринтных объектов конфигурации или «монстров из if-then-else». Код разработан как «надежная основа», которая является читаемой, связной и максимально пригодной для форкинга, значительно сокращая время, необходимое разработчику для полного понимания системы.

Проверяемые метрики и оценка: Каждый запуск генерирует исчерпывающий файл

report.md, содержащий подробные метрики оценки (например, показатели ARC-Challenge, MMLU, GSM8K). Эта приверженность измеримым результатам гарантирует возможность научно отслеживать производительность и влияние ваших модификаций и циклов обучения.Разработано для обучения на практике: Будучи дипломным проектом для LLM101n, nanochat изначально разработан как образовательный инструмент. Он берет сложность современной разработки LLM и превращает ее в достижимый, запускаемый проект, гарантируя, что кривая обучения крута в плане приобретенных знаний, а не разочарования от настройки.

Заключение

nanochat предлагает разработчикам прямой, мощный путь к достижению истинного понимания и мастерства в реализации больших языковых моделей. Запуская весь стек в рамках доступного бюджета, вы получаете глубокое понимание каждой фазы создания LLM.

Изучите репозиторий nanochat сегодня и начните создавать лучший клон ChatGPT, который может позволить ваш бюджет.

More information on nanochat

nanochat Альтернативи

Больше Альтернативи-

-

-

LM Studio — это удобное настольное приложение для экспериментов с локальными и открытыми большими языковыми моделями (LLM). Кроссплатформенное настольное приложение LM Studio позволяет скачивать и запускать любую ggml-совместимую модель с Hugging Face, а также предоставляет простой, но мощный пользовательский интерфейс для настройки моделей и выполнения инференса. Приложение задействует ваш GPU по возможности.

-

-